Google-CEO Sundar Pichai gab auf einer Pressekonferenz die Open-Source-Veröffentlichung des neuesten multimodalen großen Sprachmodells Gemma-3 bekannt. Das Modell zeichnet sich durch seine niedrigen Kosten und hohe Leistung aus und genießt große Aufmerksamkeit.

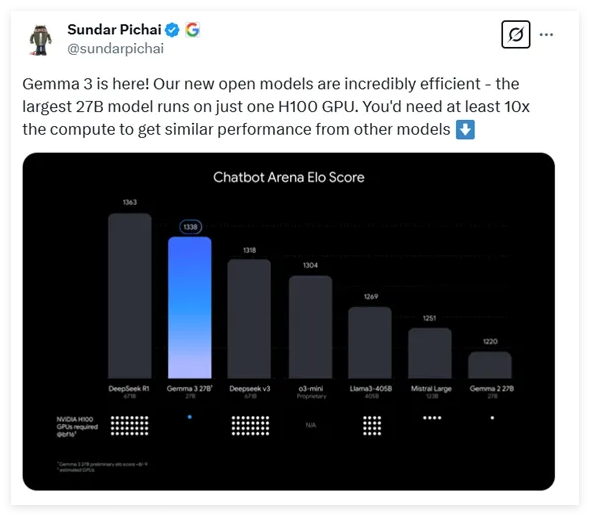

Gemma-3 bietet vier verschiedene Größen mit 1, 4, 12 und 27 Milliarden Parametern an. Überraschenderweise benötigt das größte Modell mit 27 Milliarden Parametern nur eine einzige H100-Grafikkarte für effizientes Inferencing, während vergleichbare Modelle oft die zehnfache Rechenleistung benötigen. Dies macht Gemma-3 zu einem der derzeit leistungsstärksten Modelle mit dem geringsten Rechenleistungsbedarf.

Laut neuesten Testdaten schneidet Gemma-3 in Vergleichen verschiedener Dialogmodelle hervorragend ab und liegt nur knapp hinter dem bekannten DeepSeek-Modell. Es übertrifft mehrere beliebte Modelle wie OpenAIs o3-mini und Llama3.

Die Architektur von Gemma-3 basiert, wie seine Vorgänger, auf dem universellen Decoder-Transformer-Design, enthält aber zahlreiche Innovationen und Optimierungen. Um Speicherprobleme durch lange Kontexte zu lösen, verwendet Gemma-3 eine Architektur, die lokale und globale Selbstaufmerksamkeits-Layer abwechselnd einsetzt, wodurch der Speicherbedarf deutlich reduziert wird.

In Bezug auf die Kontextverarbeitungsfähigkeit unterstützt Gemma-3 eine Kontextlänge von bis zu 128.000 Tokens, wodurch die Verarbeitung langer Texte verbessert wird. Darüber hinaus verfügt Gemma-3 über multimodale Fähigkeiten und kann sowohl Text als auch Bilder verarbeiten. Es integriert einen auf VisionTransformer basierenden visuellen Encoder, der die Rechenkosten für die Bildverarbeitung effektiv reduziert.

Während des Trainings wurde ein größeres Token-Budget verwendet, insbesondere beim Modell mit 27 Milliarden Parametern mit 14 Billionen Tokens. Zusätzlich wurden mehrsprachige Daten einbezogen, um die Sprachverarbeitungsfähigkeiten des Modells zu verbessern. Es unterstützt 140 Sprachen, wobei 35 Sprachen direkt verwendet werden können. Gemma-3 verwendet fortschrittliche Wissensdestillationstechniken und optimiert die Modellleistung in der späten Trainingsphase durch Reinforcement Learning, insbesondere in Bezug auf Hilfreichkeit, Inferenzfähigkeit und mehrsprachige Fähigkeiten.

Tests zeigen, dass Gemma-3 bei multimodalen Aufgaben hervorragende Ergebnisse erzielt und auch die Verarbeitung langer Texte mit einer Genauigkeit von 66 % beeindruckend ist. Auch bei der Bewertung der Dialogfähigkeit gehört Gemma-3 zu den Spitzenreitern, was seine umfassende Leistungsfähigkeit in verschiedenen Aufgaben unterstreicht.

Adresse: https://huggingface.co/collections/google/gemma-3-release-67c6c6f89c4f76621268bb6d

Wichtigste Punkte:

🔍 Gemma-3 ist Googles neuestes Open-Source-Multimodal-Großsprachmodell mit einer Parameteranzahl von 1 bis 27 Milliarden und einem um das Zehnfache reduzierten Rechenleistungsbedarf.

💡 Das Modell verwendet ein innovatives Architekturdesign zur effizienten Verarbeitung langer Kontexte und multimodaler Daten, einschließlich gleichzeitiger Text- und Bildverarbeitung.

🌐 Gemma-3 unterstützt die Verarbeitung von 140 Sprachen und zeigt nach Training und Optimierung in verschiedenen Aufgaben eine hervorragende Leistung und umfassende Fähigkeiten.