Auf der GTC2025-Konferenz hat Nvidia seine nächste Generation von KI-Chips offiziell vorgestellt und sie nach der berühmten amerikanischen Astronomin Vera Rubin „Vera Rubin“ genannt. Dies setzt die Tradition von Nvidia fort, seine Architekturen nach Wissenschaftlern zu benennen. Das erste Produkt dieser Serie, Vera Rubin NVL144, soll voraussichtlich im zweiten Halbjahr 2026 erscheinen.

Nvidia-CEO Jensen Huang erklärte, dass die Leistung von Rubin die der aktuellen Hopper-Architektur um das 900-fache übertreffen wird. Zum Vergleich: Die neueste Blackwell-Architektur bietet bereits eine 68-fache Leistungssteigerung gegenüber Hopper, was darauf hindeutet, dass Rubin einen weiteren gewaltigen Leistungssprung bringen wird.

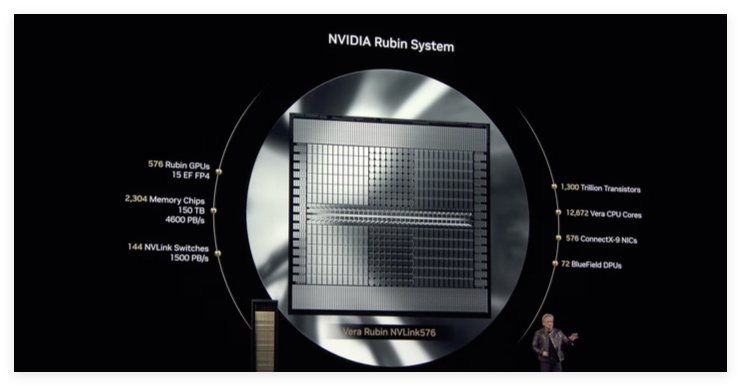

Laut offiziellen Angaben erreicht Vera Rubin NVL144 eine Inferenzleistung von 3,6 ExaFLOPS bei FP4-Genauigkeit und eine Trainingsleistung von 1,2 ExaFLOPS bei FP8-Genauigkeit. Im Vergleich zu GB300NVL72 bedeutet dies eine Leistungssteigerung um das 3,3-fache. Rubin wird mit dem neuesten HBM4-Speicher ausgestattet sein, der eine beeindruckende Bandbreite von 13 TB/s bietet, sowie mit 75 TB schnellen Speichers – das 1,6-fache des Vorgängers. In Bezug auf die Vernetzung unterstützt Rubin NVLink6 und CX9 mit Bandbreiten von 260 TB/s bzw. 28,8 TB/s – jeweils das Doppelte der Vorgängergeneration.

Die Standardversion des Rubin-Chips wird mit HBM4-Speicher ausgestattet sein und eine deutlich höhere Gesamtleistung als der aktuelle Spitzenreiter Hopper H100 bieten.

Erwähnenswert ist auch die Einführung der neuen CPU namens Veru, die Nachfolgerin der Grace CPU. Veru enthält 88 kundenspezifische Arm-Kerne, jeder Kern unterstützt 176 Threads, und über NVLink-C2C wird eine Hochgeschwindigkeitsverbindung mit 1,8 TB/s ermöglicht. Nvidia gibt an, dass die Geschwindigkeit der kundenspezifischen Vera-CPU doppelt so hoch sein wird wie die der in der Grace Blackwell-Chip des letzten Jahres verwendeten CPU.

In Kombination mit der Vera-CPU erreicht Rubin bei Inferenzaufgaben eine Rechenleistung von 50 Petaflops – mehr als das Doppelte der 20 Petaflops von Blackwell. Darüber hinaus unterstützt Rubin bis zu 288 GB HBM4-Speicher, was für Entwickler, die mit großen KI-Modellen arbeiten, von entscheidender Bedeutung ist.

Ähnlich wie Blackwell besteht Rubin aus zwei GPUs, die durch fortschrittliche Packaging-Technologien zu einer Einheit zusammengefasst werden, um die Gesamtrechenleistung und -effizienz zu steigern. Die Veröffentlichung von Rubin zeigt einmal mehr die starke Innovationskraft von Nvidia im Bereich der KI-Chips und das tiefe Verständnis des zukünftigen Bedarfs an Rechenleistung.