Ein Schüler der 12. Klasse hat eine innovative Plattform entwickelt, die es ermöglicht, die Leistung verschiedener KI-Modelle bei der Minecraft-Kreation zu bewerten und so einen neuen Blickwinkel auf das Gebiet der KI-Bewertung bietet.

Neue Benchmark-Methode begegnet den Grenzen traditioneller Bewertungen

Da die Grenzen traditioneller KI-Benchmark-Methoden immer deutlicher werden, suchen Entwickler nach kreativeren Bewertungsmethoden. Für eine Gruppe von Entwicklern erwies sich Mincraft, das Sandbox-Bau-Spiel von Microsoft, als ideale Wahl.

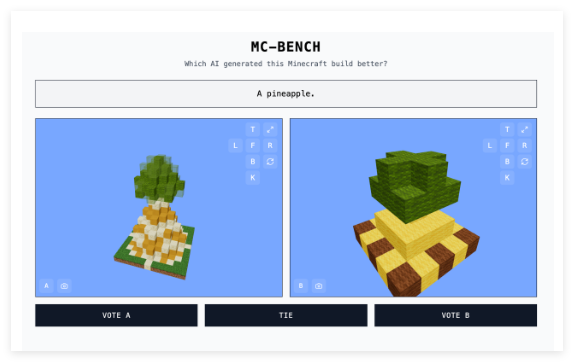

Der Highschool-Schüler Adi Singh hat zusammen mit seinem Team die Website Minecraft Benchmark (kurz MC-Bench) entwickelt. Auf dieser können KI-Modelle in direkten Challenges gegeneinander antreten und auf verschiedene Anweisungen mit Minecraft-Kreationen reagieren. Benutzer können das besser funktionierende Modell wählen; die KI-Ersteller der jeweiligen Werke werden erst nach der Abstimmung angezeigt.

Singh erklärt die Wahl von Minecraft als Testplattform mit seiner großen Bekanntheit – als eines der meistverkauften Videospiele aller Zeiten könne selbst jemand, der es nie gespielt hat, intuitiv beurteilen, welcher Block-Ananas besser aussieht.

"Minecraft macht es den Leuten leichter, den Fortschritt in der KI-Entwicklung zu sehen", sagte Singh gegenüber TechCrunch. "Die Leute sind an Minecraft gewöhnt, an sein Aussehen und seine Atmosphäre."

Projekt erhält Unterstützung von großen KI-Unternehmen

MC-Bench wird derzeit von 8 Freiwilligen unterstützt. Laut Website erhalten sie finanzielle Unterstützung von Anthropic, Google, OpenAI und Alibaba, die die Nutzung ihrer Produkte für die Benchmarks ermöglichen, sind aber ansonsten nicht an dem Projekt beteiligt.

Singh beschreibt die Zukunftsvision des Projekts: "Derzeit erstellen wir nur einfache Bauten und reflektieren den Fortschritt im Vergleich zum Zeitalter von GPT-3. Wir planen aber, auf langfristige Planungen und zielorientierte Aufgaben auszuweiten. Das Spiel dient möglicherweise nur als Medium zum Testen der Schlussfolgerungen von Agenten; es ist sicherer als das reale Leben und leichter zu kontrollieren, was meiner Meinung nach ideal ist."

Neben Minecraft werden auch Spiele wie Pokémon Rot, Street Fighter und Pictionary als KI-Experimentier-Benchmarks verwendet, unter anderem weil KI-Benchmarks selbst eine große Herausforderung darstellen.

Intuitive Bewertung ersetzt komplexe Kennzahlen

Forscher testen KI-Modelle normalerweise in standardisierten Bewertungen, aber diese Tests geben KIs oft einen Heimvorteil. Aufgrund ihrer Trainingsweise sind Modelle von Natur aus in bestimmten Arten von Problemen besser, insbesondere bei Aufgaben, die Gedächtnis oder grundlegende Schlussfolgerungen erfordern.

Dieser Widerspruch zeigt sich in mehreren Beispielen: OpenAIs GPT-4 erreicht 88 % in der LSAT-Prüfung, kann aber nicht genau zählen, wie viele „R“ in „strawberry“ vorkommen; Anthropics Claude 3.7 Sonnet erreicht eine Genauigkeit von 62,3 % in standardisierten Software-Engineering-Benchmarks, schneidet aber beim Pokémon-Spielen schlechter ab als die meisten Fünfjährigen.

Technisch gesehen ist MC-Bench ein Programmier-Benchmark, der erfordert, dass Modelle Code schreiben, um bestimmte Bauten zu erstellen, wie z. B. "Schneemann Frosty" oder "eine charmante tropische Strandhütte an einem unberührten Strand". Für die meisten Benutzer ist es jedoch intuitiver, das Aussehen des Schneemanns zu bewerten, als den Code im Detail zu analysieren. Dies macht das Projekt für ein breiteres Publikum attraktiv und verspricht, mehr Daten über die Leistung der Modelle zu sammeln.

Obwohl die Auswirkungen dieser Punktzahlen auf die Praktikabilität von KI noch diskutiert werden, ist Singh überzeugt, dass dies ein starkes Signal ist: "Die aktuelle Rangliste entspricht meinen eigenen Erfahrungen mit diesen Modellen sehr genau, im Gegensatz zu vielen rein textbasierten Benchmarks. Vielleicht kann MC-Bench Unternehmen helfen zu verstehen, ob sie in die richtige Richtung gehen."