Die größte chinesische KI-Bildgenerierungsplattform LiblibAI hat kürzlich die Integration der Alibaba Tongyi-Serie von großen Sprachmodellen angekündigt, um ihre KI-Kreationsfähigkeiten weiter zu verbessern. Basierend auf dem neuesten Open-Source-Modell Wanxiang hat LiblibAI die Funktionen Text-zu-Video und Bild-zu-Video eingeführt. Benutzer können mit Textprompts oder hochgeladenen Bildern 10-sekündige Kurzvideos erstellen.

Daten zeigen, dass Wanxiang 2.1 (Wan2.1) über 2 Millionen Downloads auf Hugging Face und der Moda-Community verzeichnet und über 8.700 Sterne auf GitHub erhalten hat, was eine starke Marktakzeptanz belegt.

Gleichzeitig hat LiblibAI basierend auf dem Alibaba-Sprachmodell Qwen-turbo ein Fenster zur Optimierung von Prompts entwickelt. Diese Funktion unterstützt Benutzer durch System-Prompts bei der Optimierung ihrer Eingaben und bietet die automatische Übersetzung chinesischer Prompts in für das Modell verständliches Englisch. Nach der Integration von Qwen-turbo hat sich die Optimierungszeit der Prompts bei LiblibAI um über 50 % verkürzt, was die Effizienz und das Benutzererlebnis der KI-Erstellung weiter verbessert.

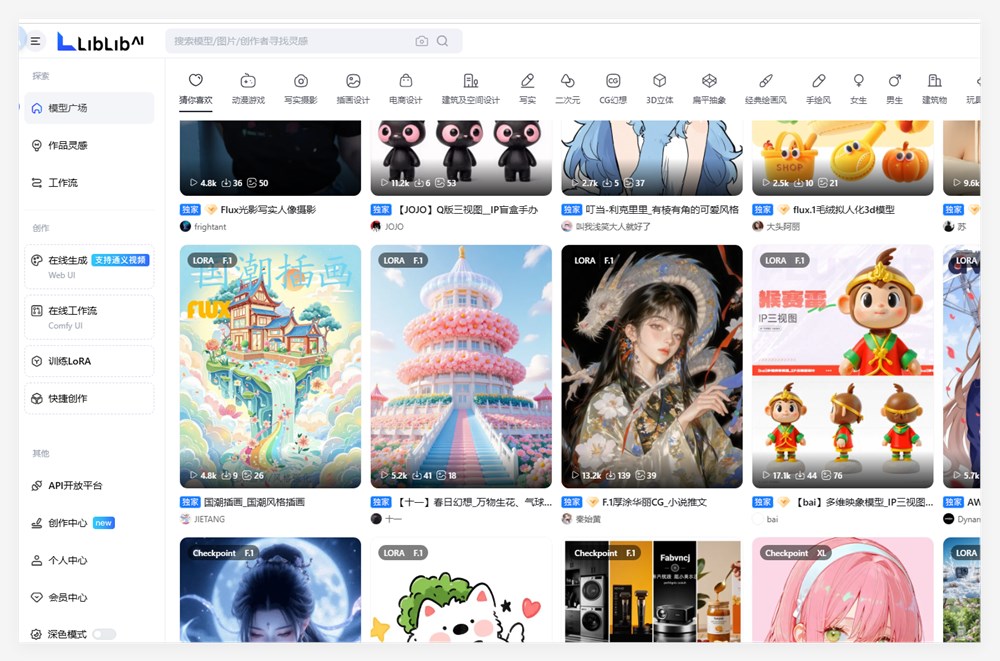

Als erste in China staatlich registrierte KI-Plattform hat LiblibAI über 20 Millionen Kreative und über 100.000 Originalmodelle angesammelt und bietet KI-Bildgenerierungslösungen für zahlreiche Unternehmen und Institutionen wie Tmall Campus, Luckin Coffee und die Tsinghua Universität. Mit dem Plattformmodell „Open-Source-Modelle + modulare Tool-Workflows“ hat LiblibAI eine komplette Ökosystemkette geschaffen, die KI-Inhaltserstellung, -sharing, -copyright-Management und -verkauf umfasst. Bemerkenswert ist, dass die Plattform im vergangenen Jahr vier Finanzierungsrunden abgeschlossen hat, womit ein Rekord für die Finanzierungsgeschwindigkeit im chinesischen KI-Anwendungsbereich aufgestellt wurde. Dies zeigt eine starke Marktkonkurrenzfähigkeit und ein großes Entwicklungspotenzial.