Vierzehn Jahre Branchenerfahrung: Die Welle kommt, wir begegnen ihr. Dieser Artikel beleuchtet unternehmerische Überlegungen und diskutiert Technologie- und Anwendungstrends im Zeitalter der KI. Intern bleiben wir unseren Prinzipien treu und führen, extern nehmen wir wertvolle Erkenntnisse auf und streben nach Perfektion.

Technologischer Wendepunkt: Effizienzspiel zwischen Rechenleistung, Algorithmen und Daten

Durch die rasante Entwicklung großer Sprachmodelle (LLMs) befinden wir uns auf dem Weg zur Künstlichen Superintelligenz (ASI). Reife Big-Data-Technologien liefern KI massenhaft Produktionsfaktoren, die Weiterentwicklung der GPU-Technologie befreit die KI von Produktivitätsengpässen, und Algorithmus-Innovationen überwinden die Grenzen von Rechenleistung und Daten. Mit der fortschreitenden Entwicklung großer Sprachmodelle wie DeepSeek, GPT o1 und Grok in den Bereichen Modellalgorithmen, Trainingsparametern und Rechenleistung stehen wir an einem Scheideweg der KI-Technologie: einem Effizienzspiel zwischen Rechenleistung, Algorithmen und Daten.

Folgt man dem Mooreschen Gesetz, stößt die Rechenleistung als erstes an ihre Effizienzgrenze. Die Ära der auf Rechenleistung basierenden großen Basismodelle geht zu Ende. Dies ist keine „Rechenleistung-Ineffektivitäts-Theorie“. Mehr Parameter und Rechenleistung bedeuten immer bessere Modellleistungen, aber abnehmende Grenzerträge führen zu einer Stabilisierung der Investitionen in die Rechenleistung. Dies zeigt sich deutlich an der Produktentwicklung der aktuellen KI-Giganten: Mit der Einführung von xAI Grok zeigt sich, dass die Effizienzsteigerung durch das Aufstocken der Rechenleistung nachlässt. OpenAI und andere KI-Giganten erforschen nun Anwendungsbereiche wie KI-Agenten und bringen intelligente Agentenprodukte auf den Markt.

Synthetische Daten und private Daten sind die nächsten Durchbruchspunkte für große Sprachmodelle im nächsten Zeitalter. Obwohl wir uns im Zeitalter der Datenexplosion befinden, steht die KI aufgrund der durch Big-Data-Technologien und Algorithmus-Durchbrüche erzielten enormen Steigerung der Datenverarbeitungsleistung vor einem Datenmangel. Schon bei der Markteinführung von ChatGPT warnte Sam Altman: „Wir befinden uns am Ende des aktuellen Zeitalters großer Sprachmodelle.“ Die im Laufe der Geschichte des menschlichen Internets erhalten gebliebenen hochwertigen Datenmengen wurden bereits in GPT-3/4 aufgebraucht. Die Anzahl der Parameter großer Sprachmodelle kann weiter erhöht werden, aber die entsprechenden Mengen an hochwertigen Daten werden immer knapper, daher nimmt der Grenznutzen der Erhöhung der Parameterzahl ab.

Algorithmen sind eher der „Katalysator“ der KI-Entwicklung. Sie können die Einschränkungen von Rechenleistung und Daten überwinden und eine nichtlineare Entwicklung ermöglichen. Durchbrüche im Bereich der Algorithmen bedeuten oft Durchbrüche bei LLMs, wie z. B. ChatGPT mit Transformer und DeepSeek mit MoE. Mit zunehmender Komplexität der Modelle verringert sich jedoch der Spielraum für Algorithmusverbesserungen. Es wird allgemein angenommen, dass Algorithmus-Durchbrüche die Einbeziehung weiterer Ergebnisse aus interdisziplinären Forschungsarbeiten erfordern, z. B. die Inspiration des Deep Learnings durch die Neurowissenschaften und die Inspiration des Aufmerksamkeitsmechanismus durch die Kognitionswissenschaften. Wie viele „Transformer-Momente“ es in Zukunft noch geben wird, ist jedoch schwer vorherzusagen.

Tongfu Shield-Deklaration: Die Entwicklung großer Basismodelle stabilisiert sich im Effizienzspiel zwischen Rechenleistung, Algorithmen und Daten und bildet eine solide Infrastruktur für den Weg zur ASI; technische Ressourcen werden zunehmend auf die Extraktion von Datenwerten in Fachbereichen und die Implementierung von KI-Agenten gelenkt; die „Anwendungsimplementierung“ wird zum dominierenden Thema der nächsten KI-Ära.

Anwendungsexplosion: Multi-Agenten-Zusammenarbeit läutet das Zeitalter der Agenten ein

Die Entwicklung von KI-Agenten ist eine Weiterentwicklung vom „Frage-Antwort-Roboter“ zum „intelligenten Assistenten“. Der Kern von Agenten liegt in der „Aufgabenabwicklung“, wodurch die KI nicht mehr nur Vorschläge liefert, sondern konkrete Aufgaben ausführen kann, z. B. eine Online-Bestellung aufgeben oder eine Transaktion durchführen. Die Entwicklung von einfachen zu komplexen Aufgaben erfordert oft die Zusammenarbeit verschiedener Modelle und verschiedener Agenten. Wir definieren dieses Konzept der „Multi-Agenten-Zusammenarbeit“ als InterAgent (IA). Es ist eine Innovation der technischen Architektur und gleichzeitig eine Umgestaltung des industriellen Anwendungsparadigmas. Wir glauben, dass IA den Übergang der KI von einzelner Intelligenz zu Gruppenarbeit und von Werkzeugunterstützung zu eigenständiger Ausführung vorantreiben und die treibende Kraft für die umfassende Explosion des Agenten-Zeitalters sein wird.

Auf technischer Ebene ermöglicht das MCP-Protokoll von Anthropic die Verknüpfung verschiedener Datenquellen, Modelle und Tools und bietet ein standardisiertes Protokoll für die Multi-Agenten-Zusammenarbeit (IA). MCP (Model Context Protocol) definiert die Art und Weise, wie Anwendungen und Modelle Kontextinformationen austauschen, wodurch die Entwicklung von Agenten einfacher und die Zusammenarbeit mehrerer Agenten konsistenter und effizienter wird. Das MCP-Protokollökosystem befindet sich noch in der frühen Entwicklungsphase. Tongfu Shield, als Anbieter von KI-Agenten-Vertrauensdiensten, beteiligt sich aktiv am Aufbau dieses Ökosystems, implementiert MCP-Server und entwickelt MCP-Funktions-Plugins für die Community, um zum Ausbau des Multi-Agenten-Zusammenarbeit-Ökosystems beizutragen.

Abbildung 1: Tongfu Shield MCP KI-Plugin-Dienst

Auf Anwendungsebene werden die Funktionen von KI-Agenten in der Rolle des „intelligenten Assistenten“ mit der zunehmenden Reife von Agenten-Frameworks wie Dify und elizaOS immer ausgefeilter. Das Auftauchen von Manus hat die Diskussion über „universelle Intelligenzagenten“ ausgelöst. Einerseits zeigt Manus als universeller KI-Assistent in den Beispielen die Fähigkeit, die logischen Schlussfolgerungsfähigkeiten großer Sprachmodelle in tatsächliche Produktivität umzusetzen, was ein enormes Geschäftspotenzial birgt. Andererseits sind angesichts des Fehlens öffentlicher Testkanäle die Echtheit der technischen Innovationen, die Marketingstrategie und die Fähigkeit zur Wertschöpfung von Manus umstritten, insbesondere das von ihm propagierte Konzept des „universellen Agenten“, das im aktuellen Trend der KI-Entwicklung noch erhebliche Einschränkungen aufweist.

Im Vergleich zur universellen, groß angelegten Erzählung von Manus haben Agenten-Anwendungsplattformen wie Dify bereits praktische Anwendungen in verschiedenen Bereichen gefunden, was auf die Kraft der Community-Entwicklung zurückzuführen ist. Im Vergleich zu einem universellen großen Sprachmodell ist ein für bestimmte Anwendungsszenarien spezifischer Arbeitsablauf lebendiger. Diese Lebendigkeit entspringt dem Wesen des Geschäfts – der Wertschöpfung. Stellen Sie sich vor, ein Unternehmen erstellt einen KI-Agenten für die Kundenansprache und den Vertrieb. Um den Gewinn zu maximieren, wird es unbedingt Daten höchster Qualität und die besten Expertenkenntnisse verwenden, um den Agenten zu trainieren. Die durch private Daten und Branchen-Know-how geschaffene Informationsbarriere wird dazu führen, dass seine Leistung weit besser ist als die eines universellen Agentenmodells. Stellen Sie sich einen KI-Agentenmarkt vor, der exzellente Agenten aus allen Bereichen zusammenbringt (da der Markt den Agenten-Erstellern genügend Anreize bietet). Die Agenten konkurrieren auf dem Markt miteinander, und nur Agenten mit besserer Wertschöpfungsfähigkeit können überleben. Exzellente Agenten können mehr Benutzer anziehen, und mehr Benutzer liefern mehr Daten, die den Fortschritt der Agenten weiter vorantreiben und einen positiven Kreislauf bilden.

Abbildung 2: Tongfu Shield Blockchain-basierte KI-Plugin-Plattform (links), KI-Agenten-Plugin-Markt (rechts)

Tongfu Shield-Deklaration: Im Zeitalter der KI-Anwendungen sind Intelligenzagenten (Agenten) der Kern der Anwendung und die Multi-Agenten-Zusammenarbeit (InterAgent oder IA) der technologische Kern; der Aufbau der Infrastruktur für die Unterstützung von Intelligenzagenten wird enorme wirtschaftliche Renditen erzielen, die Schlüsselwörter sind „vertikale Bereiche“, „Community-Anreize“ und „offene Plattformen“.

Die Zukunft der Modelle: Kleine Modelle führen den neuen „Turing-Test“ an

DeepMind-Mitgründer Suleyman schlägt in seinem Werk „Die Welle kommt“ einen neuen „Turing-Test“ für KI vor: Geben Sie einem KI-System 100.000 US-Dollar und sehen Sie, ob es durch Lernen auf Amazon Geschäfte tätigen und schließlich 1 Million US-Dollar verdienen kann. Dies ist ein sehr interessantes Konzept. Im Vergleich zur technischen Basislinie ist für den Benutzer eines KI-Agenten seine Handlungsfähigkeit, d. h. seine Fähigkeit zur Wertschöpfung, wichtiger. Wirtschaftlicher Erfolg ist der neue „Turing-Test“, und dieser Test ist speziell für Agenten konzipiert. Die technologische Entwicklung wird oft durch Geschäftsmodelle vorangetrieben. Wir glauben, dass die zukünftige Entwicklung der Modelltechnologie von großen Basismodellen zu spezialisierten kleinen Modellen in Fachbereichen mit besserer Leistung und höherer Rentabilität führen wird.

Aus technischer Sicht ist das technische Framework für kleine Modelle bereits ausgereift. Anders als allgemein angenommen, stammt die Technologie kleiner Modelle tatsächlich aus einer Zeit vor großen Sprachmodellen. Ihre Ursprünge lassen sich bis auf die Expertensysteme der 1960er Jahre zurückverfolgen. Ihre Kernidee besteht darin, die Entscheidungsfähigkeit menschlicher Experten durch Wissensdatenbanken und Inferenzmechanismen zu simulieren. Das um 2010 viel beachtete MoE-Framework (das auch die Algorithmus-Innovation von DeepSeek direkt inspirierte) ist auch das grundlegende Framework für Expertenmodelle. Durch dynamische Routing-Mechanismen wird die Eingabe auf verschiedene Untermodelle (Experten) verteilt, wodurch bei gleichbleibender Leistung der Rechenaufwand reduziert wird und die Grundlage für ein modulares Design kleiner Modelle geschaffen wird. Die Entwicklung großer Sprachmodelle bietet auch die Möglichkeit, die Qualität kleiner Modelle zu verbessern. Durch Techniken wie Wissensdestillation und Modellbeschneidung können kleine Modelle bei gleichbleibender Leistung ihre Größe deutlich reduzieren.

Aus der Sicht der Geschäftsmodelle ist der Boden für kleine Modelle bereits bereitet. Kleine Modelle zeichnen sich durch eine hohe Effizienz aus. Die Kosten für die Bereitstellung und Inferenz betragen nur einen Bruchteil der Kosten großer Sprachmodelle, aber in Kombination mit Expertenwissensdatenbanken können sie eine deutlich bessere Leistung als große Sprachmodelle erzielen. Dateninseln verleihen Daten einen höheren wirtschaftlichen Wert und Wettbewerbsvorteile. Mit der zunehmenden Kommerzialisierung kleiner Modelle können hochwertige Daten wirklich zu Datenfaktoren werden und Unternehmen neue Geschäftsmodelle und Ertragspotenziale eröffnen.

Es ist erwähnenswert, dass die Kombination aus dezentralen digitalen Identitäten und der Technologie kleiner Modelle im digitalen Raum hochwertige Geschäftsmodelle schaffen kann. Durch kleine Modelle können private Daten aus verschiedenen Bereichen ihren wirtschaftlichen Wert maximieren, und die digitale Identität des Modells wird zum Schlüssel für die Rechte an Datenfaktoren. Die Technologie dezentraler digitaler Identitäten ist derzeit recht ausgereift. Wie man jedem kleinen Modell und jedem KI-Agenten eine vertrauenswürdige Identität oder sogar ein Konto im digitalen Raum verleiht, ist eine zentrale Frage für die Erforschung und Innovation der kommerziellen Anwendung von KI-Agenten.

In einigen bestimmten Bereichen haben kleine Modelle unvergleichliche Wettbewerbsvorteile. In datensensiblen Branchen wie Energie, Rüstung und Medizin müssen Daten lokal verarbeitet oder sogar eine Inferenz am Endgerät durchgeführt werden, was bei großen Sprachmodellen nicht möglich ist. Beispielsweise kann im Bereich der Stromnetze die Verwendung von KI-Agenten in Kombination mit fachspezifischen kleinen Modellen eine intelligentere und benutzerfreundlichere Risikokontrolle ermöglichen. Im Marketingbereich können automatisierte Lead-Generierung, Kampagnenmanagement und präzises Marketing umgesetzt werden. In Bereichen wie dezentraler Photovoltaik und der Verwaltung von Endgeräten kann die Effizienz der Steuerung deutlich gesteigert und die Betriebskosten gesenkt werden. In Branchen wie Finanzrisikokontrolle, Recht und Bildung sind Expertenkenntnisse wertvoll und vertraulich. Lokale Wissensdatenbanken in Kombination mit benutzerdefinierten Arbeitsabläufen können diese Inhalte effektiv vor dem umgekehrten Zugriff durch Benutzer schützen.

Abbildung 3: Tongfu Shield Sicherheitsmatrix für die Zusammenarbeit mehrerer KI-Agenten im Stromnetzgeschäft

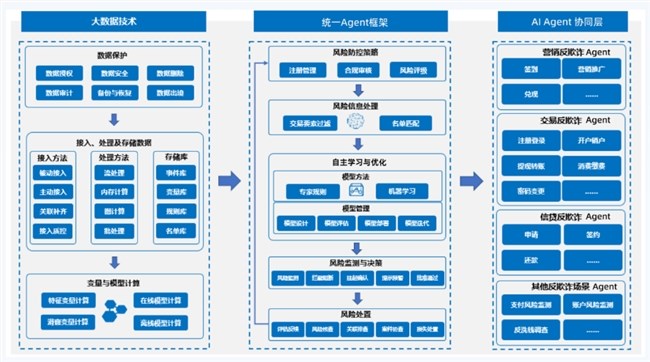

Abbildung 4: Tongfu Shield KI-Agenten-Plattform für intelligentes Risikomanagement im Bankwesen

Tongfu Shield-Deklaration: Wirtschaftlicher Erfolg ist der neue „Turing-Test“, und kleine Modelle sind der beste Weg für KI-Agenten, den neuen „Turing-Test“ zu bestehen. Dezentrales Geschäft und dezentrale Intelligenz werden durch die Entwicklung kleiner Modelle stark profitieren.