Meta hat kürzlich sechs Forschungsarbeiten veröffentlicht, die neue Anwendungen und technologische Durchbrüche im Bereich der KI mit sich bringen. Dazu gehören multimodale Modelle, ein Text-zu-Musik-Modell, eine Audio-Wasserzeichen-Technologie und verschiedene Datensätze. Im Folgenden finden Sie eine detaillierte Übersicht dieser Forschungsergebnisse.

Meta Chameleon („Chamäleon“-Modell)

Das veröffentlichte multimodale Modell „Chameleon“ kann gleichzeitig Text und Bilder verarbeiten und unterstützt sowohl gemischte Eingaben als auch Textausgaben. Es bietet eine völlig neue Lösung für die Verarbeitung multimodaler Daten.

Während die meisten aktuellen Modelle der späten Fusion auf diffusionsbasiertem Lernen beruhen, verwendet Meta Chameleon für Text und Bilder Tokenisierung. Dies ermöglicht einen einheitlicheren Ansatz und macht das Modell einfacher zu entwerfen, zu warten und zu erweitern.

Beispielvideo: Bilderzeugung mit kreativen Titeln oder die Verwendung einer Mischung aus Text- und Bildhinweisen zur Erstellung einer völlig neuen Szene

Derzeit veröffentlicht Meta die Schlüsselkomponenten der Chameleon 7B und 34B Modelle unter einer Forschungslizenz. Die aktuell veröffentlichten Modelle wurden sicherheitstechnisch angepasst, unterstützen gemischte Modus-Eingaben und reine Textausgaben und können für Forschungszwecke verwendet werden. Offiziell wird betont, dass das Chameleon Bilderzeugungsmodell nicht veröffentlicht wird.

Zugang: https://top.aibase.com/tool/meta-chameleon

Multi-Token Prediction (Mehrwortvorhersage)

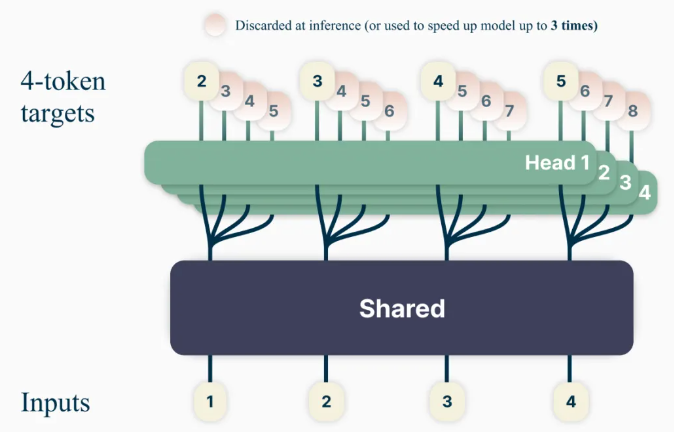

Die neue Methode zum Trainieren von Sprachmodellen „Multi-Token Prediction“ zielt darauf ab, die Modellkapazität und die Trainingseffizienz zu verbessern, indem das Modell trainiert wird, mehrere Wörter gleichzeitig vorherzusagen. Dies erhöht die Vorhersagegenauigkeit des Modells.

Mit dieser Methode können Sprachmodelle trainiert werden, um mehrere zukünftige Wörter gleichzeitig vorherzusagen, anstatt wie bisher jeweils ein Wort. Dies verbessert die Modellkapazität und die Trainingseffizienz und erhöht gleichzeitig die Geschwindigkeit. Im Geiste verantwortungsvoller offener Wissenschaft wird das vortrainierte Modell unter einer nicht-kommerziellen/forschungsbezogenen Lizenz für die Code-Vervollständigung veröffentlicht.

Zugang: https://top.aibase.com/tool/multi-token-prediction

Text-zu-Musik-Modell „JASCO“

Während bestehende Text-zu-Musik-Modelle (wie MusicGen) hauptsächlich auf Texteingaben zur Musikgenerierung angewiesen sind, kann Metas neues Modell „JASCO“ (Joint Audio and Symbolic Conditioning for Time-Controlled Text-to-Music Generation) verschiedene bedingte Eingaben wie spezifische Akkorde oder Beats verarbeiten, um die Kontrolle über die generierte Musik zu verbessern. Konkret können Informationsengpass-Schichten mit zeitlicher Unschärfe kombiniert werden, um Informationen zu extrahieren, die mit einer bestimmten Steuerung zusammenhängen. Dies ermöglicht die gleichzeitige Kombination von symbolischen und audiobasierten Bedingungen in demselben Text-zu-Musik-Generierungsmodell.

JASCO erzielt eine vergleichbare Qualität zur Bewertungsbasislinie und ermöglicht gleichzeitig eine bessere und flexiblere Steuerung der generierten Musik. Die Forschungsarbeit und Beispielseiten werden veröffentlicht. Der Inferenzcode wird später in diesem Monat unter der MIT-Lizenz als Teil des AudioCraft-Repositorys veröffentlicht, und das vortrainierte Modell wird unter CC-BY-NC veröffentlicht.

Zugang: https://top.aibase.com/tool/audiocraft

Audio-Wasserzeichen-Technologie „AudioSeal“

Dies ist die erste Audio-Wasserzeichen-Technologie, die speziell für den lokalen Nachweis von KI-generierter Sprache entwickelt wurde und KI-generierte Segmente in längeren Audioabschnitten präzise lokalisieren kann. AudioSeal verbessert traditionelle Audio-Wasserzeichen, indem es sich auf die Erkennung von KI-generierten Inhalten konzentriert, anstatt auf Steganographie.

Im Gegensatz zu traditionellen Methoden, die auf komplexen Dekodierungsalgorithmen beruhen, ermöglicht die lokale Detektionsmethode von AudioSeal eine schnellere und effizientere Detektion. Dieses Design erhöht die Detektionsgeschwindigkeit im Vergleich zu früheren Methoden um das 485-fache und eignet sich daher hervorragend für groß angelegte und Echtzeit-Anwendungen. Unsere Methode erreicht einen Spitzenwert in Bezug auf die Robustheit und die Unwahrnehmbarkeit von Audio-Wasserzeichen.

AudioSeal wird unter einer kommerziellen Lizenz veröffentlicht.

Zugang: https://top.aibase.com/tool/audioseal

PRISM-Datensatz

Gleichzeitig hat Meta auch den PRISM-Datensatz veröffentlicht, der in Zusammenarbeit mit externen Partnern erstellt wurde und Konversationsdaten und Präferenzen von 1500 Teilnehmern weltweit enthält. Er dient der Verbesserung von großen Sprachmodellen, um die Vielfalt der Dialoge, die Präferenzvielfalt und den gesellschaftlichen Nutzen zu steigern.

Der Datensatz ordnet die Präferenzen und das feinkörnige Feedback jedes Teilnehmers 8.011 Echtzeitgesprächen mit 21 verschiedenen LLMs zu.

Zugang zum Datensatz: https://huggingface.co/datasets/HannahRoseKirk/prism-alignment

„DIG In“-Kennzahl

Zur Bewertung geografischer Unterschiede in Text-zu-Bild-Modellen und zur Bereitstellung weiterer Referenzdaten für Modellverbesserungen. Um zu verstehen, wie sich die Wahrnehmung der geografischen Darstellung bei Menschen in verschiedenen Regionen unterscheidet, hat Meta eine groß angelegte Annotationstudie durchgeführt. Wir haben über 65.000 Annotationen und über 20 Umfrageantworten pro Beispiel gesammelt, die Attraktivität, Ähnlichkeit, Konsistenz und gemeinsame Vorschläge umfassen, um die automatische und manuelle Bewertung von Text-zu-Bild-Modellen zu verbessern.

Zugang: https://top.aibase.com/tool/dig-in

Die Veröffentlichung dieser Projekte bringt neue technologische Durchbrüche und Anwendungsperspektiven im Bereich der KI hervor und ist von großer Bedeutung für die Förderung der Entwicklung und Anwendung von KI-Technologien.