In der sich rasant entwickelnden Welt der künstlichen Intelligenz setzt ein Unternehmen namens Etched alles auf eine Karte: die Transformer-Architektur. Das Unternehmen hat kürzlich den weltweit ersten speziell für Transformer entwickelten ASIC-Chip (Application-Specific Integrated Circuit) – Sohu – vorgestellt und behauptet, seine Leistung übertreffe alle derzeit erhältlichen GPUs bei weitem und werde die KI-Branche revolutionieren.

Transformer-Architektur dominiert den KI-Bereich

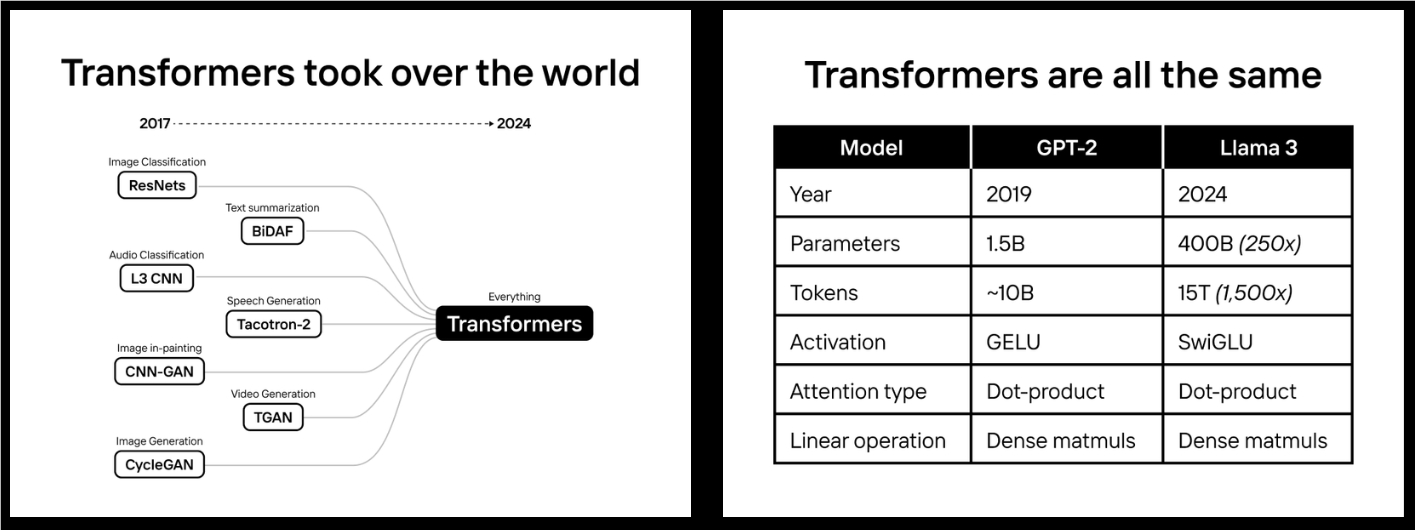

Etched wagte 2022 eine kühne Prognose: Die Transformer-Architektur wird die KI-Welt dominieren. Wie sich herausstellte, lag das Unternehmen richtig. Von ChatGPT und Sora bis hin zu Gemini und Stable Diffusion 3 – jedes hochmoderne KI-Modell nutzt die Transformer-Architektur. Auf dieser Grundlage entwickelte Etched in zwei Jahren den Sohu-Chip.

Der Sohu-Chip erzielt durch die direkte Integration der Transformer-Architektur in die Hardware eine beispiellose Leistungssteigerung. Dies bedeutet zwar, dass Sohu die meisten herkömmlichen KI-Modelle, wie z. B. DLRM hinter Instagram-Anzeigen, das Protein-Faltungsmodell AlphaFold2 oder frühere Bildmodelle wie Stable Diffusion 2, nicht ausführen kann, doch für Transformer-Modelle ist Sohu um ein Vielfaches schneller als alle anderen Chips.

Signifikante Leistungsvorteile

Laut Etched erreicht ein Server mit acht Sohu-Chips beim Ausführen des Llama70B-Modells eine erstaunliche Geschwindigkeit von über 500.000 Tokens pro Sekunde. Diese Leistung übertrifft die nächste Generation von Nvidia Blackwell (B200) GPUs um eine Größenordnung und das bei geringeren Kosten.

Konkret kann ein 8xSohu-Server 160 H100-GPUs ersetzen. Das bedeutet, dass sich mit Sohu die Betriebskosten von KI-Modellen deutlich senken und gleichzeitig die Verarbeitungsgeschwindigkeit erheblich steigern lässt.

Die Logik hinter der Wette

Etched setzt so vehement auf die Transformer-Architektur, weil das Unternehmen die Entwicklungstrends in der KI tiefgreifend versteht. Das Unternehmen ist der Ansicht, dass Skalierung der Schlüssel zur Erreichung übermenschlicher Intelligenz ist. In den letzten fünf Jahren haben KI-Modelle die Menschen in den meisten standardisierten Tests übertroffen, was hauptsächlich auf die enorme Steigerung der Rechenleistung zurückzuführen ist. Beispielsweise war der Rechenaufwand von Meta beim Training des Llama400B-Modells 50.000-mal höher als bei OpenAI beim Training von GPT-2.

Die weitere Skalierung steht jedoch vor immensen Herausforderungen. Die Kosten der nächsten Generation von Rechenzentren könnten das BIP eines kleinen Landes übersteigen. Bei der derzeitigen Entwicklung können unsere Hardware, Stromnetze und Finanzmittel nicht mithalten. Genau hier liegt die Chance von Sohu.

Die Notwendigkeit spezieller Chips

Etched ist der Ansicht, dass angesichts der Verlangsamung des Mooreschen Gesetzes die Spezialisierung der einzige Weg zur Leistungssteigerung ist. Bevor die Transformer-Architektur den KI-Bereich dominierte, entwickelten viele Unternehmen flexible KI-Chips und GPUs, um verschiedene Architekturen zu bewältigen. Doch jetzt, da die Nachfrage nach Transformer-Inferenz von etwa 50 Millionen Dollar auf Milliarden gestiegen ist und sich die KI-Modellarchitektur angleicht, ist die Entwicklung spezieller Chips unvermeidlich geworden.

Wenn die Trainingskosten eines Modells 1 Milliarde Dollar und die Inferenzkosten über 10 Milliarden Dollar betragen, lohnt sich selbst eine Leistungssteigerung von 1 % für ein kundenspezifisches Chip-Projekt im Wert von 50 Millionen bis 100 Millionen Dollar. Tatsächlich ist der Leistungsvorteil von ASICs noch viel größer.

Funktionsweise des Sohu-Chips

Die hohe Leistung des Sohu-Chips beruht auf seiner speziellen Optimierung für die Transformer-Architektur. Durch das Entfernen des Großteils der Steuerungslogik kann Sohu mehr mathematische Verarbeitungseinheiten aufnehmen. Dadurch erreicht Sohu eine FLOPS-Auslastung von über 90 %, während die Auslastung bei der Ausführung von TRT-LLM auf GPUs nur etwa 30 % beträgt.

Etched erklärt, dass durch die Spezialisierung auf Transformer mehr Berechnungseinheiten untergebracht werden können, da ein Großteil der Fläche von GPUs für die Gewährleistung der Programmierbarkeit verwendet wird. Tatsächlich werden von den 80 Milliarden Transistoren der H100-GPU nur 3,3 % für die Matrixmultiplikation verwendet. Durch die Fokussierung auf Transformer kann Sohu mehr FLOPS auf dem Chip unterbringen, ohne die Genauigkeit zu verringern oder Sparse-Techniken zu verwenden.

.png)

Software-Ökosystem

Obwohl der Sohu-Chip auf Hardware-Ebene einen großen Durchbruch darstellt, ist das Software-Ökosystem ebenfalls von entscheidender Bedeutung. Im Vergleich zu GPUs und TPUs ist die Softwareentwicklung für Sohu relativ einfach, da nur die Transformer-Architektur unterstützt werden muss. Etched hat sich verpflichtet, die gesamte Software, vom Treiber über den Kernel bis hin zum Service-Stack, Open Source zur Verfügung zu stellen. Dies wird Entwicklern die Nutzung und Optimierung des Sohu-Chips erheblich erleichtern.

Zukunftsaussichten

Wenn die Wette von Etched aufgeht, wird der Sohu-Chip die Landschaft der KI-Branche grundlegend verändern. Derzeit leiden viele KI-Anwendungen unter Leistungseinengungen. Beispielsweise benötigt Gemini über 60 Sekunden, um eine Frage zu einem Video zu beantworten, die Kosten für Codierungsagenten sind höher als die von Softwareentwicklern, und die Aufgaben dauern Stunden, und Videomodelle können nur eine Frame pro Sekunde generieren.

Der Sohu-Chip könnte die Geschwindigkeit von KI-Modellen um das 20-fache steigern und gleichzeitig die Kosten deutlich senken. Dies würde Anwendungen wie Echtzeit-Videogenerierung, -anrufe, intelligente Agenten und die Suche ermöglichen. Etched nimmt bereits Bewerbungen für den Sohu Developer Cloud Service entgegen und rekrutiert aktiv Mitarbeiter für sein Team.

Der Durchbruch in der KI-Rechenleistung könnte weitreichende Auswirkungen haben, und der Sohu-Chip von Etched verdient unsere Aufmerksamkeit. Mit der Veröffentlichung weiterer Details und der praktischen Anwendung können wir das Potenzial dieser Technologie und ihre Auswirkungen auf den KI-Bereich besser einschätzen.