Eine Analyse von 14 Millionen PubMed-Zusammenfassungen zeigt, dass KI-Textgeneratoren seit der Einführung von ChatGPT mindestens 10 % der wissenschaftlichen Zusammenfassungen beeinflusst haben – in einigen Bereichen und Ländern sogar noch mehr.

Forscher der Universität Tübingen und der Northwestern University untersuchten sprachliche Veränderungen in 14 Millionen wissenschaftlichen Zusammenfassungen aus den Jahren 2010 bis 2024. Sie stellten fest, dass ChatGPT und ähnliche KI-Textgeneratoren zu einem deutlichen Anstieg bestimmter stilistischer Wörter geführt haben.

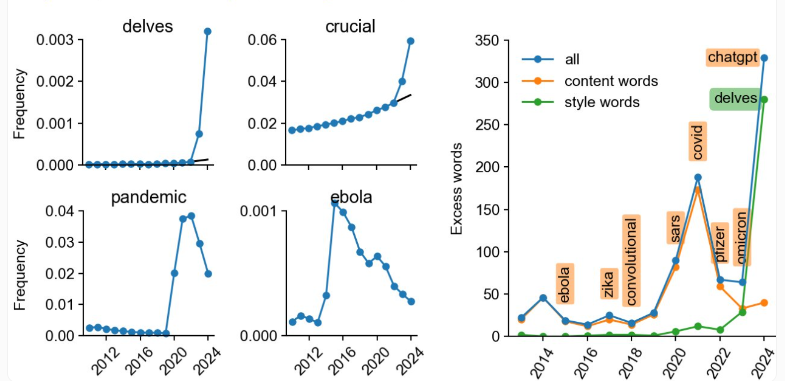

Zuerst identifizierten die Forscher Wörter, die 2024 im Vergleich zu früheren Jahren signifikant häufiger auftraten. Dazu gehörten viele Verben und Adjektive, die typisch für den ChatGPT-Schreibstil sind, wie „gründlich untersuchen“, „komplex“, „zeigen“ und „hervorheben“.

Anhand dieser Markierungswörter schätzten die Forscher, dass KI-Textgeneratoren im Jahr 2024 mindestens 10 % aller PubMed-Zusammenfassungen beeinflusst haben. In einigen Fällen übertraf dieser Einfluss sogar den von Wörtern wie „Covid“, „Pandemie“ oder „Ebola“ in ihren jeweiligen Zeiträumen.

In Untergruppen von PubMed in Ländern wie China und Südkorea fanden die Forscher heraus, dass etwa 15 % der Zusammenfassungen mit ChatGPT erstellt wurden, während es in Großbritannien nur 3 % waren. Dies bedeutet jedoch nicht unbedingt, dass britische Autoren ChatGPT seltener verwenden.

Tatsächlich dürfte die tatsächliche Verwendung von KI-Textgeneratoren laut den Forschern deutlich höher liegen. Viele Forscher bearbeiten KI-generierte Texte und entfernen typische Markierungswörter. Muttersprachler könnten dabei einen Vorteil haben, da sie solche Formulierungen eher bemerken. Dies erschwert die Bestimmung des tatsächlichen Anteils der von KI beeinflussten Zusammenfassungen.

Im messbaren Bereich ist die KI-Nutzung in Zeitschriften besonders hoch, beispielsweise etwa 17 % in Frontiers- und MDPI-Zeitschriften und sogar 20 % in IT-Zeitschriften. In IT-Zeitschriften ist der Anteil chinesischer Autoren mit 35 % am höchsten.

Für wissenschaftliche Autoren kann KI dazu beitragen, Texte lesbarer zu gestalten. Dmitry Kobak, einer der Autoren der Studie, sagte, dass speziell für Zusammenfassungen entwickelte KI-Generatoren nicht unbedingt das Problem seien.

KI-Textgeneratoren können jedoch auch Fakten erfinden, Vorurteile verstärken oder sogar plagiieren. Sie können auch die Vielfalt und Originalität wissenschaftlicher Texte verringern.

Ironischerweise wurde das von Meta kurz vor der Veröffentlichung von ChatGPT veröffentlichte wissenschaftliche Open-Source-Sprachmodell „Galactica“ von Teilen der wissenschaftlichen Gemeinschaft scharf kritisiert und von Meta offline genommen. Dies hat den Einzug von generativer KI in das wissenschaftliche Schreiben offenbar nicht verhindert, aber möglicherweise die Einführung eines speziell für diese Aufgabe optimierten Systems verhindert.

Wichtigste Punkte:

😮 Analysen von PubMed-Zusammenfassungen zeigen, dass seit der Einführung von ChatGPT mindestens 10 % der wissenschaftlichen Zusammenfassungen von KI-Textgeneratoren beeinflusst wurden.

😯 In Untergruppen von PubMed in Ländern wie China und Südkorea wurden etwa 15 % der Zusammenfassungen mit ChatGPT erstellt, in Großbritannien nur 3 %.

😲 KI-Textgeneratoren können Fakten erfinden, Vorurteile verstärken oder sogar plagiieren. Daher fordern Forscher eine Neubewertung der Richtlinien für die Verwendung von KI-Textgeneratoren in der Wissenschaft.