Im Bereich der künstlichen Intelligenz ist die Generierung und Überprüfung von Code ein wichtiges Feld des technischen Fortschritts. OpenAI hat kürzlich ein auf GPT-4 basierendes Modell namens CriticGPT vorgestellt, das speziell für die Überprüfung von von ChatGPT generiertem Code und die Aufdeckung von Fehlern entwickelt wurde. Dieses innovative Werkzeug markiert einen wichtigen Schritt im Bereich der Selbstüberwachung und Fehlererkennung durch künstliche Intelligenz.

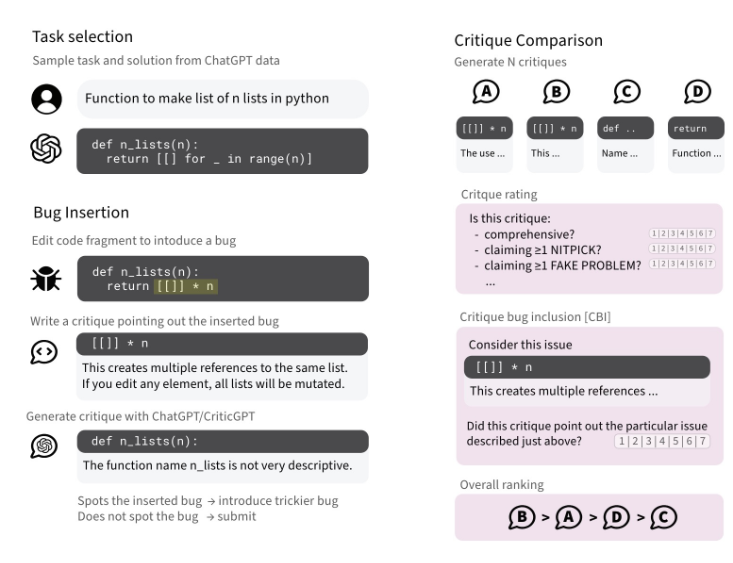

Obwohl große Sprachmodelle (LLMs) wie ChatGPT bemerkenswerte Erfolge bei der Codegenerierung erzielt haben, besteht bei der Qualität und Richtigkeit ihrer Ausgaben immer noch eine gewisse Unsicherheit. CriticGPT wurde entwickelt, um diese Lücke zu schließen. Es unterstützt menschliche Experten durch die Generierung von Kommentaren in natürlicher Sprache bei der genaueren Bewertung von Code und verbessert so die Fehlererkennung deutlich in Bezug auf Fähigkeit und Effizienz.

Überragende Leistung bei der Fehlererkennung

CriticGPT zeigt eine hervorragende Leistung bei der Identifizierung von Fehlern im Code, sei es Syntaxfehler, logische Fehler oder Sicherheitslücken. Es erkennt und benennt diese präzise. Studien zeigen, dass CriticGPT sogar mehr Fehler findet als menschliche Bewerter, eine Entdeckung mit revolutionärer Bedeutung im Bereich der Codeüberprüfung.

Bias-Reduktion und verbesserte Zusammenarbeit

CriticGPT leistet auch einen erheblichen Beitrag zur Reduzierung von Halluzinationsfehlern. In Zusammenarbeit mit menschlichen Experten kann CriticGPT die Verzerrungen bei der Fehlererkennung deutlich reduzieren und gleichzeitig eine effiziente Fehlererkennung beibehalten. Dieses „Mensch-Maschine-Team“-Arbeitsmodell bietet eine neue Perspektive auf die Fehlererkennung.

Hauptfunktionen von CriticGPT

Fehlererkennung: CriticGPT analysiert Code umfassend, identifiziert und meldet verschiedene Fehler und vermeidet gleichzeitig Halluzinationsfehler.

Generierung kritischer Kommentare: Bietet detaillierte Fehleranalysen und Verbesserungsvorschläge, um Teams beim Verständnis und der Lösung von Problemen zu unterstützen.

Verbesserung des Trainingsergebnisses: Zusammenarbeit mit menschlichen Trainern zur Verbesserung der Qualität und Reichweite der Kommentare.

Reduzierung falscher Fehler: Verwendung einer Forced Sampling Beam Search-Strategie, um unnötige Fehlmarkierungen zu reduzieren.

Modelltraining und -optimierung: Durch RLHF-Training wird die Leistung von CriticGPT kontinuierlich optimiert.

Präzise Suche und Bewertung: Ausbalancierung zwischen Problemfindung und Fehlalarmen für präzise Fehlerberichte.

Verbesserte Zusammenarbeit zwischen Mensch und KI: Als Hilfsmittel zur Steigerung der Effizienz und Genauigkeit der Bewertung.

Technische Methoden und Versuchsergebnisse

CriticGPT wird durch Reinforcement Learning aus menschlichem Feedback trainiert und konzentriert sich auf die Verarbeitung fehlerhafter Eingaben. Die Forscher trainierten CriticGPT, indem sie absichtlich Fehler in den Code einfügten und Feedback gaben. Die Versuchsergebnisse zeigen, dass CriticGPT von Trainern bevorzugt wird, wenn es Kritik liefert, da seine Kritik qualitativ hochwertiger ist und besser zur Aufdeckung und Lösung von Problemen beiträgt.

Die Einführung dieser Technologie verbessert nicht nur die Genauigkeit der Codeüberprüfung, sondern bietet auch neue Möglichkeiten für die Selbstüberwachung und das kontinuierliche Lernen künstlicher Intelligenz. Mit der kontinuierlichen Optimierung und Anwendung von CriticGPT können wir davon ausgehen, dass es eine wichtige Rolle bei der Verbesserung der Codequalität und dem Fortschritt der Technologie spielen wird.

Artikel: https://cdn.openai.com/llm-critics-help-catch-llm-bugs-paper.pdf