Les modèles de la série DeepSeek, récemment lancés, ont fait sensation dans le monde de l'IA. DeepSeek-V3 offre des performances élevées à faible coût, rivalisant avec les meilleurs modèles propriétaires lors de nombreux tests ; DeepSeek-R1, quant à lui, grâce à une méthode d'entraînement innovante, affiche de puissantes capacités de raisonnement, comparables à la version officielle d'OpenAI o1, et ses poids de modèle sont open source, ouvrant de nouvelles perspectives dans le domaine de l'IA.

DeepSeek a également rendu publiques toutes ses techniques d'entraînement. R1, comparable au modèle o1 d'OpenAI, utilise abondamment l'apprentissage par renforcement lors de la phase d'entraînement postérieur. DeepSeek affirme que R1 est équivalent à o1 pour les tâches de mathématiques, de codage et de raisonnement en langage naturel, et son prix API est inférieur à 4 % de celui de o1.

DeepSeek R1 est si puissant ! Les ingénieurs de Meta paniquent : démontage frénétique pour tenter de le reproduire

Récemment, un post anonyme d'un employé de Meta sur la plateforme professionnelle anonyme teamblind, intitulé « Meta genai org in panic mode », a suscité beaucoup d'attention. Le lancement de DeepSeek V3 a relégué Llama 4 au second plan lors des tests de référence, plongeant l'équipe d'IA générative de Meta dans la panique. Une « entreprise chinoise inconnue » a réalisé cette percée avec un budget d'entraînement de 5 millions de dollars.

Les ingénieurs de Meta démontent frénétiquement DeepSeek pour tenter de le reproduire, tandis que la direction s'inquiète de justifier les coûts exorbitants auprès de la haute direction, étant donné que le salaire de chacun des dizaines de « leaders » de leur équipe dépasse le coût d'entraînement de DeepSeek V3. L'arrivée de DeepSeek R1 aggrave la situation. Bien que certaines informations ne puissent pas encore être divulguées, elles le seront bientôt, et la situation pourrait alors devenir encore plus défavorable.

Traduction du post anonyme de l'employé de Meta (réalisée par DeepSeek R1) :

Le département IA générative de Meta est en état d'urgence

Tout a commencé avec DeepSeek V3 – il a rendu les résultats des tests de référence de Llama 4 instantanément obsolètes. Plus embarrassant encore, « une entreprise chinoise inconnue a réalisé cette percée avec un budget d'entraînement de seulement 5 millions de dollars ».

L'équipe d'ingénieurs est en train de démonter frénétiquement l'architecture de DeepSeek, en essayant de reproduire tous les détails techniques. Ce n'est pas une exagération, notre base de code est passée au peigne fin.

La direction se démène pour justifier les dépenses exorbitantes du département. Comment expliquer à la haute direction que le salaire annuel de chacun des dizaines de « leaders » du département IA générative dépasse le coût total d'entraînement de DeepSeek V3 ?

DeepSeek R1 rend la situation encore plus critique. Bien que je ne puisse pas divulguer d'informations confidentielles, les données pertinentes seront bientôt rendues publiques.

Ce qui devait être une équipe technique agile et axée sur la technologie s'est retrouvé gonflé artificiellement par un afflux massif de personnel en quête d'influence. Le résultat de ce jeu de pouvoir ? Tout le monde est perdant.

Présentation des modèles de la série DeepSeek

DeepSeek-V3 : il s'agit d'un modèle linguistique d'expert mixte (MoE) de 671 milliards de paramètres, avec 37 milliards de paramètres activés par jeton. Il utilise l'architecture Multi-head Latent Attention (MLA) et DeepSeekMoE, et a été pré-entraîné sur 14,8 billions de jetons de haute qualité. Après un réglage fin supervisé et un apprentissage par renforcement, il surpasse certains modèles open source lors de nombreux tests, et ses performances sont comparables à celles des meilleurs modèles propriétaires tels que GPT-4o, Claude 3.5 Sonnet, etc. Le coût d'entraînement est faible, avec seulement 2 788 000 heures de GPU H800, soit environ 5 576 000 dollars, et le processus d'entraînement est stable.

DeepSeek-R1 : comprend DeepSeek-R1-Zero et DeepSeek-R1. DeepSeek-R1-Zero, entraîné par un apprentissage par renforcement à grande échelle, ne dépend pas du réglage fin supervisé (SFT), et présente des capacités d'auto-vérification et de réflexion, mais souffre d'un manque de lisibilité et de mélange linguistique. DeepSeek-R1, basé sur DeepSeek-R1-Zero, introduit un entraînement multi-étapes et des données de démarrage à froid, résolvant certains problèmes. Ses performances en mathématiques, en codage et en raisonnement en langage naturel sont comparables à celles de la version officielle d'OpenAI o1. De plus, plusieurs modèles de différentes tailles de paramètres sont open source, stimulant le développement de la communauté open source.

Qu'est-ce qui rend DeepSeek si spécial ?

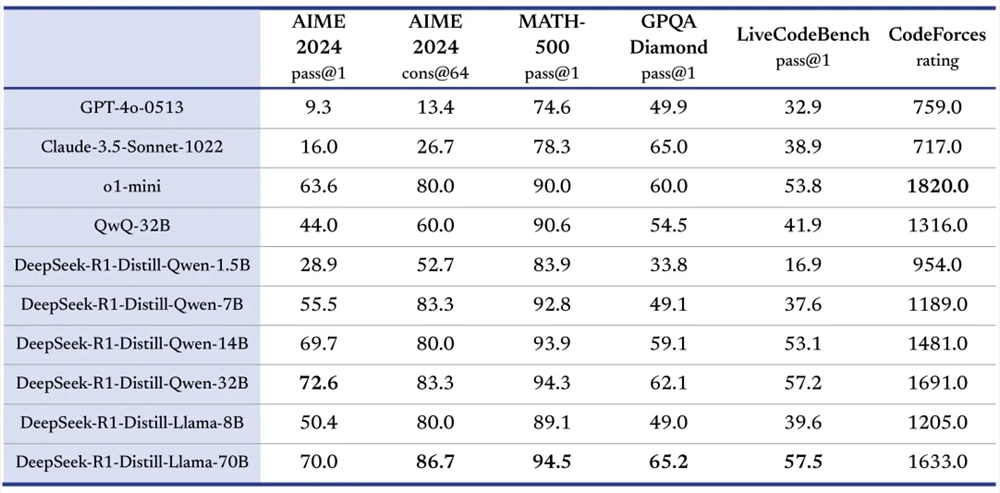

Performances exceptionnelles : DeepSeek-V3 et DeepSeek-R1 affichent d'excellents résultats lors de nombreux tests de référence. DeepSeek-V3 obtient d'excellents scores aux tests MMLU, DROP, etc. ; DeepSeek-R1 affiche une grande précision aux tests AIME 2024, MATH-500, etc., comparable, voire supérieure dans certains cas, à la version officielle d'OpenAI o1.

Innovation en matière d'entraînement :

DeepSeek-V3 utilise une stratégie d'équilibrage de charge sans perte auxiliaire et un objectif de prédiction multi-jetons (MTP), réduisant la baisse de performances et améliorant les performances du modèle ; l'entraînement FP8 a prouvé sa faisabilité pour les modèles à grande échelle.

DeepSeek-R1-Zero est entraîné uniquement par apprentissage par renforcement, en s'appuyant uniquement sur des signaux de récompense simples pour optimiser le modèle, prouvant que l'apprentissage par renforcement peut améliorer les capacités de raisonnement du modèle ; DeepSeek-R1, quant à lui, utilise des données de démarrage à froid pour améliorer la stabilité et la lisibilité du modèle.

Partage open source : les modèles de la série DeepSeek adhèrent à la philosophie open source, et les poids des modèles sont open source, tels que DeepSeek-V3 et DeepSeek-R1 et leurs petits modèles distillés, permettant aux utilisateurs d'utiliser la technique de distillation pour entraîner d'autres modèles avec R1, favorisant ainsi les échanges et l'innovation en matière de technologie IA.

Avantages multi-domaines : DeepSeek-R1 affiche de puissantes capacités dans plusieurs domaines. Dans le domaine du codage, il obtient un classement élevé sur la plateforme Codeforces, surpassant la plupart des participants humains ; dans les tâches de traitement du langage naturel, il excelle dans le traitement de diverses tâches de compréhension et de génération de texte.

Excellent rapport qualité-prix : les modèles de la série DeepSeek offrent des prix API abordables. Par exemple, le prix d'entrée/sortie de l'API DeepSeek-V3 est bien inférieur à celui des modèles similaires ; le prix du service API DeepSeek-R1 est également compétitif, réduisant les coûts pour les développeurs.

Scénarios d'application de DeepSeek-R1

Tâches de traitement du langage naturel : y compris la génération de texte, les systèmes de questions-réponses, la traduction automatique, la synthèse de texte, etc. Par exemple, dans les systèmes de questions-réponses, DeepSeek-R1 peut comprendre les questions et utiliser ses capacités de raisonnement pour fournir des réponses précises ; dans les tâches de génération de texte, il peut générer des textes de haute qualité en fonction d'un thème donné.

Développement de code : aide les développeurs à écrire du code, à déboguer des programmes et à comprendre la logique du code. Par exemple, lorsque les développeurs rencontrent un problème de code, DeepSeek-R1 peut analyser le code et fournir des solutions ; il peut également générer l'armature d'un code ou des fragments de code spécifiques en fonction d'une description de la fonctionnalité.

Résolution de problèmes mathématiques : dans les domaines de l'éducation mathématique et de la recherche, résolution de problèmes mathématiques complexes. DeepSeek-R1 excelle dans les problèmes liés au concours AIME, et peut être utilisé pour aider les étudiants à apprendre les mathématiques et les chercheurs à traiter les problèmes mathématiques difficiles.

Recherche et développement de modèles : fournit des références et des outils aux chercheurs en IA pour la distillation de modèles, l'amélioration de la structure des modèles et les méthodes d'entraînement. Les chercheurs peuvent effectuer des expériences basées sur les modèles open source de DeepSeek et explorer de nouvelles orientations technologiques.

Aide à la décision : dans les domaines du commerce et de la finance, traitement des données et des informations, fourniture de conseils décisionnels. Par exemple, analyse des données de marché pour fournir des références aux entreprises pour l'élaboration de stratégies marketing ; traitement des données financières pour aider à la prise de décision en matière d'investissement.

Tutoriel d'utilisation simplifié des modèles de la série DeepSeek

Accès à la plateforme : les utilisateurs peuvent se connecter au site Web de DeepSeek (https://www.deepseek.com/) pour accéder à la plateforme.

Sélection du modèle : sur le site Web ou l'application, la conversation par défaut est gérée par DeepSeek-V3. Cliquez sur le mode « Réflexion approfondie » pour utiliser le modèle DeepSeek-R1. Si vous utilisez l'API, définissez les paramètres du modèle correspondants dans le code en fonction de vos besoins. Par exemple, pour utiliser DeepSeek-R1, définissez

model='deepseek-reasoner'.Saisie de la tâche : saisissez la tâche dans l'interface de conversation à l'aide d'une description en langage naturel, par exemple : « Écrire une nouvelle d'amour », « Expliquer la fonction de ce code », « Résoudre l'équation mathématique », etc. Si vous utilisez l'API, construisez la requête conformément aux spécifications de l'API et transmettez les informations relatives à la tâche en tant que paramètres d'entrée.

Obtention des résultats : une fois la tâche traitée par le modèle, les résultats sont renvoyés. Affichez le texte généré, les questions résolues, etc., dans l'interface ; lors de l'utilisation de l'API, analysez les données des résultats à partir de la réponse de l'API pour les traitements ultérieurs.

Conclusion

Grâce à ses performances exceptionnelles, à ses méthodes d'entraînement innovantes, à son esprit de partage open source et à son excellent rapport qualité-prix, la série de modèles DeepSeek a obtenu des résultats remarquables dans le domaine de l'IA.

Si vous êtes intéressé par la technologie IA, n'hésitez pas à aimer, commenter et partager votre opinion sur les modèles de la série DeepSeek. Continuez à suivre l'évolution de DeepSeek et attendez-vous à ce qu'il apporte davantage de surprises et de percées au domaine de l'IA, stimulant le progrès continu de la technologie IA et apportant des transformations et des opportunités à divers secteurs.