Typ :

- Nachrichten und Informationen

- Produktanwendungen

- Monetarisierungsfälle

- KI-Tutorials

2025-02-12 15:14:57.AIbase.15.3k

猿辅导全系列产品集成DeepSeek,打造更智能的教育大模型

Kürzlich gab die猿辅导-Gruppe bekannt, dass ihre intelligenten Hardware-Produkte für den Bildungsbereich, wie z. B. die „小猿学练机“ und die KI-basierte Lern-App „小猿口算“, offiziell in DeepSeek integriert wurden und mit dem selbst entwickelten 猿力大模型 tiefgehend zusammenarbeiten. Diese Kooperation zielt darauf ab, Schülern ein genaueres, intelligenteres und personalisierteres Lernerlebnis zu bieten. Wang Xiangdong, Vizepräsident der猿辅导-Gruppe, erklärte, dass große Sprachmodelle im Bildungsbereich der Schlüssel zur Bewältigung der Herausforderungen unterschiedlicher Schulstufen und individueller Unterschiede sind. Durch die Integration der fortschrittlichen Inferenzfähigkeiten von DeepSeek wird das 猿力大模型 das personalisierte Lernerlebnis weiter optimieren. Zum Beispiel, in A...

2025-02-06 14:41:26.AIbase.15.1k

启明星辰成功集成DeepSeek大模型,安全智能化再升级

启明星辰近日在其官方微信公众号上宣布,已成功完成“安星”智能体与DeepSeek大模型的全面集成。此举标志着启明星辰在信息安全领域取得了重大进展,尤其是在安全运营、威胁检测、威胁情报和数据安全等多个业务场景中得到了显著应用。作为中国领先的信息安全解决方案提供商,启明星辰一直致力于提升安全防护能力。此次与DeepSeek大模型的集成,进一步增强了公司的技术实力。

2025-01-22 16:42:53.AIbase.14.9k

SenseTime präsentiert die „秒画趣拍“-App für personalisierte Neujahrsfotos

SenseTime hat kürzlich seine neue App „秒画趣拍“ veröffentlicht, die Nutzern ein kreatives und unterhaltsames KI-Bilderlebnis bietet. Rechtzeitig zum neuen Jahr ermöglicht die App mithilfe modernster künstlicher Intelligenz die Erstellung personalisierter Neujahrsfotos und sorgt für eine festliche Atmosphäre. „秒画趣拍“ ist mehr als nur eine gewöhnliche Foto-App. Das integrierte Miniprogramm bietet eine große Auswahl an Vorlagen, darunter Campus-Abschlussfotos, kreative Gruppenfotos, Fotos im Stil berühmter Gemälde, Reisefotos, Fotos im neuen chinesischen Stil und Anime-Bilder.

2025-01-15 17:08:10.AIbase.14.7k

Vidu 2.0 offiziell veröffentlicht: 10 Sekunden für kurze Videos, verbesserte Konsistenz

Das chinesische Video-Sprachmodell Vidu erhält ein bedeutendes Upgrade und veröffentlicht die Version 2.0. Die bemerkenswerteste Verbesserung ist die deutlich schnellere Generierung: von ursprünglich 30 Sekunden auf erstaunliche 10 Sekunden – eine dreifache Effizienzsteigerung. Theoretisch können Benutzer in nur 5 Minuten Videomaterial von bis zu einer Minute Länge erstellen. Dieser Durchbruch wird die Erstellung von Videomaterial erheblich beschleunigen. Neben der Geschwindigkeit wurde bei Vidu 2.0 auch die Videoqualität umfassend verbessert. Die Videos der neuen Version weisen eine höhere Konsistenz in Stil und Thema auf.

2024-10-28 16:13:01.AIbase.12.8k

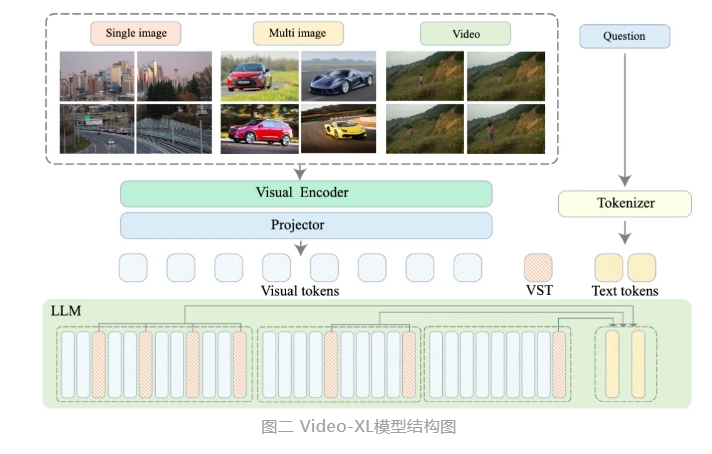

智源推出小时级超长视频理解大模型Video-XL

Das Beijing Institute for Artificial Intelligence (BAAI) hat in Zusammenarbeit mit der Shanghai Jiao Tong University, der Renmin University of China, der Peking University und der Beijing University of Posts and Telecommunications ein neues großes Sprachmodell namens Video-XL zur Verarbeitung von sehr langen Videos vorgestellt. Dieses Modell ist eine wichtige Demonstration der Kernfähigkeiten multimodaler großer Sprachmodelle und ein entscheidender Schritt auf dem Weg zur Allgemeinen Künstlichen Intelligenz (AGI). Im Vergleich zu bestehenden multimodalen großen Sprachmodellen zeigt Video-XL eine deutlich bessere Leistung und Effizienz bei der Verarbeitung von Videos mit einer Länge von über 10 Minuten.

2024-09-05 08:43:35.AIbase.11.5k

智源研究院推出包含文生视频模型对战评测服务:FlagEval大模型角斗场

Am 4. September 2024 gab das Beijing Academy of Artificial Intelligence (BAAI) die Einführung von FlagEval, der weltweit ersten Modell-Battle- und Bewertungsdienstleistung mit Text-zu-Video-Funktionen, bekannt. Dieser Service steht Nutzern offen und umfasst etwa 40 große Sprachmodelle aus dem In- und Ausland. Er unterstützt benutzerdefinierte Online- oder Offline-Bewertungen für vier Aufgaben: Sprachfragen und Antworten, multimodalen Bild- und Textverständnis, Text-zu-Bild und Text-zu-Video.

2024-09-04 08:35:31.AIbase.11.5k

智谱和荣耀在AI大模型方面签署合作,探索终端AI智能体验

Am 2. September 2024 unterzeichneten die Beijing ZhiPu AI Technology Co., Ltd. und Honor in Peking eine strategische Kooperationsvereinbarung für ein gemeinsames Labor für KI-Großmodelle. Dies markiert eine neue Phase der Zusammenarbeit beider Unternehmen im Bereich der künstlichen Intelligenz. ZhiPu konzentriert sich auf die Entwicklung von KI-Großmodellen der nächsten Generation und auf Innovationen im Bereich der großen KI-Basismodelle für allgemeine Zwecke. Honor ist ein führender Anbieter von Plattform-KI-Technologien im Bereich der Unterhaltungselektronik.

2024-06-18 08:56:33.AIbase.9.6k

聆心智能发布新一代超拟人大模型 CharacterGLM Pro

CharacterGLM Pro ist das neue, hochentwickelte, hyperrealistische große Sprachmodell von Listening Heart Intelligence. Nach 6 Monaten Produkttests und Optimierung wird es nun offiziell veröffentlicht. Das Modell zeichnet sich durch überragende Kohärenz, menschenähnliche Eigenschaften, flüssige Interaktion und Unterhaltungswert aus und erreicht ein SOTA-Niveau. Vergleichende Tests haben gezeigt, dass CharacterGLM Pro in Konsistenz-Tests, Gesamt-Tests, Angriffstests und Online-Dialog-Tests herausragende Leistungen erbringt und in allen Metriken die besten Ergebnisse erzielt. Das Modell wurde mit verschiedenen Testdatensätzen trainiert, darunter auch künstlich generierte Daten,

2023-10-20 14:20:53.AIbase.2.3k

恒生电子金融大模型 LightGPT 升级,推出金融智能助手光子

Auf der Hengsheng Finanztechnologiekonferenz wurden die aktualisierten Ergebnisse des Finanz-Großmodells LightGPT und die öffentliche Testphase der offenen Produkte vorgestellt. Das Finanz-Großmodell LightGPT wurde in Bezug auf die Gesamtleistung des Modells, die Sicherheit und Compliance sowie die Inferenzgeschwindigkeit verbessert. Hengsheng präsentiert den intelligenten Finanzassistenten Photon, der die Verbindung zwischen Großmodellen und praktischen Anwendungen herstellt. Zu den intelligenten Produkten, die durch Photon unterstützt werden, gehören Photon·Wenqu, Photon·Fangyuan, Photon·Shance und Photon·Huiying. Die Tochtergesellschaft von Hengsheng, Hengsheng JUYuan, präsentiert die intelligente Investment-Research-Plattform Warre.