El laboratorio de investigación de IA independiente y sin fines de lucro francés Kyutai ha lanzado Moshi, un revolucionario modelo base multimodal nativo en tiempo real. Este modelo innovador imita y supera en ciertas funciones algunas de las capacidades demostradas por GPT-4o de OpenAI en mayo.

Acceso al producto:https://top.aibase.com/tool/moshi-chat

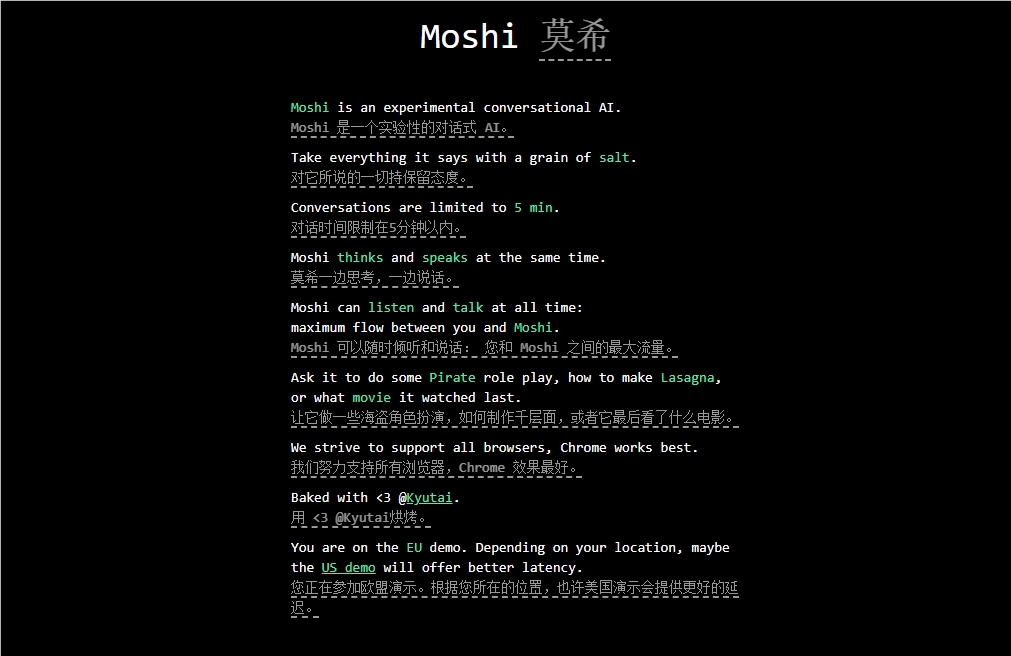

Moshi está diseñado para comprender y expresar emociones, y tiene la capacidad de conversar utilizando diferentes acentos (incluido el francés). Puede escuchar y generar simultáneamente audio y voz, manteniendo una transmisión fluida del pensamiento textual. Se entiende que Moshi posee una variedad de emociones similares a las humanas, pudiendo hablar con 70 emociones y estilos diferentes.

Una característica destacada de Moshi es su capacidad para procesar dos flujos de audio simultáneamente, lo que le permite escuchar y hablar al mismo tiempo. Esta interacción en tiempo real se basa en un preentrenamiento conjunto de texto y audio mixtos, utilizando datos de texto sintético del modelo de lenguaje de 7 mil millones de parámetros Helium, desarrollado por Kyutai.

El proceso de ajuste fino de Moshi involucró 100.000 conversaciones sintéticas de "estilo coloquial" convertidas mediante tecnología de texto a voz (TTS). La voz del modelo se entrenó con datos sintéticos generados por otro modelo TTS, logrando un sorprendente tiempo de latencia de extremo a extremo de 200 milisegundos.

Cabe destacar que Kyutai también ha desarrollado una variante más pequeña de Moshi que puede ejecutarse en un MacBook o una GPU de nivel de consumo, permitiendo el acceso a una gama más amplia de usuarios.

Puntos clave: 🔍 Kyutai lanza Moshi, un modelo base de IA multimodal nativo en tiempo real.

🔍 Moshi tiene la capacidad de comprender y expresar emociones, y admite múltiples acentos.

🔍 El modelo ha sido meticulosamente ajustado y entrenado, mostrando un rendimiento eficiente y un potencial de aplicación diverso.