En mayo, IBM lanzó el modelo LLM Granite13B de código abierto, diseñado para aplicaciones empresariales. Ahora, Armand Ruiz, vicepresidente de productos de la plataforma de IA de IBM, ha hecho público el contenido completo del extenso conjunto de datos de 6.48 TB utilizado para entrenar Granite13B.

Este conjunto de datos, después de un riguroso preprocesamiento, se redujo a 2.07 TB, una disminución del 68%. Ruiz enfatizó que este paso es crucial para garantizar un conjunto de datos de alta calidad, imparcial, ético y legal que satisfaga las necesidades de las aplicaciones empresariales.

El conjunto de datos fue cuidadosamente compilado a partir de múltiples fuentes, incluyendo:

- arXiv: Más de 2.4 millones de preimpresiones de artículos científicos.

- Common Crawl: Una base de datos de rastreo web abierta.

- DeepMind Mathematics: Pares de preguntas y respuestas matemáticas.

- Free Law: Opiniones legales de dominio público de los tribunales estadounidenses.

- GitHub Clean: Datos de código de CodeParrot.

- Hacker News: Noticias de informática y emprendimiento de 2007 a 2018.

- OpenWeb Text: Versión de código abierto del corpus Web Text de OpenAI.

- Project Gutenberg (PG-19): Libros electrónicos gratuitos, con enfoque en obras antiguas.

- Pubmed Central: Artículos de biomedicina y ciencias de la vida.

- SEC Filings: Documentos de presentación 10-K/Q de la Comisión de Bolsa y Valores de EE. UU. (SEC) (1934-2022).

- Stack Exchange: Contenido contribuido por usuarios de la red Stack Exchange.

- USPTO: Patentes estadounidenses otorgadas entre 1975 y mayo de 2023.

- Webhose: Convierte contenido web no estructurado en datos legibles por máquina.

- Wikimedia: Ocho proyectos de Wikimedia en inglés.

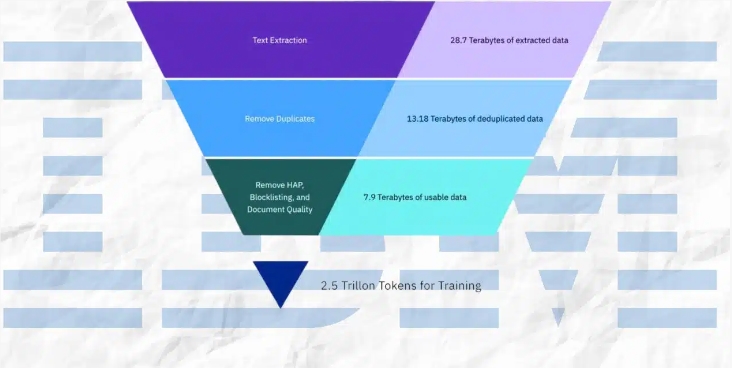

El proceso de preprocesamiento incluyó la extracción de texto, la eliminación de duplicados, la identificación del idioma, la segmentación de oraciones, la anotación de odio, abuso y malas palabras, la anotación de la calidad del documento, la anotación de bloqueo de URL, el filtrado y la tokenización.

Estos pasos involucraron la anotación y el filtrado basados en umbrales predefinidos, asegurando que el conjunto de datos final fuera de la más alta calidad para el entrenamiento del modelo.

IBM lanzó cuatro versiones del modelo de código Granite, con rangos de parámetros que van de 3 mil millones a 34 mil millones. Estos modelos han sido probados en una serie de pruebas de referencia y superan a otros modelos comparables, como Code Llama y Llama3, en muchas tareas.

Puntos clave:

⭐ IBM publicó el conjunto de datos completo de 6.48 TB utilizado para entrenar el modelo LLM Granite13B.

⭐ El conjunto de datos, después del preprocesamiento, se redujo a 2.07 TB, una disminución del 68%.

⭐ IBM lanzó cuatro versiones del modelo de código Granite, con rangos de parámetros que van de 3 mil millones a 34 mil millones.