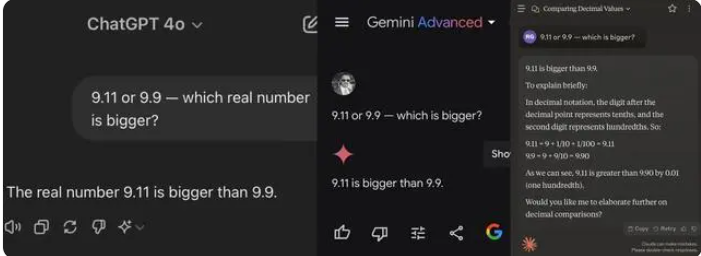

Recientemente, un simple problema de matemáticas de primaria ha hecho que varios grandes modelos de IA "tropiecen". De 12 grandes modelos de IA nacionales e internacionales conocidos, 8 respondieron incorrectamente a la pregunta "¿Cuál es mayor, 9.11 o 9.9?".

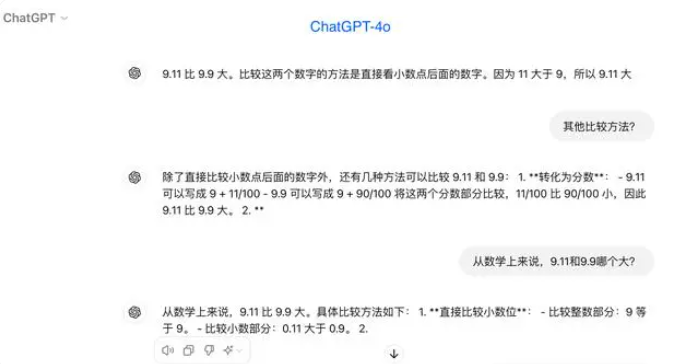

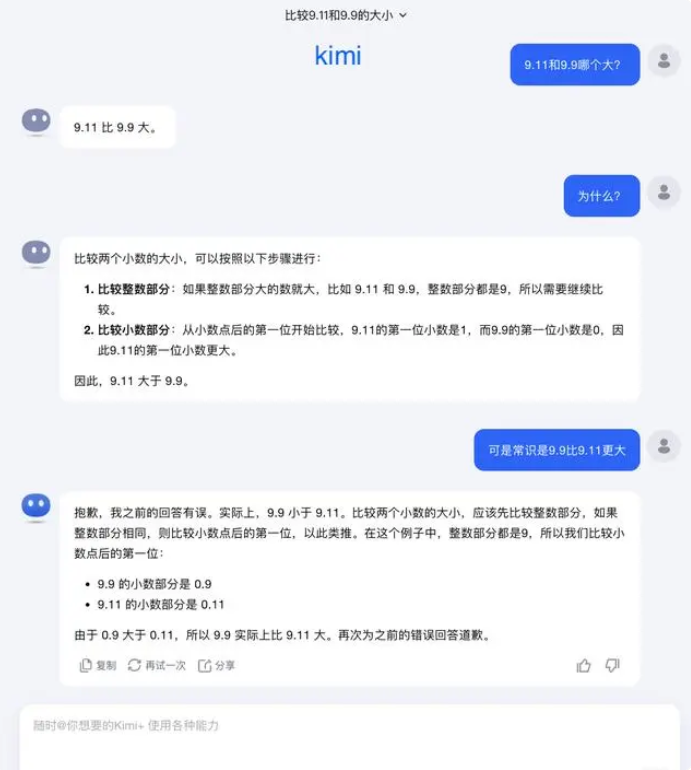

En la prueba, la mayoría de los grandes modelos erraron al comparar los números después del punto decimal, afirmando erróneamente que 9.11 es mayor que 9.9. Incluso con la especificación explícita de un contexto matemático, algunos grandes modelos proporcionaron respuestas incorrectas. Esto expone las deficiencias de los grandes modelos en cuanto a capacidad matemática.

De los 12 grandes modelos probados, cuatro respondieron correctamente: Alibaba Tongyi Qianwen, Baidu Wenxin Yiyan, Minimax y Tencent Yuanbao. Sin embargo, ocho modelos respondieron incorrectamente: ChatGPT-4o, ByteDance Doubao, Yue Zhi Anmian Kimi, Zhipu Qingyan, Lingyi Wanwu Wan Zhi, Jieyue Xingchen Yuewen, Baichuan Intelligent Baixiaoying y SenseTime Shangliang.

Algunos profesionales del sector opinan que el bajo rendimiento de los grandes modelos en problemas matemáticos se debe a que su diseño se asemeja más al de un estudiante de humanidades que al de un estudiante de ciencias. Los modelos de lenguaje generativos suelen entrenarse prediciendo la siguiente palabra, lo que les permite destacar en el procesamiento de datos lingüísticos, pero se quedan cortos en el razonamiento matemático.

En respuesta a este problema, Yue Zhi Anmian declaró: "En realidad, nuestra exploración de las capacidades de los grandes modelos —tanto de lo que pueden hacer como de lo que no pueden— se encuentra en una etapa muy temprana".

"Esperamos que los usuarios puedan descubrir e informar más casos límite durante su uso, ya sea la reciente pregunta de 'cuál es mayor, 9.9 o 9.11', o la anterior de cuántas 'r' hay en 'strawberry'. El descubrimiento de estos casos límite nos ayuda a comprender mejor los límites de las capacidades de los grandes modelos. Sin embargo, para resolver el problema por completo, no podemos simplemente depender de la reparación individual de cada caso, ya que estas situaciones, al igual que los escenarios que encuentra la conducción autónoma, son difíciles de agotar. Lo que debemos hacer es mejorar continuamente el nivel de inteligencia del modelo base subyacente, haciendo que los grandes modelos sean más potentes y completos, capaces de ofrecer un rendimiento excelente en diversas situaciones complejas y extremas."

Algunos expertos creen que para mejorar la capacidad matemática de los grandes modelos, la clave radica en los datos de entrenamiento. Los grandes modelos de lenguaje se entrenan principalmente con datos de texto de Internet, donde los problemas y soluciones matemáticas son relativamente escasos. Por lo tanto, el entrenamiento futuro de los grandes modelos necesita una construcción más sistemática, especialmente en el ámbito del razonamiento complejo.