Recientemente, los equipos de investigación de Apple y Meta AI han presentado conjuntamente una nueva tecnología llamada LazyLLM, que mejora la eficiencia de los grandes modelos lingüísticos (LLM) en el razonamiento con textos largos.

Como todos sabemos, los LLM actuales suelen ser lentos al procesar prompts largos, especialmente durante la fase de prellenado. Esto se debe principalmente a que la complejidad computacional de la arquitectura Transformer moderna al calcular la atención aumenta cuadráticamente con la cantidad de tokens en el prompt. Por lo tanto, al usar el modelo Llama2, el tiempo de cálculo del primer token suele ser 21 veces mayor que los pasos de decodificación posteriores, ocupando el 23% del tiempo de generación.

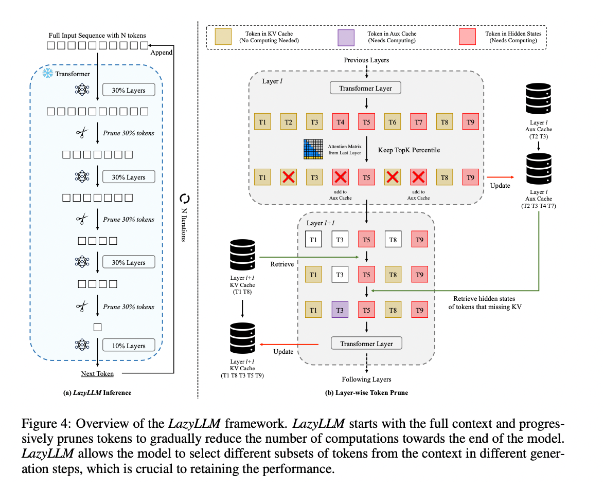

Para mejorar esta situación, los investigadores propusieron LazyLLM, un nuevo método para acelerar la inferencia de LLM mediante la selección dinámica de tokens importantes para el cálculo. El núcleo de LazyLLM radica en que evalúa la importancia de cada token según las puntuaciones de atención de las capas anteriores, reduciendo gradualmente la carga computacional. A diferencia de la compresión permanente, LazyLLM puede restaurar los tokens descartados si es necesario para garantizar la precisión del modelo. Además, LazyLLM introduce un mecanismo llamado Aux Cache que almacena los estados ocultos de los tokens podados, lo que permite restaurar estos tokens de manera eficiente y evitar la disminución del rendimiento.

LazyLLM destaca por su velocidad de inferencia, especialmente en las fases de prellenado y decodificación. Las tres principales ventajas de esta tecnología son: su compatibilidad con cualquier LLM basado en Transformer, la ausencia de necesidad de volver a entrenar el modelo durante su implementación y su gran eficacia en diversas tareas lingüísticas. La estrategia de poda dinámica de LazyLLM le permite reducir significativamente la carga computacional, manteniendo la mayoría de los tokens importantes y, por lo tanto, mejorando la velocidad de generación.

Los resultados de la investigación muestran que LazyLLM ofrece un rendimiento excelente en múltiples tareas lingüísticas, con una mejora de la velocidad TTFT de hasta 2,89 veces (para Llama2) y 4,77 veces (para XGen), manteniendo una precisión casi idéntica a la línea de base. Ya sea en tareas de preguntas y respuestas, generación de resúmenes o completado de código, LazyLLM logra una velocidad de generación más rápida, logrando un buen equilibrio entre rendimiento y velocidad. Su estrategia de poda gradual junto con el análisis por capas son la base del éxito de LazyLLM.

Dirección del artículo: https://arxiv.org/abs/2407.14057

Puntos clave:

🌟 LazyLLM acelera el proceso de inferencia de LLM mediante la selección dinámica de tokens importantes, destacando especialmente en escenarios de textos largos.

⚡ Esta tecnología puede mejorar significativamente la velocidad de inferencia, con una mejora de la velocidad TTFT de hasta 4,77 veces, manteniendo una alta precisión.

🔧 LazyLLM no requiere modificaciones en los modelos existentes y es compatible con cualquier LLM basado en Transformer, lo que facilita su implementación.