Recientemente, Zyphra ha lanzado el nuevo modelo de lenguaje Zamba2-2.7B, un lanzamiento significativo en la historia de los modelos de lenguaje pequeños. Este nuevo modelo presenta mejoras notables en rendimiento y eficiencia, habiendo sido entrenado con aproximadamente 3 billones de tokens, lo que le permite alcanzar un rendimiento comparable a Zamba1-7B y otros modelos líderes de 7B.

Lo más sorprendente es la reducción significativa en los requisitos de recursos durante la inferencia, convirtiéndolo en una solución eficiente para aplicaciones en dispositivos móviles.

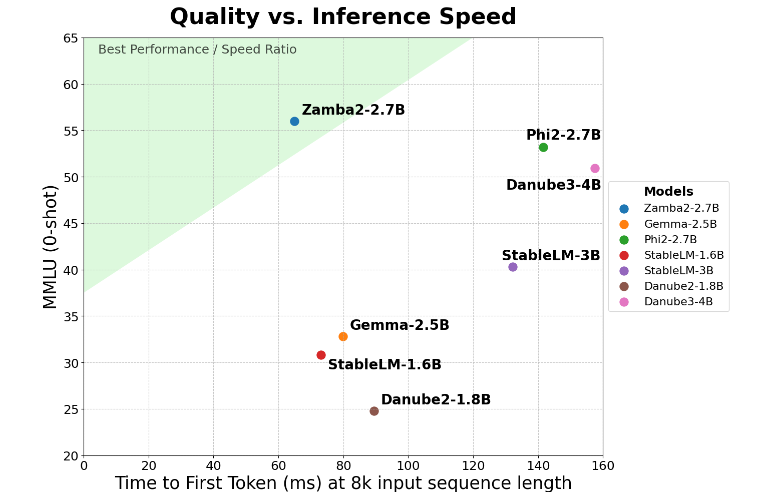

Zamba2-2.7B ha duplicado la velocidad en el tiempo de respuesta inicial, lo que significa que genera respuestas iniciales más rápido que sus competidores. Esto es crucial para aplicaciones que requieren interacción en tiempo real, como asistentes virtuales y chatbots.

Además de la velocidad, Zamba2-2.7B destaca por su excelente gestión de memoria. Reduce el consumo de memoria en un 27%, convirtiéndolo en la opción ideal para su implementación en dispositivos con recursos de memoria limitados. Esta administración inteligente de la memoria garantiza un funcionamiento eficiente incluso en entornos con recursos computacionales restringidos, ampliando su rango de aplicación en diversos dispositivos y plataformas.

Otra ventaja significativa de Zamba2-2.7B es su menor latencia de generación. Comparado con Phi3-3.8B, su latencia se ha reducido 1.29 veces, lo que resulta en interacciones más fluidas. La baja latencia es especialmente importante en aplicaciones que requieren una comunicación fluida e ininterrumpida, como robots de atención al cliente y herramientas educativas interactivas. Por lo tanto, Zamba2-2.7B se convierte en la opción preferida para los desarrolladores que buscan mejorar la experiencia del usuario.

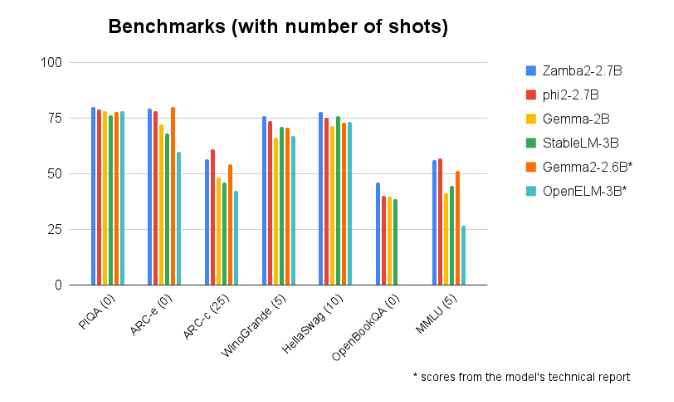

En las comparaciones de referencia con otros modelos de tamaño similar, Zamba2-2.7B ha demostrado un rendimiento superior. Su excelente desempeño demuestra la innovación y el esfuerzo de Zyphra en el avance de la tecnología de inteligencia artificial. Este modelo utiliza un mecanismo de atención compartida entrelazada mejorado y está equipado con proyectores LoRA en los módulos MLP compartidos, garantizando una salida eficiente en el procesamiento de tareas complejas.

Acceso al modelo: https://huggingface.co/Zyphra/Zamba2-2.7B

Puntos clave:

🌟 El modelo Zamba2-2.7B duplica la velocidad de respuesta inicial, ideal para aplicaciones de interacción en tiempo real.

💾 El modelo reduce el consumo de memoria en un 27%, adecuado para dispositivos con recursos limitados.

🚀 Zamba2-2.7B presenta una latencia de generación menor que modelos similares, mejorando la experiencia del usuario.