En el campo de los avatares digitales 3D, a pesar de los avances significativos, los métodos anteriores aún presentan problemas de consistencia multiperspectiva e insuficiente expresividad emocional. Para abordar estos desafíos, un equipo de investigación de la Universidad de Nanjing, la Universidad de Fudan y el laboratorio Huawei Noah's Ark ha logrado un nuevo avance.

Acceso al producto: https://nju-3dv.github.io/projects/EmoTalk3D/

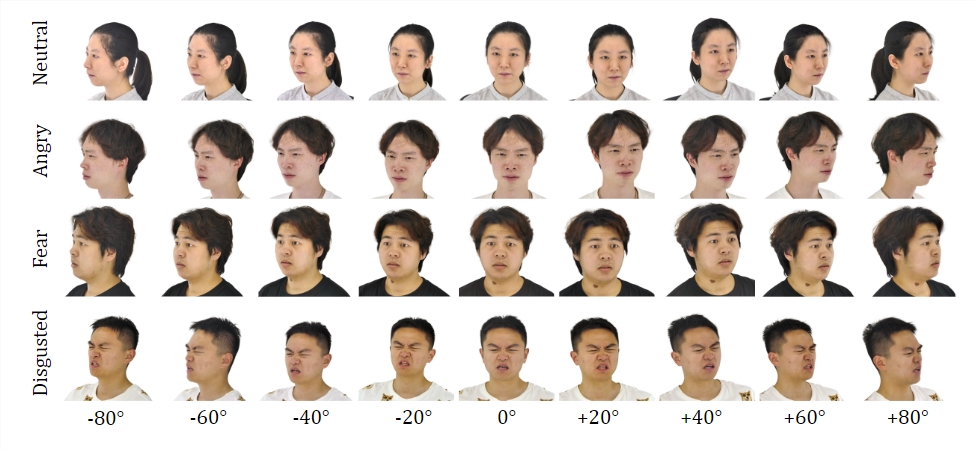

Han recopilado el conjunto de datos EmoTalk3D, que incluye videos multiperspectivos calibrados, etiquetas emocionales y geometría 3D fotograma a fotograma. Y han propuesto un nuevo método para sintetizar avatares de habla 3D con emociones controlables, con mejoras significativas en la sincronización labial y la calidad de renderizado.

Conjunto de datos:

Mediante el entrenamiento en el conjunto de datos EmoTalk3D, el equipo de investigación construyó un marco de mapeo "de voz a geometría y luego a apariencia". Primero, se predice una secuencia de geometría 3D realista a partir de las características de audio, y luego, basándose en la geometría predicha, se sintetiza la apariencia del avatar de habla 3D representada por una Gaussiana 4D. La apariencia se descompone aún más en Gaussianas estándar y dinámicas, aprendidas a partir de videos multiperspectivos y fusionadas para presentar animaciones de avatares de habla con libertad de perspectiva.

El modelo puede lograr emociones controlables en los avatares de habla generados y puede renderizarse en una amplia gama de perspectivas. Al capturar detalles dinámicos del rostro, como arrugas y expresiones sutiles, muestra una calidad y estabilidad de renderizado mejoradas en la generación del movimiento de labios. En los ejemplos de los resultados generados, se muestran con precisión las expresiones de alegría, enojo y tristeza del avatar digital 3D.

Su flujo general incluye cinco módulos:

Primero, un codificador de descomposición de contenido emocional, que analiza las características de contenido y emoción del habla de entrada; segundo, una red de voz a geometría, que predice la nube de puntos 3D dinámica a partir de las características; tercero, un módulo de optimización y compleción gaussiana, que establece la apariencia estándar; cuarto, una red de geometría a apariencia, que sintetiza la apariencia facial basada en la nube de puntos 3D dinámica; y quinto, un módulo de renderizado, que renderiza la Gaussiana dinámica en una animación de perspectiva libre.

Además, han creado el conjunto de datos EmoTalk3D, un conjunto de datos de avatares de habla multiperspectivos con etiquetas emocionales y forma facial 3D fotograma a fotograma, y lo pondrán a disposición del público para fines de investigación no comercial.

Puntos clave:

💥 Se propone un nuevo método para sintetizar avatares digitales con emociones controlables.

🎯 Se construye un marco de mapeo "de voz a geometría y luego a apariencia".

👀 Se crea el conjunto de datos EmoTalk3D y se prepara para su publicación.