En la actualidad, el campo del procesamiento del lenguaje natural (PNL) está experimentando un rápido desarrollo. Los grandes modelos de lenguaje (LLM) pueden realizar tareas lingüísticas complejas con alta precisión, abriendo nuevas posibilidades para la interacción humano-máquina. Sin embargo, existe un problema notable en el PNL: la evaluación de los modelos depende en gran medida de las anotaciones humanas.

Los datos generados por humanos son cruciales para el entrenamiento y la validación de los modelos, pero recopilar estos datos es costoso y consume mucho tiempo. Además, a medida que los modelos mejoran, las anotaciones recopiladas previamente pueden necesitar actualizaciones, lo que reduce su utilidad al evaluar nuevos modelos. Esto lleva a la necesidad de obtener continuamente nuevos datos, lo que plantea desafíos para la escalabilidad y sostenibilidad de la evaluación efectiva de los modelos.

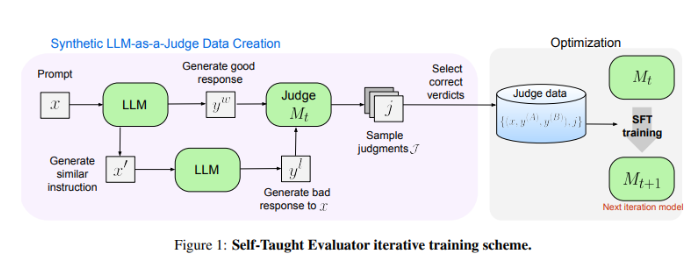

Los investigadores de Meta FAIR presentan una solución innovadora: el "Evaluador Autodidacta" (Self-Taught Evaluator). Este método no requiere anotaciones humanas, sino que utiliza datos sintéticos generados para el entrenamiento. Primero, se generan pares de preferencias sintéticas de contraste utilizando un modelo semilla. Luego, el modelo evalúa estos pares e iterativamente se mejora a sí mismo, utilizando su propio juicio para aumentar su rendimiento en iteraciones posteriores, reduciendo considerablemente la dependencia de las anotaciones humanas.

Los investigadores utilizaron el modelo Llama-3-70B-Instruct para probar el rendimiento del "Evaluador Autodidacta". Este método mejoró la precisión del modelo en el benchmark RewardBench del 75.4% al 88.7%, alcanzando incluso un rendimiento superior al de los modelos entrenados con anotaciones humanas. Después de varias iteraciones, el modelo final alcanzó una precisión del 88.3% en una sola inferencia y del 88.7% con votación mayoritaria, demostrando su sólida estabilidad y fiabilidad.

El "Evaluador Autodidacta" ofrece una solución escalable y eficiente para la evaluación de modelos de PNL. Al utilizar datos sintéticos y la mejora iterativa automática, aborda los desafíos de la dependencia de las anotaciones humanas y promueve el desarrollo de modelos de lenguaje.

Enlace al artículo:https://arxiv.org/abs/2408.02666

Puntos clave:

- 😃La evaluación de los modelos de PNL depende de las anotaciones humanas, lo que genera altos costos de recopilación de datos, consume mucho tiempo y su utilidad disminuye fácilmente.

- 🤖Meta FAIR presenta el "Evaluador Autodidacta", que utiliza datos sintéticos para el entrenamiento y reduce la dependencia de las anotaciones humanas.

- 💪El "Evaluador Autodidacta" presenta un rendimiento excepcional, mejorando significativamente la precisión del modelo en las pruebas y mostrando una estabilidad y fiabilidad sólidas.