En el mundo de la inteligencia artificial, existe un grupo especial de "pintores": las estructuras jerárquicas de los modelos Transformer. Son como pinceles mágicos que pintan un mundo rico y colorido en el lienzo del lenguaje. Recientemente, un artículo titulado "Capas Transformer como Pintores" nos ofrece una nueva perspectiva para comprender el mecanismo de funcionamiento de las capas intermedias de los Transformer.

Los modelos Transformer, como los modelos de lenguaje grandes más populares en la actualidad, poseen miles de millones de parámetros. Cada capa es como un pintor que, en conjunto, completa un gran cuadro lingüístico. Pero, ¿cómo colaboran estos "pintores"? ¿Qué diferencia hay entre sus "pinceles" y "pinturas"? Este artículo intenta responder a estas preguntas.

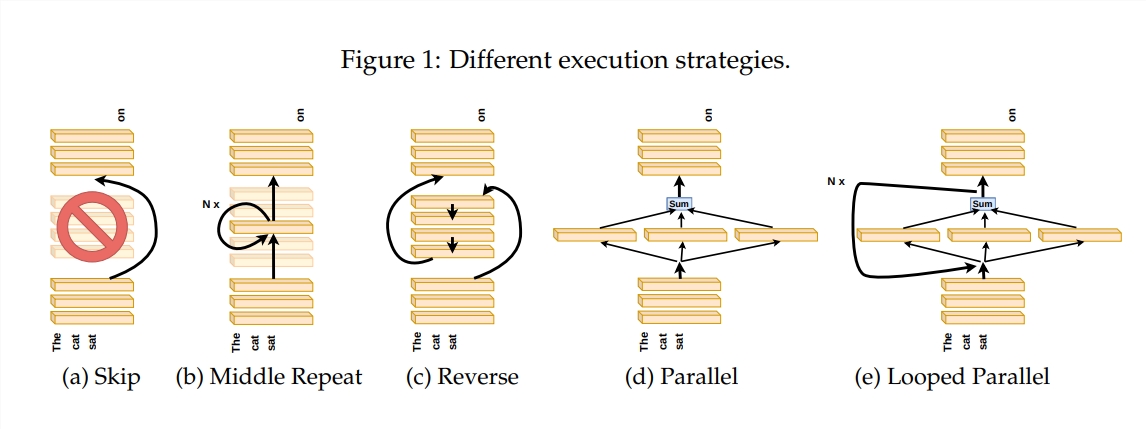

Para investigar el funcionamiento de las capas Transformer, los autores diseñaron una serie de experimentos, incluyendo omitir ciertas capas, cambiar el orden de las capas o ejecutarlas en paralelo. Estos experimentos son como establecer diferentes reglas de pintura para los "pintores", para ver si pueden adaptarse.

En la metáfora de la "línea de montaje de pintores", la entrada se considera un lienzo, y el proceso a través de las capas intermedias es como la transmisión del lienzo en la línea de montaje. Cada "pintor", es decir, cada capa del Transformer, modifica la obra de acuerdo con su propia especialidad. Esta analogía nos ayuda a comprender la capacidad de procesamiento paralelo y la flexibilidad de las capas Transformer.

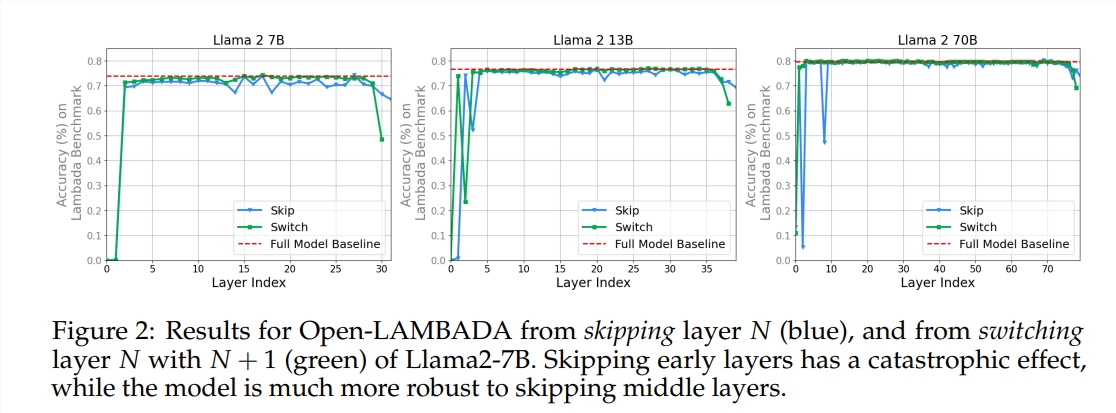

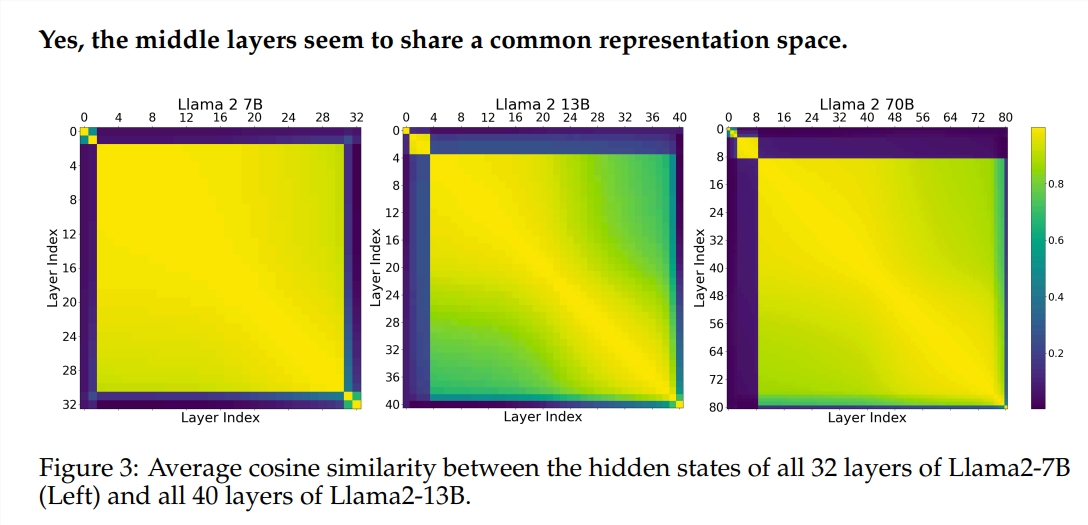

Los experimentos utilizaron dos modelos de lenguaje grandes (LLM) preentrenados: Llama2-7B y BERT. Los resultados mostraron que los "pintores" de las capas intermedias parecen compartir una "paleta de colores" común: el espacio de representación, a diferencia de las capas inicial y final. Omitir algunos "pintores" de las capas intermedias no tiene un gran impacto en la obra completa, lo que indica que no todos los "pintores" son necesarios.

Aunque los "pintores" de las capas intermedias utilizan la misma "paleta de colores", utilizan sus propias habilidades para crear diferentes patrones en el lienzo. Si simplemente se repite la habilidad de un "pintor", la obra perderá su encanto original.

Para tareas matemáticas y de razonamiento que requieren una lógica estricta, el orden de "pintura" es especialmente importante. Sin embargo, para tareas que dependen de la comprensión semántica, la influencia del orden es relativamente menor.

Los resultados de la investigación muestran que las capas intermedias del Transformer tienen un cierto grado de consistencia, pero no son redundantes. Para tareas matemáticas y de razonamiento, el orden de las capas es más importante que para las tareas semánticas.

El estudio también descubrió que no todas las capas son necesarias, y las capas intermedias se pueden omitir sin afectar catastróficamente el rendimiento del modelo. Además, aunque las capas intermedias comparten el mismo espacio de representación, realizan funciones diferentes. Cambiar el orden de ejecución de las capas provoca una disminución del rendimiento, lo que indica que el orden tiene una influencia importante en el rendimiento del modelo.

En el camino de explorar los modelos Transformer, muchos investigadores están intentando optimizarlos, incluyendo la poda, la reducción de parámetros, etc. Estos trabajos proporcionan valiosas experiencias e ideas para comprender los modelos Transformer.

Dirección del artículo: https://arxiv.org/pdf/2407.09298v1