En un mundo digital dominado por datos y algoritmos, cada avance en inteligencia artificial depende de un elemento clave: el punto de control (Checkpoint). Imagine que está entrenando un gran modelo de lenguaje capaz de comprender las emociones humanas y mantener conversaciones fluidas. Este modelo es extremadamente inteligente, pero también un "gloton", que requiere una enorme cantidad de recursos computacionales para su "alimentación". Durante el entrenamiento, una interrupción del suministro eléctrico o un fallo de hardware podrían provocar pérdidas considerables. Aquí es donde el punto de control actúa como una "máquina del tiempo", permitiendo que todo vuelva a un estado seguro anterior y continúe la tarea inconclusa.

Sin embargo, esta "máquina del tiempo" también requiere un diseño cuidadoso. Científicos de ByteDance y la Universidad de Hong Kong, en su artículo "ByteCheckpoint: A Unified Checkpointing System for LLM Development", nos presentan un nuevo sistema de puntos de control: ByteCheckpoint. No se trata simplemente de una herramienta de copia de seguridad, sino de un artefacto que mejora significativamente la eficiencia del entrenamiento de grandes modelos de lenguaje.

Primero, debemos comprender los desafíos que enfrentan los grandes modelos de lenguaje (LLM). Estos modelos son "grandes" porque necesitan procesar y memorizar una cantidad ingente de información, lo que resulta en altos costos de entrenamiento, un gran consumo de recursos y una baja tolerancia a fallos. Si ocurre un fallo, el largo entrenamiento podría perderse por completo.

El sistema de puntos de control es como una "instantánea" del modelo, que guarda periódicamente el estado durante el entrenamiento. De esta manera, incluso si surge un problema, se puede restaurar rápidamente al estado más reciente, minimizando las pérdidas. Sin embargo, los sistemas de puntos de control existentes, al procesar modelos grandes, a menudo sufren ineficiencias debido a cuellos de botella de E/S (entrada/salida).

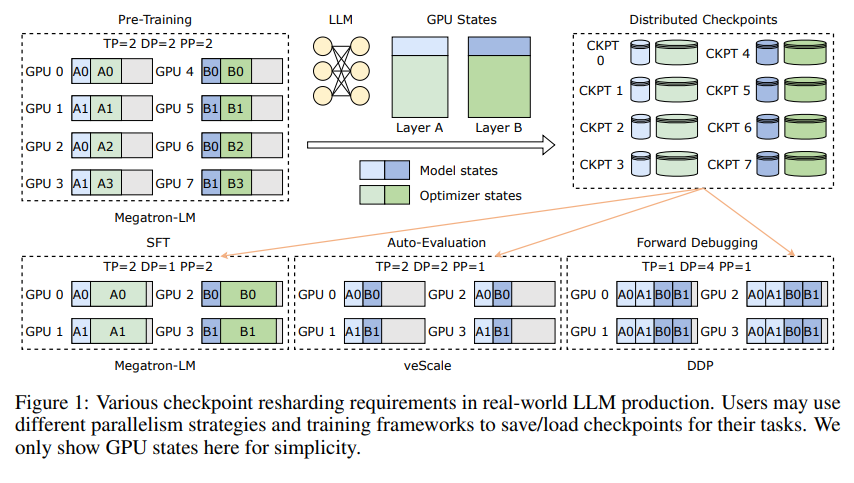

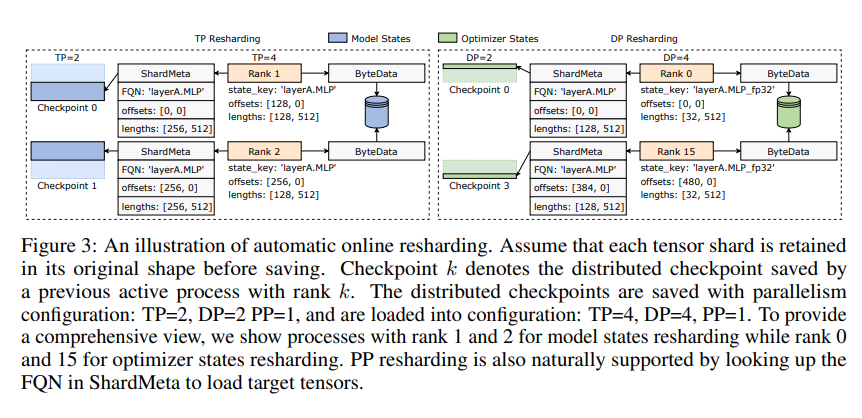

La innovación de ByteCheckpoint radica en una novedosa arquitectura de almacenamiento que separa los datos de los metadatos, permitiendo un manejo más flexible de diferentes configuraciones paralelas y marcos de entrenamiento. Además, admite el re-particionado automático de puntos de control en línea, lo que permite ajustar dinámicamente los puntos de control para adaptarse a diferentes entornos de hardware sin interrumpir el entrenamiento.

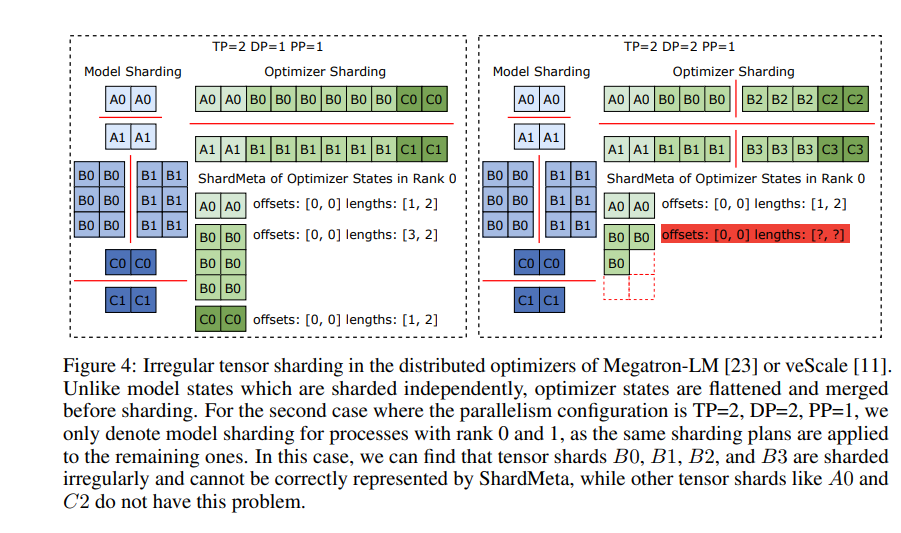

ByteCheckpoint también introduce una tecnología clave: la fusión asíncrona de tensores. Esto permite procesar eficientemente los tensores distribuidos de manera desigual en diferentes GPU, garantizando la integridad y coherencia del modelo durante el re-particionado de los puntos de control.

Para mejorar la velocidad de guardado y carga de los puntos de control, ByteCheckpoint integra una serie de medidas de optimización del rendimiento de E/S, como una canalización de guardado/carga refinada, un pool de memoria Ping-Pong, un guardado de carga de trabajo equilibrado y una carga sin redundancia, lo que reduce significativamente el tiempo de espera durante el entrenamiento.

Las pruebas experimentales demuestran que, en comparación con los métodos tradicionales, ByteCheckpoint aumenta la velocidad de guardado y carga de los puntos de control en decenas o incluso cientos de veces, mejorando significativamente la eficiencia del entrenamiento de grandes modelos de lenguaje.

ByteCheckpoint no es solo un sistema de puntos de control, sino un asistente valioso en el entrenamiento de grandes modelos de lenguaje, una pieza clave para un entrenamiento de IA más eficiente y estable.

Enlace del artículo: https://arxiv.org/pdf/2407.20143