Recientemente, Alibaba Cloud lanzó el importante modelo de lenguaje grande Qwen2-Math, un nuevo talento de IA especializado en matemáticas que ha generado un gran interés en la industria desde su aparición.

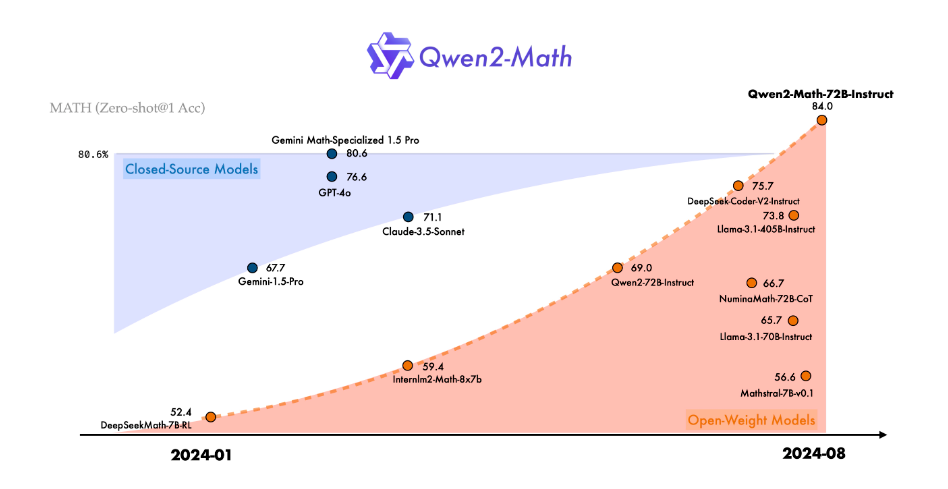

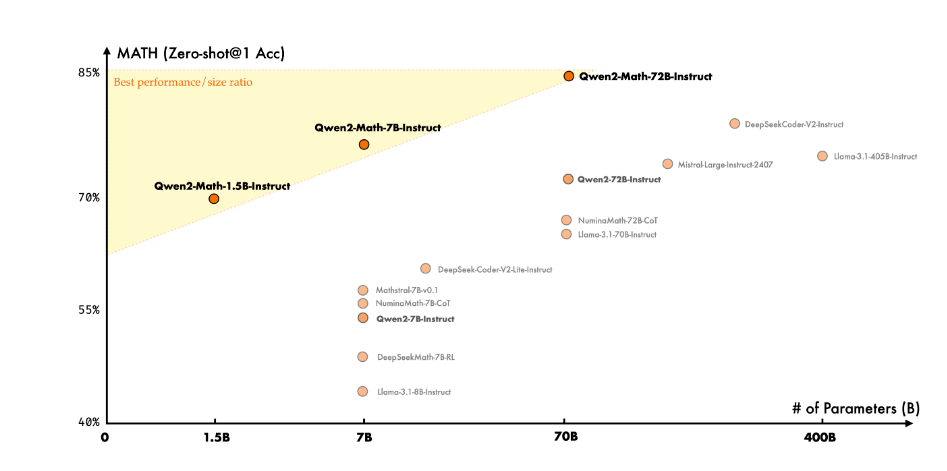

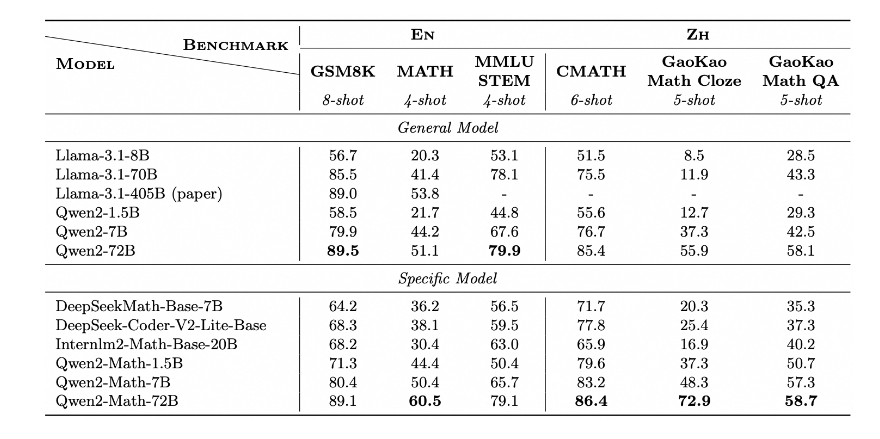

Como el miembro más reciente de la serie Qwen2, los modelos Qwen2-Math y Qwen2-Math-Instruct-1.5B/7B/72B han demostrado una capacidad asombrosa para resolver problemas matemáticos. Se dice que esta serie de modelos no solo supera a los modelos de código abierto existentes en varias pruebas de referencia matemáticas, sino que también supera en algunos aspectos a modelos de código cerrado conocidos como GPT-4o, Claude-3.5-Sonnet, Gemini-1.5-Pro y Llama-3.1-405B, convirtiéndose en un verdadero "caballo negro" en el mundo de las matemáticas de la IA.

El éxito de Qwen2-Math no es casualidad. El equipo de Alibaba Cloud ha dedicado mucho esfuerzo durante el último año para mejorar la capacidad de razonamiento de los modelos de lenguaje grandes en problemas aritméticos y matemáticos. Esta serie de modelos se basa en Qwen2-1.5B/7B/72B, y el equipo de desarrollo, sobre esta base, ha realizado un entrenamiento profundo utilizando un corpus de datos matemáticos especialmente diseñado. Este corpus único incluye una gran cantidad de textos matemáticos de alta calidad de la web, libros especializados, ejemplos de código y una gran cantidad de exámenes, incluso datos de entrenamiento matemático generados por el propio Qwen2.

Cabe destacar el modelo Qwen2-Math-Instruct. Este modelo de recompensa matemática especializado, entrenado sobre Qwen2-Math-72B, utiliza un método de entrenamiento innovador. El equipo de desarrollo combinó ingeniosamente señales de recompensa densas con señales binarias de si la respuesta del modelo es correcta o incorrecta, utilizando esta señal combinada como señal de supervisión. A través del muestreo de rechazo, construyeron datos SFT (Supervised Fine-Tuning) y aplicaron la técnica de optimización de políticas relativas de grupo (GRPO) en el aprendizaje por refuerzo posterior al SFT. Este método de entrenamiento único ha mejorado enormemente la capacidad del modelo para resolver problemas matemáticos.

En aplicaciones prácticas, Qwen2-Math-Instruct ha demostrado un rendimiento sorprendente. Tanto en el AIME (Examen de Matemáticas de la Invitación Americana) de 2024 como en el AMC (Concurso de Matemáticas Americano) de 2023, el modelo ha obtenido excelentes resultados en diversas configuraciones, incluyendo estrategias como búsqueda voraz (Greedy), votación mayoritaria y minimización de riesgos.

Más emocionante aún, Qwen2-Math también ha demostrado una capacidad notable para resolver algunos problemas difíciles del nivel de las Olimpiadas Internacionales de Matemáticas (IMO). A través del análisis de una serie de casos de prueba, los investigadores descubrieron que Qwen2-Math no solo puede manejar fácilmente problemas de concursos matemáticos simples, sino que también puede proporcionar soluciones convincentes para problemas complejos.

Sin embargo, el equipo de Alibaba Cloud no se detiene ahí. Han revelado que la serie actual de Qwen2-Math solo admite inglés, pero están desarrollando activamente un modelo bilingüe que admite inglés y chino, y planean lanzar una versión multilingüe en un futuro próximo. Además, el equipo continúa optimizando el modelo para mejorar aún más su capacidad para resolver problemas matemáticos más complejos y desafiantes.

La aparición de Qwen2-Math ha abierto sin duda nuevas posibilidades para la aplicación de la IA en el campo de las matemáticas. No solo revolucionará la educación, ayudando a los estudiantes a comprender y dominar mejor las matemáticas, sino que también podría desempeñar un papel importante en la investigación científica, la ingeniería y otros campos que requieren cálculos matemáticos complejos.

Página del proyecto: https://top.aibase.com/tool/qwen2-math

Descarga del modelo: https://huggingface.co/Qwen