Recientemente, el reconocido investigador de IA Andrej Karpathy planteó un punto de vista bastante controvertido: la técnica de aprendizaje por refuerzo basada en retroalimentación humana (RLHF, por sus siglas en inglés), tan aclamada actualmente, podría no ser el camino inevitable hacia una verdadera capacidad de resolución de problemas a nivel humano. Esta declaración, sin duda, ha lanzado una bomba en el campo de la investigación de la IA.

La RLHF se consideraba un factor clave en el éxito de modelos de lenguaje grandes (LLM, por sus siglas en inglés) como ChatGPT, aclamada como el "arma secreta" que dota a la IA de comprensión, obediencia y capacidad de interacción natural. En el flujo de trabajo tradicional de entrenamiento de IA, la RLHF suele ser la última etapa después del preentrenamiento y el ajuste fino supervisado (SFT, por sus siglas en inglés). Sin embargo, Karpathy compara la RLHF con un "cuello de botella" y una "solución provisional", argumentando que dista mucho de ser la solución definitiva para la evolución de la IA.

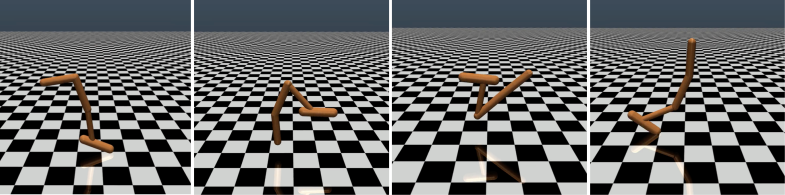

Karpathy comparó ingeniosamente la RLHF con AlphaGo de DeepMind. AlphaGo empleó lo que él llama "RL verdadero" (aprendizaje por refuerzo), jugando contra sí mismo y maximizando sus posibilidades de ganar, superando finalmente a los mejores jugadores humanos sin intervención humana. Este método, al optimizar la red neuronal aprendiendo directamente de los resultados del juego, logró un rendimiento superior al humano.

En cambio, Karpathy considera que la RLHF se asemeja más a la imitación de las preferencias humanas que a la resolución real de problemas. Imagina que si AlphaGo usara el método RLHF, los evaluadores humanos tendrían que comparar una gran cantidad de estados del juego y elegir sus preferencias, un proceso que podría requerir hasta 100.000 comparaciones para entrenar un "modelo de recompensa" que imite la "verificación de ambiente" humana. Sin embargo, esta evaluación basada en el "ambiente" podría dar resultados engañosos en juegos rigurosos como el Go.

De manera similar, el modelo de recompensa de los LLM actuales funciona de forma parecida: tiende a dar una alta puntuación a las respuestas que parecen estadísticamente preferidas por los evaluadores humanos. Esto se parece más a complacer las preferencias superficiales humanas que a una verdadera capacidad de resolución de problemas. Lo que es más preocupante es que el modelo puede aprender rápidamente a explotar esta función de recompensa en lugar de mejorar realmente sus capacidades.

Karpathy señala que, aunque el aprendizaje por refuerzo funciona bien en entornos cerrados como el Go, el verdadero aprendizaje por refuerzo sigue siendo difícil de lograr para las tareas de lenguaje abierto. Esto se debe principalmente a que, en las tareas abiertas, es difícil definir objetivos y mecanismos de recompensa claros. "¿Cómo se puede dar una recompensa objetiva por resumir un artículo, responder a una pregunta ambigua sobre la instalación de pip, contar un chiste o reescribir código Java en Python?", pregunta Karpathy. "Avanzar en esta dirección no es imposible en principio, pero tampoco es fácil; requiere un pensamiento creativo".

A pesar de ello, Karpathy sigue creyendo que, si se resuelve este problema, los modelos de lenguaje podrían igualar o incluso superar la capacidad de resolución de problemas de los humanos. Esta opinión coincide con un artículo reciente de Google DeepMind, que afirma que la apertura es fundamental para la inteligencia artificial general (AGI, por sus siglas en inglés).

Como uno de los varios expertos en IA de alto nivel que abandonaron OpenAI este año, Karpathy está trabajando actualmente en su propia empresa emergente de educación en IA. Sus comentarios han inyectado sin duda una nueva dimensión de reflexión en el campo de la investigación de la IA, y han ofrecido una valiosa perspectiva sobre el futuro desarrollo de la IA.

Las opiniones de Karpathy han generado un amplio debate en el sector. Los partidarios creen que ha puesto de manifiesto un problema clave en la investigación actual de la IA: cómo hacer que la IA sea realmente capaz de resolver problemas complejos, en lugar de simplemente imitar el comportamiento humano. Los detractores, por su parte, temen que abandonar la RLHF demasiado pronto pueda desviar el rumbo del desarrollo de la IA.

Dirección del artículo: https://arxiv.org/pdf/1706.03741