En el campo de la inteligencia artificial, lograr que las máquinas comprendan el complejo mundo físico de la misma manera que los humanos ha sido un desafío importante. Recientemente, un equipo de investigación compuesto por instituciones como la Universidad del Pueblo Chino, la Universidad de Ciencia y Tecnología de Beijing y el Shanghai AI Lab, ha presentado una tecnología innovadora: Ref-AVS, ofreciendo una nueva esperanza para resolver este problema.

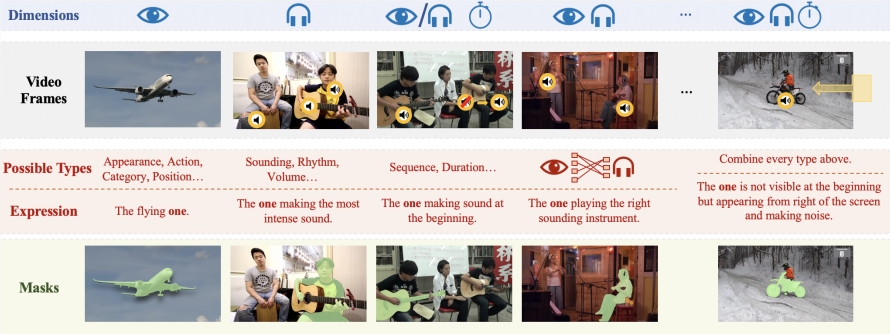

El núcleo de la tecnología Ref-AVS radica en su singular método de fusión multimodal. Integra inteligentemente información de múltiples modalidades, como la segmentación de objetos de vídeo (VOS), la segmentación de objetos de vídeo con referencia (Ref-VOS) y la segmentación audiovisual (AVS). Esta fusión innovadora permite que el sistema de IA no solo procese objetos que emiten sonido, sino que también identifique objetos en la escena que no emiten sonido pero que son igualmente importantes. Este avance permite a la IA comprender con mayor precisión las instrucciones descritas por el usuario mediante lenguaje natural y localizar objetos específicos con precisión en escenas audiovisuales complejas.

Para respaldar la investigación y la validación de la tecnología Ref-AVS, el equipo de investigación ha creado un conjunto de datos a gran escala llamado Ref-AVS Bench. Este conjunto de datos contiene 40.020 fotogramas de vídeo, que abarcan 6.888 objetos y 20.261 expresiones de referencia. Cada fotograma de vídeo cuenta con las anotaciones detalladas correspondientes de audio y píxeles. Este conjunto de datos rico y diverso proporciona una base sólida para la investigación multimodal y abre nuevas posibilidades para futuras investigaciones en campos relacionados.

En una serie de rigurosos experimentos cuantitativos y cualitativos, la tecnología Ref-AVS ha demostrado un rendimiento excepcional. En particular, en el subconjunto Seen, el rendimiento de Ref-AVS superó a otros métodos existentes, demostrando plenamente su potente capacidad de segmentación. Más notable aún, los resultados de las pruebas en los subconjuntos Unseen y Null verificaron aún más la excelente capacidad de generalización de la tecnología Ref-AVS y su robustez ante referencias nulas, lo cual es crucial para las aplicaciones del mundo real.

El éxito de la tecnología Ref-AVS no solo ha llamado la atención en el ámbito académico, sino que también ha abierto nuevas vías para futuras aplicaciones prácticas. Podemos prever que esta tecnología desempeñará un papel importante en diversos campos, como el análisis de vídeo, el procesamiento de imágenes médicas, la conducción autónoma y la navegación robótica. Por ejemplo, en el ámbito médico, Ref-AVS podría ayudar a los médicos a interpretar imágenes médicas complejas con mayor precisión; en el campo de la conducción autónoma, podría mejorar la capacidad del vehículo para percibir el entorno; y en la robótica, podría permitir a los robots comprender y ejecutar mejor las instrucciones verbales de los humanos.

Los resultados de esta investigación se presentaron en ECCV2024, y la información relacionada con el artículo y el proyecto también se ha publicado públicamente, proporcionando a los investigadores y desarrolladores de todo el mundo interesados en este campo valiosos recursos para el aprendizaje y la exploración. Esta actitud de apertura y compartición no solo refleja el espíritu académico del equipo de investigación chino, sino que también impulsará el rápido desarrollo de todo el campo de la IA.

La aparición de la tecnología Ref-AVS marca un paso importante en la comprensión multimodal de la inteligencia artificial. No solo demuestra la capacidad de innovación del equipo de investigación chino en el campo de la IA, sino que también describe un panorama más inteligente y natural para el futuro de la interacción humano-máquina. Con el continuo perfeccionamiento y aplicación de esta tecnología, tenemos razones para esperar que los futuros sistemas de IA puedan comprender y adaptarse mejor al complejo mundo humano, aportando cambios revolucionarios a todos los sectores.

Dirección del artículo: https://arxiv.org/abs/2407.10957

Página principal del proyecto: