Recientemente, un equipo de investigación de NVIDIA, en colaboración con Georgia Tech, UMD y HKPU, presentó un nuevo modelo de lenguaje visual: NVEagle. Este modelo puede "entender" imágenes y conversar contigo, funcionando como un asistente súper inteligente con capacidades visuales y conversacionales.

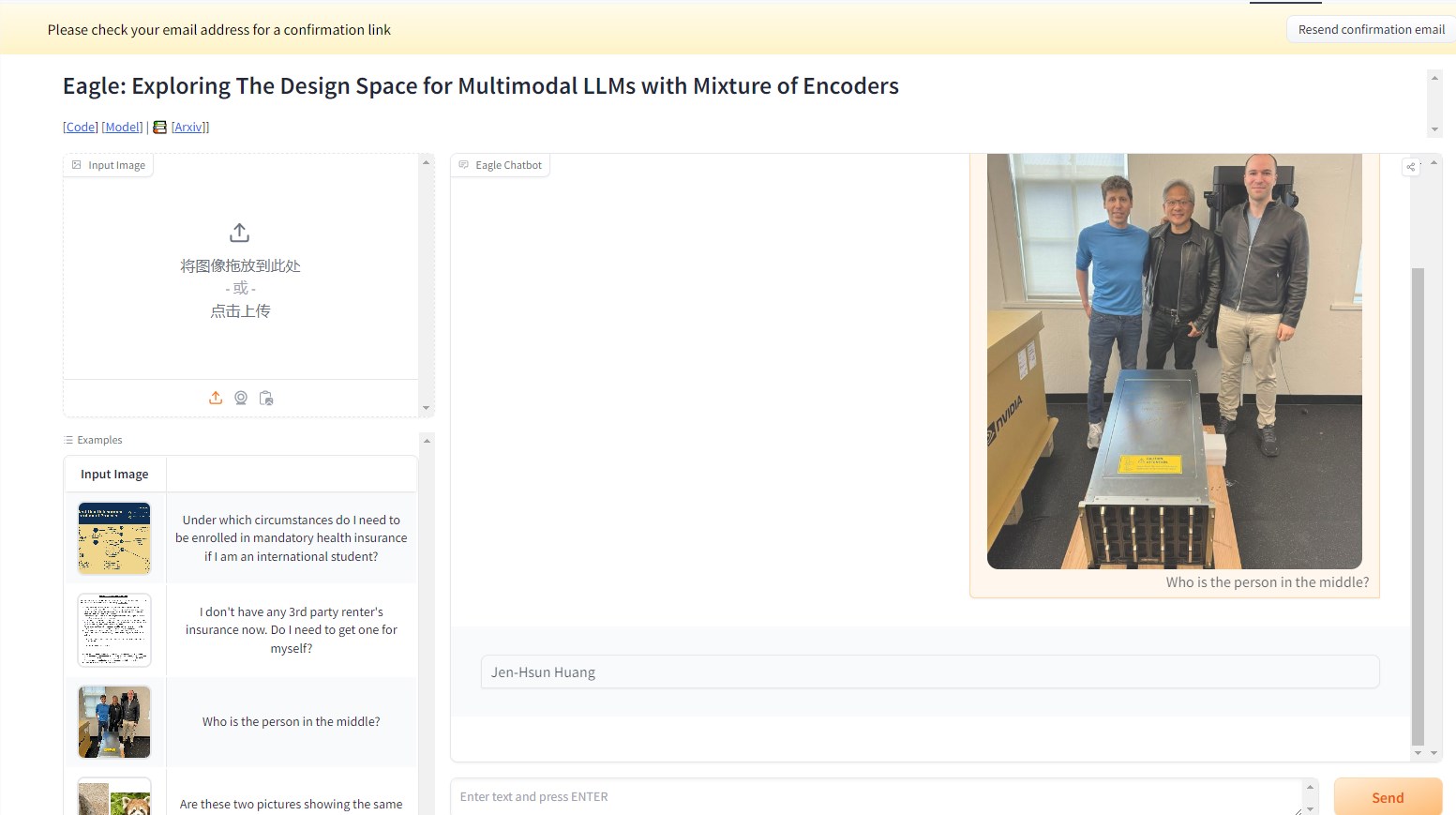

Por ejemplo, en el siguiente caso, al preguntar a NVEagle quién es la persona en la imagen, el modelo interpreta la imagen y responde correctamente: Jensen Huang.

Este gran modelo de lenguaje multimodal (MLLM) representa un avance significativo en la combinación de información visual y lingüística. NVEagle puede comprender escenas complejas del mundo real y responder mejor a través de la entrada visual. Su diseño se centra en convertir imágenes en marcadores visuales que se combinan con incrustaciones de texto, mejorando así la comprensión de la información visual.

Sin embargo, la construcción de un modelo tan potente presenta desafíos, especialmente en la mejora de la capacidad de percepción visual. Los estudios demuestran que muchos modelos existentes presentan "alucinaciones" al procesar imágenes de alta resolución, es decir, generan resultados inexactos o sin sentido. Esto es especialmente evidente en tareas que requieren un análisis detallado, como el reconocimiento óptico de caracteres (OCR) y la comprensión de documentos. Para superar estas dificultades, el equipo de investigación exploró varios métodos, incluyendo la prueba de diferentes codificadores visuales y estrategias de fusión.

El lanzamiento de NVEagle es el resultado de esta investigación, e incluye tres versiones: Eagle-X5-7B, Eagle-X5-13B y Eagle-X5-13B-Chat. Las versiones 7B y 13B se utilizan principalmente para tareas generales de lenguaje visual, mientras que la versión 13B-Chat está específicamente optimizada para la IA conversacional, permitiendo interacciones más fluidas basadas en entradas visuales.

Un aspecto destacado de NVEagle es el uso del mecanismo de experto mixto (MoE), que selecciona dinámicamente el codificador visual más adecuado para diferentes tareas, mejorando en gran medida el procesamiento de información visual compleja. El modelo ya está disponible en Hugging Face para que investigadores y desarrolladores lo utilicen.

En diversas pruebas de referencia, el modelo Eagle ha demostrado un rendimiento excepcional. Por ejemplo, en la tarea de OCR, el modelo Eagle obtuvo una puntuación media de 85,9 en OCRBench, superando a otros modelos líderes como InternVL y LLaVA-HR. En la prueba TextVQA, obtuvo una puntuación de 88,8, mostrando un buen desempeño en tareas complejas de preguntas y respuestas visuales, con una puntuación de 65,7 en la prueba GQA. Además, el rendimiento del modelo mejora continuamente al agregar expertos visuales adicionales.

La serie de modelos NVEagle, a través de una exploración y optimización sistemática del diseño, ha resuelto con éxito varios desafíos clave en la percepción visual, abriendo nuevas posibilidades para el desarrollo de modelos de lenguaje visual.

Enlace al proyecto: https://top.aibase.com/tool/eagle

Demo: https://huggingface.co/spaces/NVEagle/Eagle-X5-13B-Chat

Puntos clave:

🌟 NVEagle es un modelo de lenguaje visual de última generación desarrollado por NVIDIA, diseñado para mejorar la comprensión de información visual compleja.

📈 El modelo incluye tres versiones para diferentes tareas, siendo la versión 13B-Chat la enfocada en IA conversacional.

🏆 En múltiples pruebas de referencia, el modelo Eagle supera a muchos modelos líderes existentes, demostrando un rendimiento excepcional.