Google anunció hoy el lanzamiento de su nueva y mejorada serie de modelos Gemini, incluyendo Gemini-1.5-Pro-002 y Gemini-1.5-Flash-002. Esta actualización no solo mejora significativamente el rendimiento, sino que también ofrece sorprendentes descuentos en precios, lo que sin duda generará un gran interés en el mundo del desarrollo de IA.

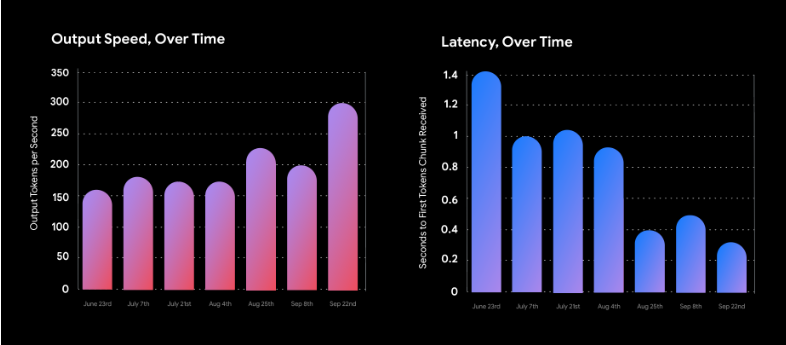

En primer lugar, lo más llamativo es la considerable reducción de precios. El coste de uso de los nuevos modelos se ha reducido a la mitad, con una bajada superior al 50%. Al mismo tiempo, el rendimiento ha mejorado notablemente. La velocidad de procesamiento de Gemini 1.5 Flash se ha duplicado, mientras que la de 1.5 Pro se ha casi triplicado. Esto significa que los desarrolladores pueden obtener una salida más rápida y una latencia menor a un coste inferior, lo que aumenta considerablemente la eficiencia del desarrollo.

En cuanto al rendimiento, los nuevos modelos Gemini muestran una mejora general. Los avances son especialmente notables en matemáticas, procesamiento de textos largos y tareas visuales. Por ejemplo, el modelo ahora puede procesar fácilmente documentos PDF de más de 1000 páginas, responder preguntas que incluyen miles de líneas de código e incluso extraer información útil de un vídeo de una hora. En la prueba de referencia MMLU-Pro, un desafío considerable, el nuevo modelo ha logrado una mejora del rendimiento de aproximadamente el 7%. Aún más impresionante es la mejora del 20% en las pruebas de referencia MATH y HiddenMath.

Google también ha optimizado la calidad de respuesta del modelo. La nueva versión, además de garantizar la seguridad del contenido, proporciona respuestas más útiles y concisas. En tareas como el resumen, las preguntas y respuestas y la extracción de información, la longitud de la salida se ha reducido entre un 5% y un 20%, lo que no solo aumenta la eficiencia, sino que también reduce aún más los costes de uso.

Para los usuarios empresariales, la capacidad de procesamiento de textos largos de Gemini 1.5 Pro (hasta 2 millones de palabras) y sus capacidades multimodales abren nuevas posibilidades de aplicación. A partir del 1 de octubre de 2024, el precio de los tokens de entrada, los tokens de salida y los tokens de caché incrementales se reducirá en un 64%, 52% y 64%, respectivamente, lo que sin duda reducirá considerablemente el coste del uso de la IA para las empresas.

En cuanto a las limitaciones de uso, Google también ha realizado importantes ajustes. El límite de velocidad del servicio de pago de Gemini 1.5 Flash se ha aumentado a 2000 solicitudes por minuto, mientras que el de 1.5 Pro se ha aumentado a 1000, lo que ofrece a los desarrolladores una mayor flexibilidad.

La seguridad siempre ha sido una prioridad para Google. El nuevo modelo, además de seguir las instrucciones del usuario, ha mejorado aún más su seguridad. Google también ha ajustado la configuración predeterminada de los filtros, dando a los desarrolladores más autonomía.

Además, Google ha lanzado una versión mejorada del modelo experimental Gemini 1.5 Flash-8B, que ofrece un excelente rendimiento en aplicaciones de texto y multimodales. Esta versión ya está disponible en Google AI Studio y Gemini API, ofreciendo a los desarrolladores más opciones.

Los usuarios de Gemini Advanced pronto podrán disfrutar de la versión Gemini 1.5 Pro-002, optimizada para chat.