Recientemente, Google anunció el lanzamiento de un nuevo modelo llamado "gemma-2-2b-jpn-it", el último miembro de su serie de modelos de lenguaje Gemma. Este modelo está específicamente optimizado para el idioma japonés, lo que demuestra el compromiso continuo de Google con los modelos de lenguaje grandes (LLM).

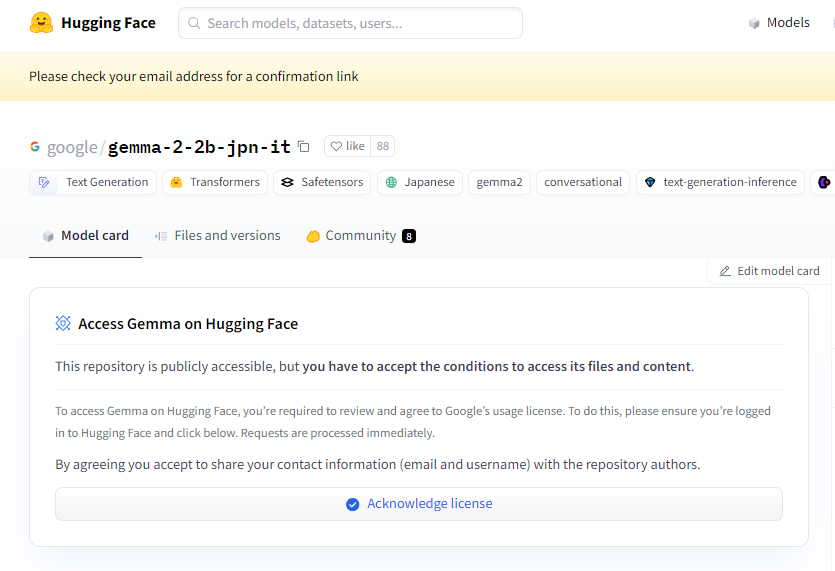

Enlace al proyecto: https://huggingface.co/google/gemma-2-2b-jpn-it

gemma-2-2b-jpn-it es un modelo de lenguaje grande de tipo decodificador texto-a-texto con pesos abiertos, lo que significa que es accesible al público y se puede ajustar finamente para diferentes tareas de generación de texto, como preguntas y respuestas, resúmenes e inferencias.

Este nuevo modelo tiene 2.610 millones de parámetros y utiliza el tipo de tensor BF16. Está diseñado basándose en la arquitectura de la serie de modelos Gemini de Google, y cuenta con documentación y recursos técnicos muy avanzados. Los desarrolladores pueden integrarlo fácilmente en diversas aplicaciones utilizando la inferencia. Cabe destacar que este modelo es compatible con el hardware TPU más reciente de Google, especialmente el TPUv5p. Este hardware proporciona una potente capacidad de cálculo, lo que permite un entrenamiento más rápido y un mejor rendimiento del modelo, superando con creces las infraestructuras tradicionales basadas en CPU.

En cuanto al software, gemma-2-2b-jpn-it se entrenó utilizando los frameworks JAX y ML Pathways. JAX está especialmente optimizado para aplicaciones de aprendizaje automático de alto rendimiento, mientras que ML Pathways proporciona una plataforma flexible para organizar todo el proceso de entrenamiento. Esta combinación permite a Google lograr un flujo de trabajo de entrenamiento eficiente.

Con el lanzamiento de gemma-2-2b-jpn-it, su potencial de aplicación en múltiples campos ha llamado ampliamente la atención. Este modelo puede destacar en la creación de contenido y la comunicación, como generar poemas, guiones, código, textos de marketing, e incluso respuestas de chatbots. Su capacidad de generación de texto también es adecuada para tareas de resumen, pudiendo condensar grandes cantidades de texto en resúmenes concisos, ideal para investigación, educación y exploración del conocimiento.

Sin embargo, gemma-2-2b-jpn-it también tiene algunas limitaciones que los usuarios deben tener en cuenta. El rendimiento del modelo depende de la diversidad y la calidad de sus datos de entrenamiento; si los datos presentan sesgos o lagunas, puede afectar las respuestas del modelo. Además, dado que los modelos de lenguaje grandes no tienen una base de conocimientos incorporada, al procesar consultas complejas, pueden generar afirmaciones fácticas inexactas o desactualizadas.

Durante el desarrollo, Google también dio mucha importancia a las consideraciones éticas, realizando una evaluación rigurosa de gemma-2-2b-jpn-it para abordar problemas relacionados con la seguridad del contenido, los daños a la representación y la memorización de los datos de entrenamiento. Google también implementó técnicas de filtrado para excluir contenido dañino y estableció un marco de transparencia y rendición de cuentas, animando a los desarrolladores a monitorear continuamente y adoptar tecnologías de protección de la privacidad para garantizar el cumplimiento de las regulaciones de privacidad de datos.

Puntos clave:

🌟 El modelo gemma-2-2b-jpn-it, lanzado por Google, está optimizado para el idioma japonés, cuenta con 2.610 millones de parámetros y una arquitectura tecnológica avanzada.

💡 Este modelo tiene un amplio potencial de aplicación en la creación de contenido y el procesamiento del lenguaje natural, admitiendo diversas tareas de generación de texto.

🔒 Google priorizó las consideraciones éticas durante el desarrollo del modelo, implementando filtros de seguridad de contenido y medidas de protección de la privacidad para reducir los riesgos.