En el mundo de la IA, los datos son como una mina de oro, cuanto más ricos, más brillantes. Recientemente, LLM360 lanzó un conjunto de datos llamativo, TxT360, diseñado específicamente para el entrenamiento de modelos de lenguaje grandes. Este coloso no solo incluye datos de texto de alta calidad de todos los sectores, sino que también ha pasado por un proceso de limpieza a escala global, culminando en 5,7 billones de tokens de alta calidad. ¡Una verdadera "caja de herramientas de datos"!

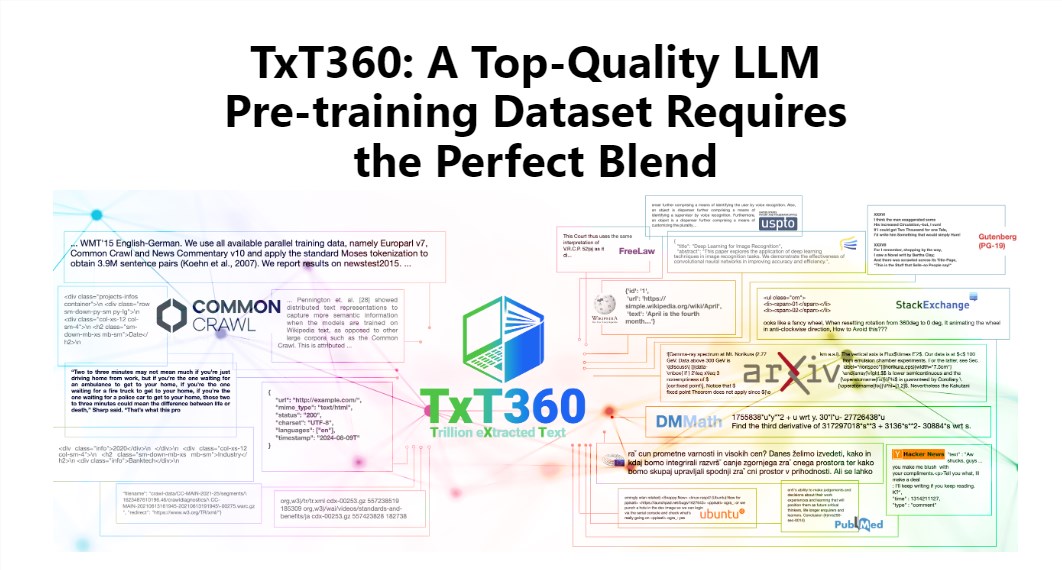

El encanto de TxT360 radica en su enorme escala y alta calidad, superando a conjuntos de datos existentes como FineWeb y RedPajama. Este conjunto de datos extrae la esencia de Internet de 99 instantáneas de Common Crawl, y también selecciona cuidadosamente 14 fuentes de datos de alta calidad, como documentos legales y enciclopedias, haciendo que su contenido sea no solo rico y diverso, sino también confiable.

Lo que es aún más interesante es que TxT360 ofrece a los usuarios una "receta para ajustar el peso de los datos", lo que permite ajustar flexiblemente el peso de diferentes fuentes de datos según sus necesidades. Es como cocinar, donde se pueden combinar libremente diferentes ingredientes según el gusto, asegurando que cada bocado sea delicioso.

Por supuesto, la tecnología de eliminación de duplicados es otro punto destacado de TxT360. Mediante operaciones complejas de eliminación de duplicados, este conjunto de datos resuelve eficazmente la redundancia de datos y la repetición de información durante el proceso de entrenamiento, asegurando que cada token sea único. Además, el equipo del proyecto, mediante expresiones regulares, eliminó inteligentemente la información de identificación personal de los documentos, como correos electrónicos y direcciones IP, garantizando así la privacidad y seguridad de los datos.

El diseño de TxT360 no solo se centra en la escala, sino que también considera la calidad. Combinando las ventajas de los datos web y las fuentes de datos seleccionadas, permite a los investigadores controlar con precisión el uso y la distribución de los datos, como si tuvieran un control remoto mágico para ajustar las proporciones de los datos.

En cuanto al rendimiento del entrenamiento, TxT360 tampoco se queda atrás. Mediante una simple estrategia de sobremuestreo, aumenta considerablemente la cantidad de datos, creando finalmente un conjunto de datos de más de 15 billones de tokens. En una serie de indicadores clave de evaluación, TxT360 supera a FineWeb, especialmente en áreas como MMLU y NQ, mostrando una capacidad de aprendizaje excepcional. Al combinar datos de código (como Stack V2), la curva de aprendizaje es más estable y el rendimiento del modelo mejora notablemente.

Más información: https://huggingface.co/spaces/LLM360/TxT360