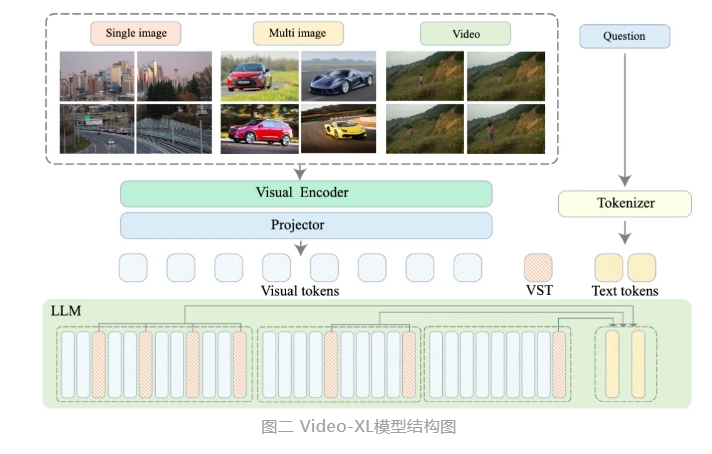

El Instituto de Investigación de Inteligencia Artificial de Beijing, en colaboración con universidades como la Universidad Jiao Tong de Shanghai, la Universidad del Pueblo Chino, la Universidad de Beijing y la Universidad de Ciencia y Tecnología de la Información de Beijing, ha lanzado un nuevo modelo de lenguaje grande para la comprensión de videos extra largos llamado Video-XL. Este modelo es una demostración importante de las capacidades centrales de los modelos multimodales y un paso clave hacia la Inteligencia Artificial General (AGI). En comparación con los modelos multimodales existentes, Video-XL muestra un rendimiento y una eficiencia superiores en el procesamiento de videos de más de 10 minutos.

Video-XL aprovecha las capacidades nativas de los modelos de lenguaje grandes (LLM) para comprimir secuencias visuales largas, manteniendo la capacidad de comprensión de videos cortos y mostrando una excelente capacidad de generalización en la comprensión de videos largos. El modelo ocupa el primer lugar en múltiples tareas de varios benchmarks de comprensión de videos largos. Video-XL logra un buen equilibrio entre eficiencia y rendimiento, necesitando solo una tarjeta gráfica con 80 GB de VRAM para procesar una entrada de 2048 fotogramas, muestrear videos de duración horaria y lograr una precisión cercana al 95% en tareas de "búsqueda en un pajar" de video.

Video-XL promete un amplio valor de aplicación en escenarios como resúmenes de películas, detección de anomalías en videos y detección de inserciones de anuncios, convirtiéndose en una herramienta poderosa para la comprensión de videos largos. El lanzamiento de este modelo marca un paso importante en la eficiencia y precisión de la tecnología de comprensión de videos largos, proporcionando un sólido soporte técnico para el procesamiento y análisis automatizado de contenido de video largo en el futuro.

Actualmente, el código del modelo Video-XL se ha abierto para promover la cooperación y el intercambio tecnológico en la comunidad global de investigación sobre comprensión de video multimodal.

Título del artículo: Video-XL: Modelo de lenguaje de visión extra largo para la comprensión de videos a escala horaria

Enlace del artículo: https://arxiv.org/abs/2409.14485

Enlace del modelo: https://huggingface.co/sy1998/Video_XL

Enlace del proyecto: https://github.com/VectorSpaceLab/Video-XL