En el campo de la inteligencia artificial, un mayor tamaño parece implicar una mayor capacidad. Para perseguir modelos de lenguaje más potentes, las grandes empresas tecnológicas están aumentando frenéticamente los parámetros del modelo y los datos de entrenamiento, pero se dan cuenta de que el coste también aumenta considerablemente. ¿No existe un método económico y eficiente para entrenar modelos de lenguaje?

Investigadores de la Universidad de Harvard y la Universidad de Stanford publicaron recientemente un artículo en el que descubrieron que la precisión del entrenamiento del modelo es como una clave oculta que puede desbloquear el "código de coste" del entrenamiento del modelo de lenguaje.

¿Qué es la precisión del modelo? En pocas palabras, se refiere a los parámetros del modelo y al número de bits utilizados en los cálculos. Los modelos de aprendizaje profundo tradicionales suelen entrenarse utilizando números de punto flotante de 32 bits (FP32), pero en los últimos años, con el desarrollo del hardware, se ha hecho posible entrenar utilizando tipos de números de menor precisión, como números de punto flotante de 16 bits (FP16) o enteros de 8 bits (INT8).

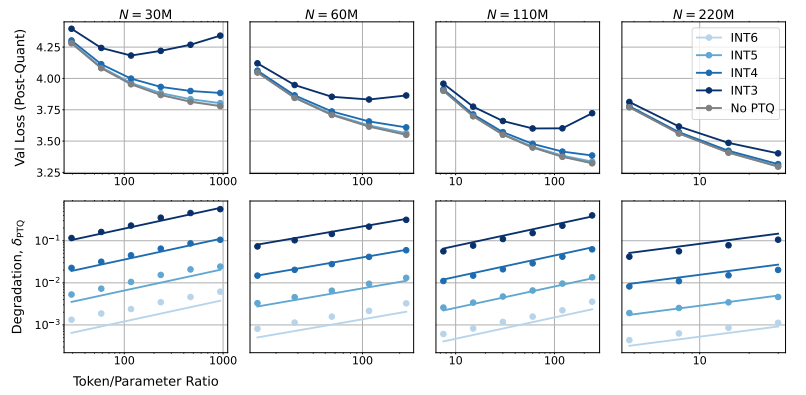

Entonces, ¿qué impacto tiene la reducción de la precisión del modelo en el rendimiento del modelo? Esta es la cuestión que el artículo intenta investigar. Los investigadores, a través de numerosos experimentos, analizaron los cambios en el coste y el rendimiento del entrenamiento y la inferencia del modelo a diferentes precisiones, y propusieron una nueva ley de escalado "consciente de la precisión".

Descubrieron que el entrenamiento con menor precisión puede reducir eficazmente el "número efectivo de parámetros" del modelo, reduciendo así la cantidad de cálculo necesaria para el entrenamiento. Esto significa que, con el mismo presupuesto de cálculo, podemos entrenar modelos de mayor escala, o con la misma escala, podemos ahorrar una gran cantidad de recursos de cálculo utilizando una precisión más baja.

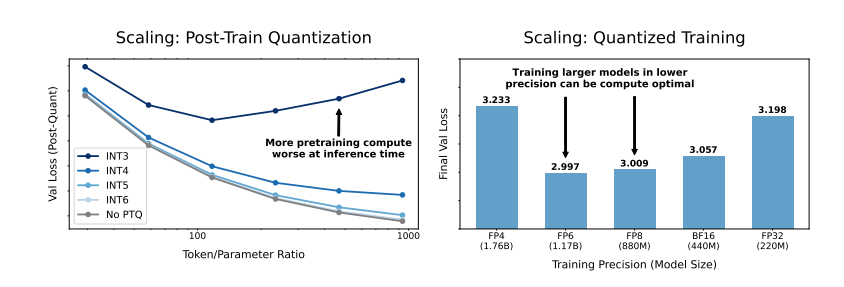

Más sorprendente aún, los investigadores también descubrieron que, en algunos casos, el entrenamiento con menor precisión puede mejorar el rendimiento del modelo. Por ejemplo, para los modelos que necesitan "cuantificación posterior al entrenamiento" (post-training quantization), si se utiliza una precisión más baja durante la fase de entrenamiento, el modelo será más robusto a la reducción de la precisión después de la cuantificación, mostrando así un mejor rendimiento en la fase de inferencia.

Entonces, ¿qué precisión debemos elegir para entrenar el modelo? Los investigadores, analizando su ley de escalado, llegaron a algunas conclusiones interesantes:

El entrenamiento tradicional con precisión de 16 bits puede no ser la mejor opción. Su investigación sugiere que una precisión de 7-8 bits podría ser una opción más económica y eficiente.

Perseguir el entrenamiento con una precisión extremadamente baja (por ejemplo, 4 bits) tampoco es una buena idea. Debido a que, a precisiones extremadamente bajas, el número efectivo de parámetros del modelo disminuye drásticamente, para mantener el rendimiento, necesitamos aumentar considerablemente el tamaño del modelo, lo que a su vez conduce a un mayor coste computacional.

La mejor precisión de entrenamiento puede variar para modelos de diferentes tamaños. Para los modelos que requieren un gran "sobreentrenamiento" (overtraining), como las series Llama-3 y Gemma-2, el entrenamiento con mayor precisión puede ser más económico y eficiente.

Esta investigación proporciona una nueva perspectiva para comprender y optimizar el entrenamiento de modelos de lenguaje. Nos dice que la elección de la precisión no es inmutable, sino que debe sopesarse en función del tamaño específico del modelo, la cantidad de datos de entrenamiento y el escenario de aplicación.

Por supuesto, esta investigación también tiene algunas limitaciones. Por ejemplo, el tamaño del modelo que utilizan es relativamente pequeño, y los resultados experimentales pueden no ser directamente extrapolables a modelos de mayor escala. Además, sólo se centraron en la función de pérdida del modelo y no evaluaron el rendimiento del modelo en tareas posteriores.

A pesar de ello, esta investigación sigue siendo de gran importancia. Revela la compleja relación entre la precisión del modelo, el rendimiento del modelo y el coste del entrenamiento, y proporciona valiosos conocimientos para el diseño y entrenamiento de modelos de lenguaje más potentes y económicos en el futuro.

Artículo: https://arxiv.org/pdf/2411.04330