¿Has oído hablar de ChatGPT, Ernie Bot y otras IA sofisticadas? La tecnología central que las impulsa son los "modelos de lenguaje grande" (LLM, por sus siglas en inglés). ¿Parece complicado y difícil de entender? ¡No te preocupes! Incluso con conocimientos matemáticos de primaria, después de leer este artículo, podrás comprender fácilmente el funcionamiento de los LLM.

Redes neuronales: la magia de los números

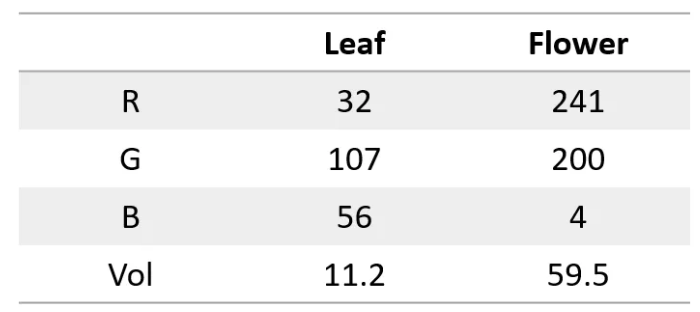

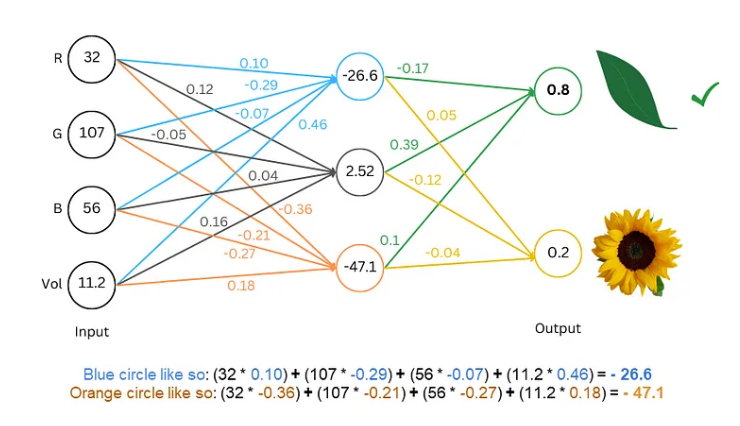

Primero, debemos saber que una red neuronal es como una supercalculadora que solo procesa números. Tanto la entrada como la salida deben ser números. Entonces, ¿cómo hacemos que comprenda el texto?

El secreto está en convertir el texto en números. Por ejemplo, podemos representar cada letra con un número, como a=1, b=2, y así sucesivamente. De esta manera, la red neuronal puede "leer" el texto.

Entrenar el modelo: hacer que la red "aprenda" el lenguaje

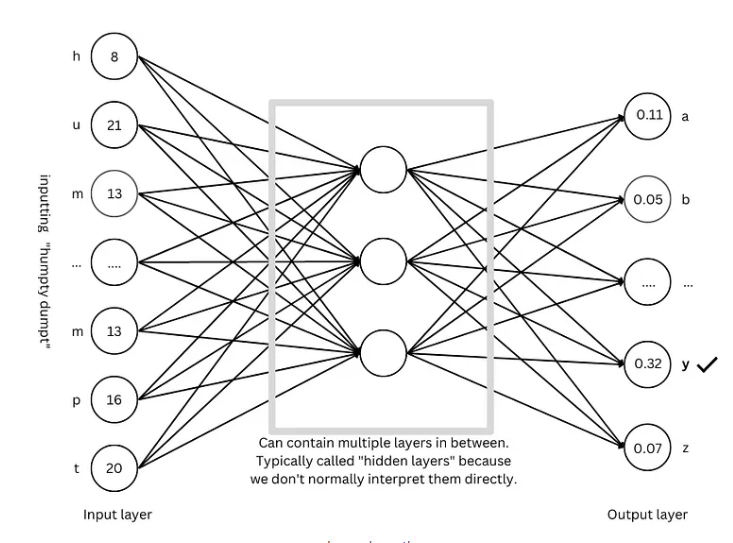

Una vez que tenemos el texto digitalizado, el siguiente paso es entrenar el modelo, haciendo que la red neuronal "aprenda" las reglas del lenguaje.

El proceso de entrenamiento es como un juego de adivinanzas. Le mostramos a la red algunos textos, como "Humpty Dumpty", y la hacemos adivinar la siguiente letra. Si acierta, la recompensamos; si falla, la penalizamos. A través de adivinanzas y ajustes continuos, la red puede predecir cada vez con más precisión la siguiente letra, y finalmente generar oraciones completas, como "Humpty Dumpty sat on a wall".

Técnicas avanzadas: hacer que el modelo sea más "inteligente"

Para hacer que el modelo sea más "inteligente", los investigadores han inventado muchas técnicas avanzadas, como:

Incorporación de palabras (Word embeddings): Ya no usamos números simples para representar letras, sino un conjunto de números (vectores) para representar cada palabra, lo que permite describir el significado de las palabras de manera más completa.

Segmentadores de subpalabras: Dividen las palabras en unidades más pequeñas (subpalabras), como dividir "cats" en "cat" y "s", lo que reduce el vocabulario y aumenta la eficiencia.

Mecanismo de autoatención: Al predecir la siguiente palabra, el modelo ajusta el peso de la predicción según todas las palabras del contexto, al igual que nosotros entendemos el significado de las palabras según el contexto al leer.

Conexiones residuales: Para evitar que el entrenamiento sea difícil debido al exceso de capas de red, los investigadores han inventado conexiones residuales, facilitando el aprendizaje de la red.

Mecanismo de atención multi-cabeza: Al ejecutar varios mecanismos de atención en paralelo, el modelo puede comprender el contexto desde diferentes perspectivas, mejorando la precisión de la predicción.

Codificación posicional: Para que el modelo comprenda el orden de las palabras, los investigadores añaden información posicional a la incorporación de palabras, al igual que prestamos atención al orden de las palabras al leer.

Arquitectura GPT: el "plano" de los modelos de lenguaje grande

La arquitectura GPT es una de las arquitecturas de modelos de lenguaje grande más populares en la actualidad. Es como un "plano" que guía el diseño y el entrenamiento del modelo. La arquitectura GPT combina ingeniosamente las diversas técnicas avanzadas mencionadas anteriormente, permitiendo que el modelo aprenda y genere lenguaje de manera eficiente.

Arquitectura Transformer: la "revolución" de los modelos de lenguaje

La arquitectura Transformer es un gran avance en el campo de los modelos de lenguaje en los últimos años. No solo ha mejorado la precisión de la predicción, sino que también ha reducido la dificultad del entrenamiento, sentando las bases para el desarrollo de modelos de lenguaje grande. La arquitectura GPT también se deriva de la arquitectura Transformer.

Referencias: https://towardsdatascience.com/understanding-llms-from-scratch-using-middle-school-math-e602d27ec876