En la era del rápido desarrollo de la inteligencia artificial, el nivel de inteligencia de los modelos grandes está mejorando constantemente, pero los desafíos de eficiencia del sistema de inferencia que surgen son cada vez más evidentes. Cómo hacer frente a la alta carga de inferencia, reducir los costos de inferencia y acortar el tiempo de respuesta se ha convertido en un problema importante que enfrenta la industria.

Kimi, en colaboración con el laboratorio MADSys de la Universidad Tsinghua, lanzó el diseño del sistema de inferencia Mooncake basado en KVCache, un proyecto que se lanzó oficialmente en junio de 2024.

El sistema de inferencia Mooncake, a través de una innovadora arquitectura de separación PD y el concepto centrado en el intercambio de almacenamiento por cálculo, mejora significativamente la capacidad de procesamiento de la inferencia, atrayendo una amplia atención de la industria. Para promover aún más la aplicación y la popularización de este marco tecnológico, Kimi y el laboratorio MADSys de la Universidad Tsinghua, junto con varias empresas como 9#AISoft, Alibaba Cloud y Huawei Storage, lanzaron el proyecto de código abierto Mooncake. El 28 de noviembre, el marco tecnológico de Mooncake se lanzó oficialmente en la plataforma GitHub.

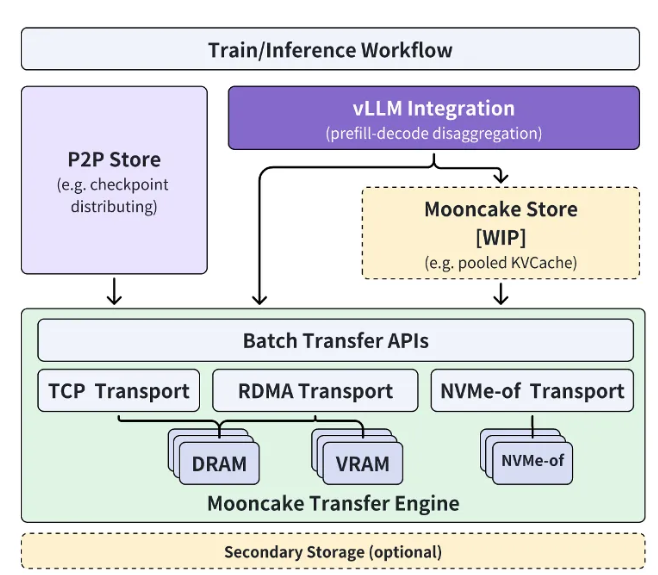

El proyecto de código abierto Mooncake se centra en un grupo de caché KVCache a gran escala, con el objetivo de liberar gradualmente, de forma escalonada, el caché multinivel de alto rendimiento KVCache Mooncake Store. Simultáneamente, este proyecto será compatible con múltiples motores de inferencia y recursos de almacenamiento y transmisión subyacentes.

Actualmente, parte del motor de transferencia Transfer Engine ya está disponible en código abierto a nivel mundial en GitHub. El objetivo final del proyecto Mooncake es construir una nueva interfaz estándar de almacenamiento semántico de memoria de alto rendimiento para la era de los grandes modelos, y proporcionar los esquemas de implementación de referencia correspondientes.

Xu Xinran, vicepresidente de ingeniería de Kimi, afirmó: "A través de la estrecha colaboración con el laboratorio MADSys de la Universidad Tsinghua, hemos creado conjuntamente la arquitectura de inferencia de modelos grandes de tipo separado Mooncake, logrando la optimización extrema de los recursos de inferencia.

Mooncake no solo mejora la experiencia del usuario, sino que también reduce los costos, proporcionando una solución eficaz para el procesamiento de textos largos y las altas demandas de concurrencia". Espera que más empresas e instituciones de investigación se unan al proyecto Mooncake para explorar conjuntamente arquitecturas de sistemas de inferencia de modelos más eficientes, permitiendo que productos basados en tecnología de modelos grandes, como los asistentes de IA, beneficien a un público más amplio.

Enlace al proyecto:https://github.com/kvcache-ai/Mooncake

Puntos clave:

🌟 Kimi y la Universidad Tsinghua lanzan conjuntamente el sistema de inferencia Mooncake para mejorar la eficiencia de la inferencia de IA.

🔧 El proyecto Mooncake ya está disponible en código abierto en GitHub, con el objetivo de construir una interfaz estándar de almacenamiento semántico de memoria de alto rendimiento.

🤝 Se espera la participación de más empresas e instituciones de investigación para impulsar conjuntamente el progreso de la tecnología de IA.