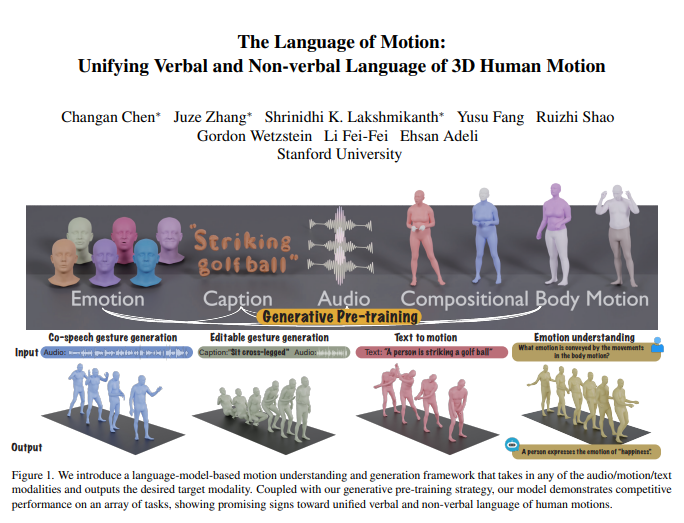

El equipo de Fei-Fei Li ha presentado un nuevo modelo multimodal capaz de comprender y generar acciones humanas, logrando una gestión unificada del lenguaje oral y no verbal mediante la integración de un modelo de lenguaje. Este avance permite a las máquinas no solo comprender instrucciones humanas, sino también interpretar las emociones subyacentes en las acciones, facilitando así una interacción humano-máquina más natural.

El núcleo del modelo reside en su marco de modelo de lenguaje multimodal, capaz de recibir entradas de diversas formas como audio, acciones y texto, y generar datos modales según sea necesario. Gracias a una estrategia de preentrenamiento generativa, el modelo muestra un rendimiento excepcional en múltiples tareas. Por ejemplo, en la generación coordinada de gestos y voz, supera los niveles tecnológicos existentes y reduce significativamente la cantidad de datos necesarios para el entrenamiento. Además, desbloquea nuevas aplicaciones, como la generación de gestos editables y la predicción de emociones a partir de acciones.

La comunicación humana es intrínsecamente multimodal, incluyendo señales verbales y no verbales como voz, expresiones faciales y posturas corporales. La capacidad de este modelo para comprender estas conductas multimodales es crucial para crear personajes virtuales que interactúen de forma natural en aplicaciones como videojuegos, cine y realidad virtual. Sin embargo, los modelos de generación de acciones existentes suelen limitarse a una modalidad de entrada específica (voz, texto o datos de acción), sin aprovechar al máximo la diversidad de los datos disponibles.

El modelo utiliza un modelo de lenguaje para unificar el lenguaje oral y no verbal por tres razones principales:

Los modelos de lenguaje conectan naturalmente diferentes modalidades.

El habla tiene una alta carga semántica, y modelar tareas como la reacción a un chiste requiere una sólida capacidad de razonamiento semántico.

Los modelos de lenguaje adquieren una potente capacidad de comprensión semántica a través de un extenso preentrenamiento.

Para lograr esto, el equipo de investigación dividió primero el cuerpo en diferentes partes (cara, manos, torso, piernas) y etiquetó los movimientos de cada parte por separado. Combinando los tokenizadores de texto y voz, cualquier entrada modal puede representarse como una secuencia de tokens para el modelo de lenguaje. El modelo emplea un proceso de entrenamiento de dos fases: primero, un preentrenamiento para lograr la alineación de varias modalidades con movimientos corporales combinados, así como la alineación de audio y texto. Posteriormente, las tareas posteriores se convierten en instrucciones, y el modelo se entrena en estas instrucciones para que pueda seguir diversas instrucciones de tareas.

El modelo destaca en el conjunto de datos de referencia BEATv2 para la generación coordinada de gestos y voz, superando con creces a los modelos existentes. La eficacia de la estrategia de preentrenamiento también se ha verificado, mostrando una potente capacidad de generalización, especialmente en situaciones con escasez de datos. Mediante el entrenamiento posterior en tareas de voz-acción y texto-acción, el modelo puede seguir indicaciones de audio y texto, e incluso realizar nuevas funciones como la predicción de emociones a partir de datos de acción.

En cuanto a los detalles técnicos, el modelo utiliza tokenizadores específicos de modalidad para procesar diversas modalidades de entrada. Concretamente, el modelo entrena un VQ-VAE de movimiento corporal combinado que convierte los movimientos faciales, de manos, torso y piernas en tokens discretos. Este vocabulario específico de modalidad (audio y texto) se combina en un vocabulario multimodal unificado. Durante el entrenamiento, se utilizan como entrada tokens mixtos de diferentes modalidades, y un modelo de lenguaje codificador-decodificador genera la salida.

El modelo también utiliza el vocabulario multimodal para convertir datos de diferentes modalidades en un formato unificado para su procesamiento. En la fase de preentrenamiento, el modelo aprende las correspondencias entre diferentes modalidades realizando tareas de conversión entre modalidades. Por ejemplo, el modelo puede aprender a convertir movimientos del torso en movimientos de las piernas, o audio en texto. Además, el modelo aprende la evolución temporal de los movimientos mediante el enmascaramiento aleatorio de algunos fotogramas de movimiento.

En la fase de entrenamiento posterior, el modelo se ajusta con datos emparejados para realizar tareas posteriores como la generación coordinada de gestos y voz o la generación de texto a acción. Para que el modelo pueda seguir instrucciones humanas naturales, los investigadores han creado una plantilla de seguimiento de instrucciones multitarea que convierte tareas como audio a acción, texto a acción y emoción a acción en instrucciones. El modelo también tiene la capacidad de editar gestos, pudiendo generar movimientos corporales completos y coordinados a partir de indicaciones de texto y audio.

Finalmente, el modelo desbloquea la nueva capacidad de predecir emociones a partir de acciones. Esto tiene una importancia significativa en áreas como la salud mental o la psiquiatría. En comparación con otros modelos, este modelo puede predecir con mayor precisión las emociones expresadas en las acciones, mostrando una potente capacidad de comprensión del lenguaje corporal.

Esta investigación demuestra que la unificación del lenguaje oral y no verbal de las acciones humanas es crucial para las aplicaciones prácticas, y que los modelos de lenguaje proporcionan un marco potente para ello.

Enlace del artículo: https://arxiv.org/pdf/2412.10523v1