El 26 de diciembre de 2024, la empresa china de inteligencia artificial DeepSeek lanzó su último modelo ultralarge, DeepSeek-V3. Este modelo se destaca por su código abierto y sus innovaciones que desafían a los proveedores líderes de IA.

DeepSeek-V3 cuenta con 671 mil millones de parámetros y utiliza una arquitectura de mezcla de expertos (mixture-of-experts architecture) para activar parámetros específicos, procesando tareas de manera precisa y eficiente. Según las pruebas de referencia proporcionadas por DeepSeek, este nuevo modelo ha superado a modelos de código abierto líderes, incluyendo Llama 3.1-405B de Meta, y se acerca al rendimiento de modelos cerrados de Anthropic y OpenAI.

El lanzamiento de DeepSeek-V3 marca una reducción de la brecha entre la IA de código abierto y la de código cerrado. DeepSeek, inicialmente una rama del fondo de cobertura cuantitativo chino High-Flyer Capital Management, espera que estos avances allanen el camino para la inteligencia artificial general (AGI), donde los modelos puedan comprender o aprender cualquier tarea intelectual que un humano pueda realizar.

Las principales características de DeepSeek-V3 incluyen:

Al igual que su predecesor, DeepSeek-V2, el nuevo modelo se basa en la arquitectura fundamental de atención potencial multi-cabeza (MLA) y DeepSeekMoE, garantizando un entrenamiento e inferencia eficientes.

La empresa también introdujo dos innovaciones: una estrategia de equilibrio de carga sin pérdida y la predicción multi-token (MTP). Esta última permite al modelo predecir simultáneamente múltiples tokens futuros, mejorando la eficiencia del entrenamiento y triplicando la velocidad del modelo, generando 60 tokens por segundo.

En la fase de preentrenamiento, DeepSeek-V3 entrenó con 14,8 billones de tokens de alta calidad y diversidad, y realizó una expansión de la longitud del contexto en dos fases. Finalmente, se llevó a cabo un ajuste fino supervisado (SFT) y aprendizaje por refuerzo (RL) posteriores al entrenamiento para alinear el modelo con las preferencias humanas y liberar aún más su potencial.

Durante el entrenamiento, DeepSeek empleó varias optimizaciones de hardware y algoritmos, incluyendo un marco de entrenamiento de precisión mixta FP8 y el algoritmo DualPipe para el paralelismo de canalización, reduciendo los costos de entrenamiento. Se afirma que todo el proceso de entrenamiento de DeepSeek-V3 se completó en 2788K horas de GPU H800 o aproximadamente 5,57 millones de dólares, muy por debajo de los cientos de millones de dólares que suelen utilizarse para el preentrenamiento de grandes modelos de lenguaje.

DeepSeek-V3 se ha convertido en uno de los modelos de código abierto más potentes del mercado. Varias pruebas de referencia realizadas por la empresa muestran que supera a GPT-4o de código cerrado en la mayoría de las pruebas, excepto en SimpleQA y FRAMES, enfocadas en inglés, donde el modelo de OpenAI obtuvo puntuaciones de 38,2 y 80,5 respectivamente (DeepSeek-V3 obtuvo 24,9 y 73,3). DeepSeek-V3 destaca especialmente en las pruebas de referencia de chino y matemáticas, obteniendo una puntuación de 90,2 en la prueba Math-500, seguida de Qwen con 80 puntos.

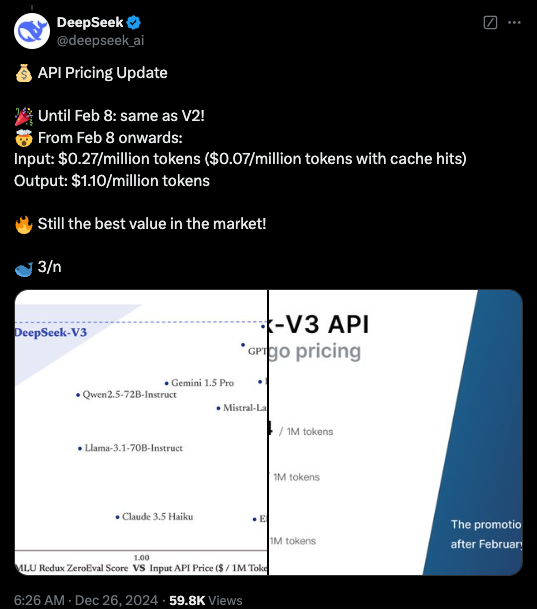

Actualmente, el código de DeepSeek-V3 está disponible en GitHub bajo la licencia MIT, y el modelo se ofrece bajo la licencia de modelos de la empresa. Las empresas también pueden probar el nuevo modelo a través de DeepSeek Chat (una plataforma similar a ChatGPT) y acceder a la API para uso comercial. DeepSeek ofrecerá la API al mismo precio que DeepSeek-V2 hasta el 8 de febrero. Después de esa fecha, se cobrará 0,27 dólares por millón de tokens de entrada (0,07 dólares por millón de tokens con caché) y 1,10 dólares por millón de tokens de salida.

Puntos clave:

🌟 Lanzamiento de DeepSeek-V3, con rendimiento superior a Llama y Qwen.

🔧 Emplea 671 mil millones de parámetros y una arquitectura de mezcla de expertos para mayor eficiencia.

🚀 Innovaciones que incluyen una estrategia de equilibrio de carga sin pérdida y predicción multi-token, mejorando la velocidad.

💼 Costo de entrenamiento significativamente reducido, impulsando el desarrollo de la IA de código abierto.