Para celebrar el final de año, la empresa de tecnología china Zhipu AI ha lanzado GLM-Zero-Preview, la primera versión de su modelo de razonamiento GLM-Zero, entrenado con tecnología de aprendizaje por refuerzo extendido. Este modelo se centra en mejorar la capacidad de razonamiento de la inteligencia artificial, especialmente en lógica matemática, programación y resolución de problemas complejos que requieren un razonamiento profundo. En comparación con los modelos base, GLM-Zero-Preview mantiene sus capacidades en tareas generales, pero muestra una mejora significativa en tareas especializadas. Su rendimiento en las evaluaciones AIME2024, MATH500 y LiveCodeBench es comparable al de OpenAI o1-preview.

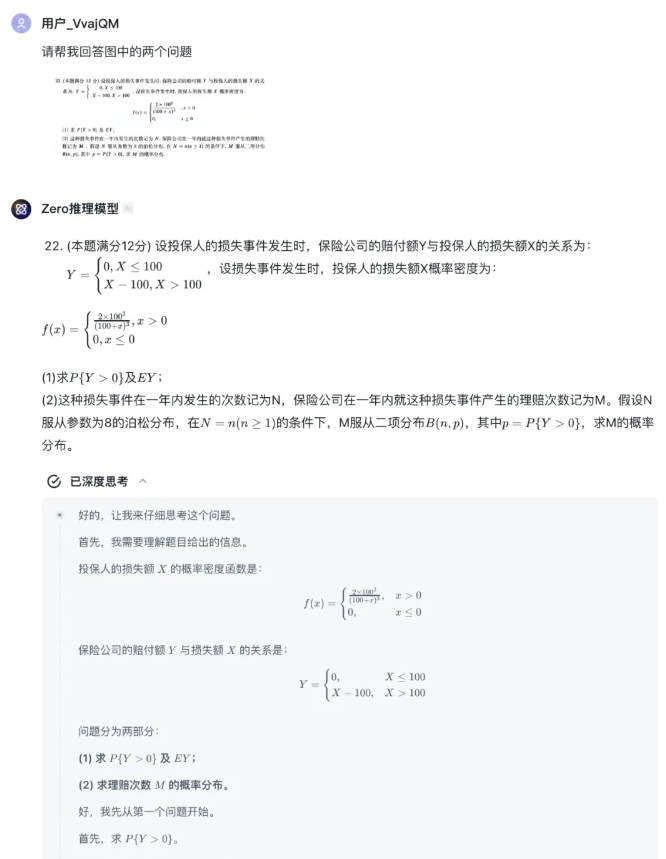

Los usuarios pueden experimentar GLM-Zero-Preview gratuitamente en el agente "Modelo de Razonamiento Zero" de la plataforma Zhipu Qingyan, que admite la carga de texto e imágenes, y el modelo proporcionará el proceso de razonamiento completo. Los desarrolladores también pueden acceder a este modelo a través de la API de la plataforma abierta Zhipu.

Aunque GLM-Zero-Preview aún tiene cierta distancia con el modelo o3 de OpenAI, Zhipu AI planea optimizar y actualizar continuamente la tecnología de aprendizaje por refuerzo, y pronto lanzará la versión oficial de GLM-Zero, expandiendo la capacidad de pensamiento profundo desde la lógica matemática a más áreas de tecnología general.

En cuanto al rendimiento del modelo, GLM-Zero-Preview demuestra la importancia del aprendizaje por refuerzo para mejorar la capacidad de razonamiento profundo. Con el aumento de la cantidad de entrenamiento, el rendimiento del modelo en áreas como el razonamiento profundo mejora constantemente. También se ha verificado la ley de escalamiento en la fase de razonamiento, es decir, a medida que aumenta el número de tokens que el modelo puede procesar y la cantidad de cómputo, la calidad de los resultados del modelo también mejora constantemente. GLM-Zero-Preview puede tomar decisiones autónomas durante el proceso de razonamiento, descomponer problemas e intentar resolverlos de varias maneras, similar al proceso de pensamiento y toma de decisiones humanas.

En casos de prueba reales, GLM-Zero-Preview ha demostrado la capacidad de identificar fallas lógicas y simular múltiples hipótesis en el razonamiento lógico. En matemáticas, el modelo posee una potente capacidad de inducción y deducción, pudiendo manejar rápidamente cálculos matemáticos complejos y alcanzando el nivel de un excelente estudiante de posgrado en la prueba de matemáticas del examen de ingreso a posgrado de 2025. En programación, GLM-Zero-Preview puede usar varios lenguajes de programación con fluidez y ayudar a los desarrolladores a escribir código rápidamente.

Plataforma Zhipu Qingyan:

https://chatglm.cn/main/gdetail/676411c38945bbc58a905d31?lang=zh

Plataforma Abierta Zhipu:

https://bigmodel.cn/dev/api/normal-model/glm-zero-preview