Con el rápido desarrollo de la tecnología de video, este se ha convertido en una herramienta fundamental para la recuperación de información y la comprensión de conceptos complejos. Los videos combinan datos visuales, temporales y contextuales, ofreciendo una representación multimodal que supera a las imágenes estáticas y al texto. Hoy en día, con la proliferación de plataformas para compartir videos y la abundancia de videos educativos e informativos, el uso de videos como fuente de conocimiento ofrece oportunidades sin precedentes para resolver consultas que requieren un contexto detallado, comprensión espacial y demostraciones de procesos.

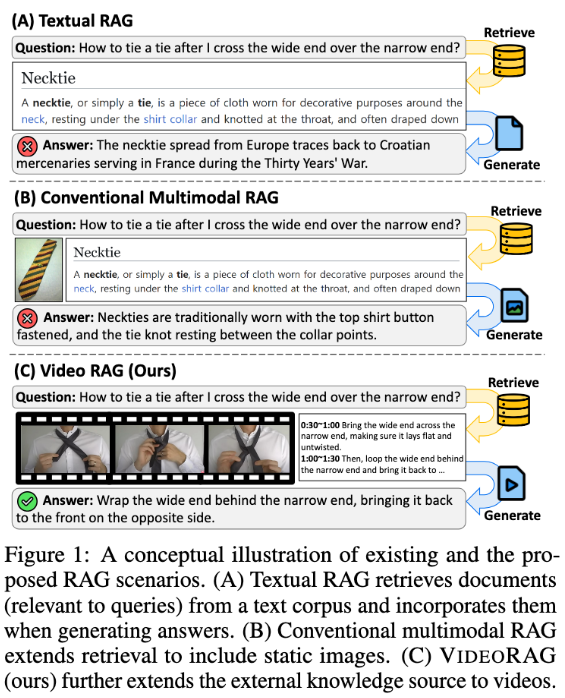

Sin embargo, los sistemas de generación mejorada por recuperación (RAG) existentes a menudo pasan por alto todo el potencial de los datos de video. Estos sistemas suelen depender de la información textual, utilizando ocasionalmente imágenes estáticas para respaldar las respuestas a las consultas, pero no logran captar la dinámica visual y las pistas multimodales que contienen los videos, cruciales para tareas complejas. Los métodos tradicionales o bien predefinen videos relacionados con la consulta sin recuperación, o bien convierten los videos a formato de texto, perdiendo así el importante contexto visual y la dinámica temporal, lo que limita la capacidad de proporcionar respuestas precisas e informativas.

Para abordar estos problemas, un equipo de investigación del Instituto Avanzado de Ciencia y Tecnología de Corea (KAIST) y DeepAuto.ai ha propuesto un marco novedoso: VideoRAG. Este marco puede recuperar dinámicamente videos relacionados con la consulta e integrar información visual y textual en el proceso de generación. VideoRAG utiliza modelos de lenguaje de video de gran tamaño (LVLMs) para lograr una integración perfecta de datos multimodales, asegurando que los videos recuperados sean coherentes con el contexto de la consulta del usuario y manteniendo la riqueza temporal del contenido del video.

El flujo de trabajo de VideoRAG se divide en dos etapas principales: recuperación y generación. En la etapa de recuperación, el marco identifica videos similares a la consulta en función de sus características visuales y textuales.

En la etapa de generación, se utiliza el reconocimiento automático del habla para generar datos de texto auxiliares para los videos sin subtítulos, asegurando que todos los videos recuperados contribuyan eficazmente a la generación de respuestas. Los videos recuperados se introducen en el módulo de generación, integrando datos multimodales como fotogramas de video, subtítulos y texto de consulta, procesados mediante LVLMs, para generar respuestas largas, ricas, precisas y contextualizadas.

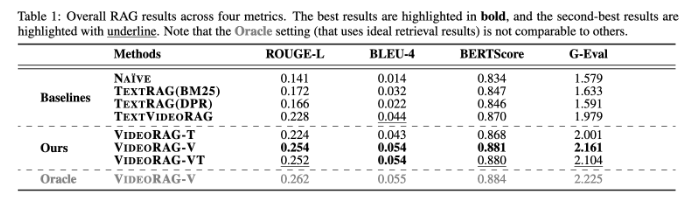

VideoRAG se ha probado exhaustivamente en conjuntos de datos como WikiHowQA y HowTo100M, mostrando una calidad de respuesta significativamente superior a los métodos tradicionales. Este nuevo marco no solo mejora las capacidades de los sistemas de generación mejorada por recuperación, sino que también establece un nuevo estándar para los futuros sistemas de recuperación multimodales.

Artículo: https://arxiv.org/abs/2501.05874

Puntos clave:

📹 **Nuevo marco**: VideoRAG recupera dinámicamente videos relevantes, fusionando información visual y textual para mejorar la generación.

🔍 **Validación experimental**: Probado en múltiples conjuntos de datos, mostrando una calidad de respuesta significativamente superior a los métodos RAG tradicionales.

🌟 **Innovación tecnológica**: Utilizando modelos de lenguaje de video de gran tamaño, VideoRAG abre un nuevo capítulo en la integración de datos multimodales.