Hugging Face ha lanzado un impresionante modelo de IA: SmolVLM. Este modelo de lenguaje visual es tan pequeño que puede funcionar en dispositivos pequeños como teléfonos móviles, superando el rendimiento de modelos anteriores que requerían grandes centros de datos.

El modelo SmolVLM-256M requiere menos de 1 GB de memoria GPU, pero supera en rendimiento a su predecesor, Idefics80B, que es 300 veces más grande. Esto representa un gran avance en la implementación práctica de la IA.

Según Andrés Malarafioti, ingeniero de investigación de aprendizaje automático de Hugging Face, SmolVLM ofrece a las empresas una reducción significativa de los costos computacionales. "Nuestro Idefics80B, lanzado en agosto de 2023, fue el primer modelo de lenguaje visual de código abierto. SmolVLM logra una reducción de tamaño de 300 veces, con una mejora del rendimiento", dijo Malarafioti en una entrevista con Diario Emprendedor.

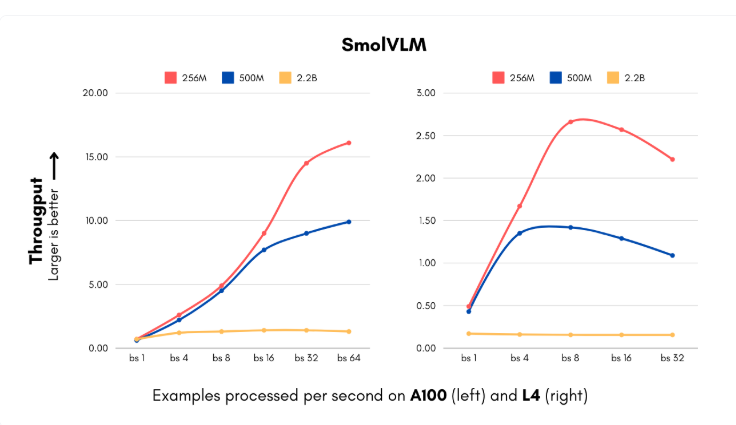

El lanzamiento de SmolVLM llega en un momento crucial en el que las empresas enfrentan altos costos computacionales en la implementación de sistemas de inteligencia artificial. El nuevo modelo, disponible en dos tamaños (256M y 500M de parámetros), puede procesar imágenes y comprender el contenido visual a una velocidad inigualable. La versión más pequeña puede procesar hasta 16 instancias por segundo con solo 15 GB de memoria, ideal para empresas que manejan grandes cantidades de datos visuales. Para una empresa mediana que procesa 1 millón de imágenes al mes, esto significa un ahorro considerable en costos computacionales anuales.

Además, IBM se ha asociado con Hugging Face para integrar el modelo de 256M en su software de procesamiento de documentos, Docling. A pesar de los abundantes recursos computacionales de IBM, el uso de un modelo más pequeño permite procesar millones de documentos de manera eficiente y a un costo menor.

El equipo de Hugging Face logró reducir el tamaño del modelo sin perder rendimiento gracias a innovaciones en el procesamiento visual y los componentes del lenguaje. Reemplazaron el codificador visual original de 400M de parámetros por una versión de 93M y aplicaron una técnica de compresión de tokens más agresiva. Estas innovaciones permiten a las pequeñas empresas y startups lanzar productos de visión artificial complejos en poco tiempo, con una reducción significativa de los costos de infraestructura.

El conjunto de datos de entrenamiento de SmolVLM incluye 170 millones de ejemplos, casi la mitad de los cuales se utilizaron para el procesamiento de documentos y el etiquetado de imágenes. Estos avances no solo reducen los costos, sino que también abren nuevas posibilidades de aplicación para las empresas, mejorando su capacidad de búsqueda visual a niveles sin precedentes.

Este avance de Hugging Face desafía la creencia tradicional sobre la relación entre el tamaño del modelo y su capacidad. SmolVLM demuestra que las arquitecturas pequeñas y eficientes también pueden ofrecer un rendimiento excelente. El futuro de la IA puede no consistir en buscar modelos más grandes, sino en sistemas más flexibles y eficientes.

Modelo: https://huggingface.co/blog/smolervlm

Puntos clave:

🌟 El modelo SmolVLM de Hugging Face funciona en teléfonos móviles y supera en rendimiento al modelo Idefics80B, 300 veces más grande.

💰 SmolVLM ayuda a las empresas a reducir significativamente los costos computacionales, con una velocidad de procesamiento de 16 instancias por segundo.

🚀 Las innovaciones tecnológicas del modelo permiten a las pequeñas empresas y startups lanzar productos de visión artificial complejos en poco tiempo.