Según el comunicado oficial del equipo del modelo Doubao, en colaboración con la Universidad de Transporte de Beijing y la Universidad de Ciencia y Tecnología de China, el modelo experimental de generación de vídeo "VideoWorld", propuesto por el equipo del modelo Doubao, ha sido recientemente de código abierto.

El mayor atractivo de este modelo radica en que ya no depende de los modelos lingüísticos tradicionales, sino que solo con información visual puede reconocer y comprender el mundo. Esta investigación innovadora se inspira en la idea de la profesora Fei-Fei Li, mencionada en su charla TED, de que "los niños pequeños pueden comprender el mundo real sin depender del lenguaje".

"VideoWorld" logra complejas capacidades de razonamiento, planificación y toma de decisiones mediante el análisis y procesamiento de una gran cantidad de datos de vídeo. Los experimentos del equipo de investigación muestran que el modelo, con solo 300 millones de parámetros, ha obtenido resultados notables. A diferencia de los modelos existentes que dependen de datos lingüísticos o de etiquetas, VideoWorld puede aprender conocimientos de forma independiente, especialmente en tareas complejas como el origami o el anudado de corbatas, ofreciendo una forma de aprendizaje más intuitiva.

Para verificar la eficacia del modelo, el equipo de investigación creó dos entornos experimentales: un juego de Go y una simulación de control de robots. El Go, como juego de alta estrategia, permite evaluar eficazmente la capacidad de aprendizaje de reglas y razonamiento del modelo, mientras que las tareas robóticas evalúan su rendimiento en control y planificación. Durante la fase de entrenamiento, el modelo, mediante la observación de una gran cantidad de datos de demostración en vídeo, establece gradualmente su capacidad de predicción de imágenes futuras.

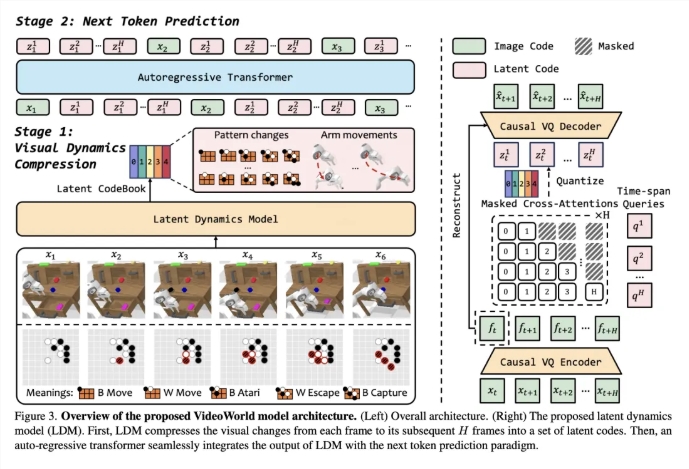

Para mejorar la eficiencia del aprendizaje de vídeo, el equipo introdujo un modelo dinámico latente (LDM), cuyo objetivo es comprimir los cambios visuales entre fotogramas de vídeo para extraer información clave. Este método no solo reduce la información redundante, sino que también mejora la eficiencia de aprendizaje del modelo para conocimientos complejos. Gracias a esta innovación, VideoWorld ha demostrado una excelente capacidad en las tareas de Go y robótica, incluso alcanzando el nivel de un jugador profesional de Go de quinto dan.

Enlace del artículo:https://arxiv.org/abs/2501.09781

Enlace del código:https://github.com/bytedance/VideoWorld

Página principal del proyecto:https://maverickren.github.io/VideoWorld.github.io

Puntos clave:

🌟 El modelo "VideoWorld" puede aprender conocimientos únicamente con información visual, sin depender de modelos lingüísticos.

🤖 El modelo muestra una excelente capacidad de razonamiento y planificación en tareas de Go y simulación robótica.

🔓 El código y el modelo de este proyecto son de código abierto; se invita a todos a participar, experimentar e intercambiar ideas.