En el campo de la inteligencia artificial, el equipo de DeepSeek ha publicado recientemente sus últimos hallazgos, presentando un innovador mecanismo de atención dispersa llamado NSA (Native Sparse Attention). El objetivo principal de esta tecnología es mejorar la velocidad del entrenamiento y la inferencia con contextos largos, especialmente optimizada para hardware moderno, lo que resulta en una mejora significativa en la eficiencia del entrenamiento y la inferencia.

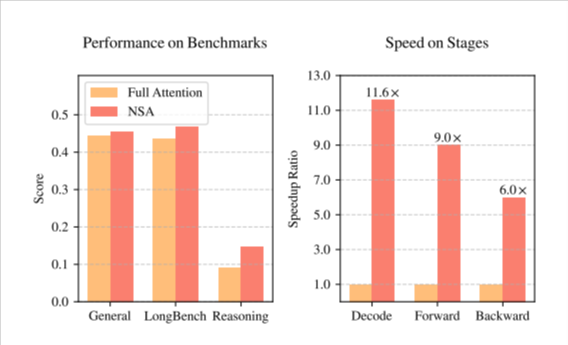

La introducción de la tecnología NSA ha supuesto un cambio notable en el entrenamiento de modelos de inteligencia artificial. En primer lugar, a través de una serie de optimizaciones de diseño dirigidas a las características del hardware de computación moderno, mejora significativamente la velocidad de inferencia y reduce eficazmente el coste del preentrenamiento. Más importante aún, al tiempo que aumenta la velocidad y reduce los costes, NSA mantiene un alto nivel de rendimiento del modelo, garantizando que el rendimiento del modelo en diversas tareas no se vea afectado.

El equipo de DeepSeek, en su investigación, adoptó una estrategia de dispersión jerárquica, dividiendo el mecanismo de atención en tres ramas: compresión, selección y ventana deslizante. Este diseño permite al modelo capturar simultáneamente el contexto global y los detalles locales, mejorando así la capacidad del modelo para procesar textos largos. Además, las optimizaciones de NSA en el acceso a la memoria y la programación de cálculos reducen significativamente la latencia de cálculo y el consumo de recursos del entrenamiento con contextos largos.

En una serie de pruebas de referencia generales, NSA demostró su excelente rendimiento. Especialmente en tareas de contexto largo y razonamiento basado en instrucciones, el rendimiento de NSA es comparable al de los modelos de atención completa, e incluso superior en algunos casos. El lanzamiento de esta tecnología marca un nuevo salto en las técnicas de entrenamiento e inferencia de IA, impulsando el futuro desarrollo de la inteligencia artificial.

Artículo de NSA (https://arxiv.org/pdf/2502.11089v1).

Puntos clave:

🌟 El lanzamiento de la tecnología NSA mejora significativamente la velocidad de entrenamiento e inferencia con contextos largos, y reduce el coste del preentrenamiento.

🛠️ Adopta una estrategia de dispersión jerárquica, dividiendo el mecanismo de atención en compresión, selección y ventana deslizante, mejorando la capacidad del modelo para procesar textos largos.

📈 En varias pruebas de referencia, NSA muestra un rendimiento excelente, superando en algunos casos a los modelos de atención completa tradicionales.