Recientemente, un equipo de investigación de Microsoft, en colaboración con investigadores de varias universidades, ha lanzado un modelo de IA multimodal llamado "Magma". Este modelo está diseñado para procesar e integrar varios tipos de datos, como imágenes, texto y vídeo, para realizar tareas complejas en entornos digitales y físicos. Con los continuos avances tecnológicos, los agentes de IA multimodales se están utilizando ampliamente en robótica, asistentes virtuales y automatización de interfaces de usuario.

Los sistemas de IA anteriores se centraban generalmente en la comprensión visual-lingüística o en la manipulación robótica, siendo difícil combinar estas dos capacidades en un único modelo. Muchos modelos existentes, aunque funcionan bien en áreas específicas, tienen una capacidad de generalización deficiente en diferentes escenarios de aplicación. Por ejemplo, los modelos Pix2Act y WebGUM destacan en la navegación de la interfaz de usuario, mientras que OpenVLA y RT-2 son más adecuados para la manipulación robótica, pero a menudo requieren entrenamiento separado y tienen dificultades para superar los límites entre los entornos digitales y físicos.

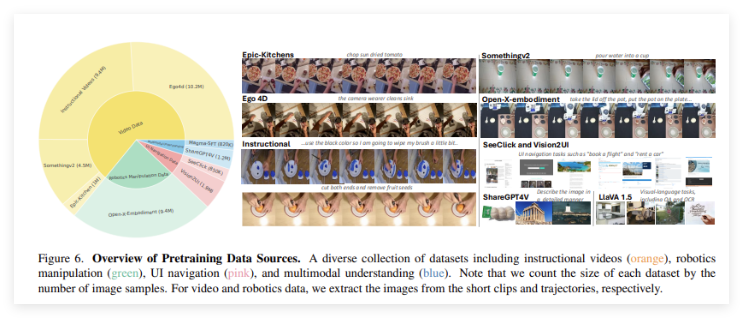

El modelo "Magma" se ha creado para superar estas limitaciones. Mediante la introducción de un potente método de entrenamiento, integra la comprensión multimodal, la localización de acciones y la capacidad de planificación, con el objetivo de permitir que los agentes de IA funcionen sin problemas en diversos entornos. El conjunto de datos de entrenamiento de Magma incluye 39 millones de muestras, que abarcan imágenes, vídeos y trayectorias de movimiento robótico. Además, el modelo utiliza dos técnicas innovadoras: "Conjunto de Marcas" (Set-of-Mark, SoM) y "Rastro de Marcas" (Trace-of-Mark, ToM). La primera permite al modelo etiquetar objetos visuales manipulables en el entorno de la interfaz de usuario, mientras que la segunda le permite rastrear el movimiento de los objetos a lo largo del tiempo, mejorando la capacidad de planificación de acciones futuras.

“Magma” utiliza una arquitectura avanzada de aprendizaje profundo y técnicas de preentrenamiento a gran escala para optimizar su rendimiento en múltiples dominios. El modelo utiliza el backbone visual ConvNeXt-XXL para procesar imágenes y vídeos, y el modelo de lenguaje LLaMA-3-8B para procesar las entradas de texto. Esta arquitectura permite a "Magma" integrar de manera eficiente la visión, el lenguaje y la ejecución de acciones. Después de un entrenamiento exhaustivo, el modelo ha logrado excelentes resultados en múltiples tareas, mostrando una potente capacidad de comprensión multimodal y razonamiento espacial.

Acceso al proyecto: https://microsoft.github.io/Magma/

Puntos clave:

🌟 El modelo Magma ha sido entrenado con más de 39 millones de muestras y posee una potente capacidad de aprendizaje multimodal.

🤖 Este modelo integra con éxito la visión, el lenguaje y la acción, superando las limitaciones de los modelos de IA existentes.

📈 Magma ha obtenido excelentes resultados en varias pruebas de referencia, mostrando una sólida capacidad de generalización y una excelente capacidad de ejecución de decisiones.