El reciente lanzamiento del proyecto VLM-R1 ha traído una nueva luz a este campo. Este proyecto representa la exitosa migración del método R1 del equipo DeepSeek a modelos de lenguaje visual, lo que significa que la comprensión de contenido visual por parte de la IA entrará en una nueva fase.

VLM-R1 se inspira en el método R1 de código abierto lanzado por DeepSeek el año pasado. Este método utiliza la técnica de aprendizaje por refuerzo GRPO (Generative Reward Processing Optimization), logrando un rendimiento excepcional en el procesamiento de texto plano. Ahora, el equipo de VLM-R1 ha aplicado con éxito este método a los modelos de lenguaje visual, abriendo nuevas posibilidades para la investigación de la IA multimodal.

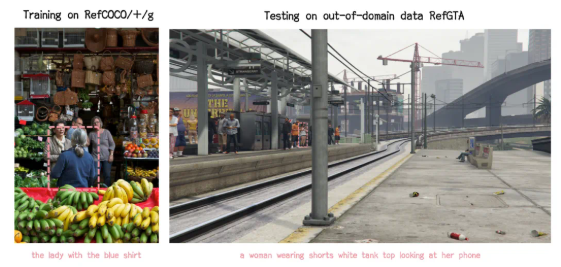

Los resultados de la validación del proyecto muestran un rendimiento asombroso de VLM-R1. En primer lugar, el método R1 demuestra una alta estabilidad en escenarios complejos, lo cual es crucial para las aplicaciones reales. En segundo lugar, el modelo muestra una excelente capacidad de generalización. En experimentos comparativos, los modelos SFT (Supervised Fine-Tuning) tradicionales muestran una disminución del rendimiento en datos de prueba fuera del dominio a medida que aumenta el número de pasos de entrenamiento, mientras que el modelo R1 mejora continuamente durante el entrenamiento. Esto indica que el método R1 permite al modelo comprender realmente el contenido visual, en lugar de simplemente depender de la memorización.

Además, VLM-R1 es muy fácil de usar. El equipo proporciona a los desarrolladores un flujo de trabajo completo de entrenamiento y evaluación, lo que permite una rápida integración. En un caso práctico, se le pidió al modelo que identificara el alimento con mayor contenido de proteínas en una imagen de una comida abundante. El modelo no solo respondió correctamente, sino que también seleccionó con precisión el huevo frito, el alimento con mayor contenido de proteínas en la imagen, demostrando su excelente capacidad de comprensión e inferencia visual.

El éxito de VLM-R1 no solo demuestra la versatilidad del método R1, sino que también ofrece nuevas ideas para el entrenamiento de modelos multimodales, anunciando una nueva tendencia en el entrenamiento de modelos de lenguaje visual. Lo más emocionante es que el proyecto es de código abierto, y los desarrolladores interesados pueden encontrar la información relevante en GitHub.

En resumen, la llegada de VLM-R1 ha inyectado nueva vitalidad a la investigación de modelos de lenguaje visual. Esperamos que más desarrolladores participen en este proyecto para impulsar el progreso continuo de la tecnología de IA multimodal.