La empresa japonesa de inteligencia artificial Sakana AI ha anunciado el lanzamiento de "AI CUDA Engineer", un innovador sistema de agente de IA diseñado para automatizar la producción de núcleos CUDA altamente optimizados, mejorando significativamente la eficiencia operativa de las operaciones de aprendizaje automático. Según las últimas noticias en la plataforma X, el sistema, impulsado por una técnica de optimización de código basada en un modelo de lenguaje grande (LLM) evolutivo, ha aumentado la velocidad de ejecución de las operaciones comunes de PyTorch entre 10 y 100 veces, lo que representa un gran avance en la optimización del rendimiento de la GPU mediante IA.

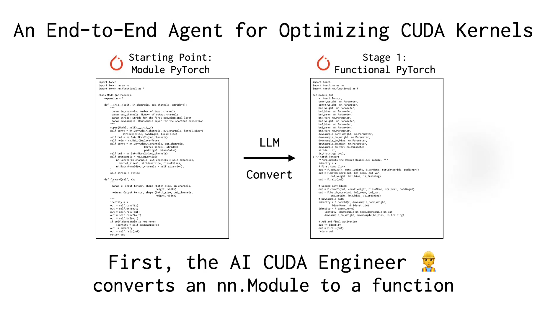

Sakana AI afirma que los núcleos CUDA, como núcleo del cálculo de GPU, suelen requerir un profundo conocimiento especializado y un alto nivel técnico para su escritura y optimización. Los frameworks existentes, como PyTorch, aunque fáciles de usar, a menudo no alcanzan el rendimiento de los núcleos optimizados manualmente. "AI CUDA Engineer" resuelve este problema mediante un flujo de trabajo inteligente: no solo convierte automáticamente el código PyTorch en núcleos CUDA eficientes, sino que también optimiza el rendimiento mediante algoritmos evolutivos, e incluso puede fusionar múltiples núcleos para mejorar aún más la eficiencia de ejecución.

El usuario de X @shao__meng comparó esta tecnología con "instalar una transmisión automática en el desarrollo de IA", permitiendo que el código común "se actualice automáticamente a un rendimiento de nivel de carreras". Otro usuario, @FinanceYF5, también señaló en su publicación que el lanzamiento de este sistema demuestra el potencial de la autooptimización de la IA, y podría revolucionar la eficiencia del uso de recursos informáticos en el futuro.

Sakana AI ya se había destacado en la industria con proyectos como "AI Scientist". El lanzamiento de "AI CUDA Engineer" refuerza aún más su ambición en el campo de la automatización de la IA. La empresa afirma que el sistema ha generado y verificado con éxito más de 17.000 núcleos CUDA, que abarcan diversas operaciones de PyTorch, y que el conjunto de datos público proporcionará un valioso recurso para investigadores y desarrolladores. Los expertos del sector consideran que esta tecnología no solo reduce el umbral de programación de GPU de alto rendimiento, sino que también podría impulsar la eficiencia del entrenamiento y la implementación de modelos de inteligencia artificial a un nuevo nivel.

Referencia de información: https://x.com/FinanceYF5/status/1892856847780237318