El 27 de febrero de 2025, Tencent lanzó oficialmente HunYuan Turbo S, un nuevo modelo de pensamiento rápido, marcando un importante avance en la velocidad de respuesta y la optimización del rendimiento de la tecnología de modelos grandes. A diferencia de los modelos de pensamiento lento tradicionales como DeepSeek R1 y HunYuan T1, HunYuan Turbo S puede lograr una "respuesta instantánea", aumentando considerablemente la velocidad de salida de respuestas, duplicando la velocidad de escritura y reduciendo la latencia del primer carácter en un 44%. Esta innovación permite que el modelo destaque en múltiples áreas como el conocimiento, las matemáticas y la creación, ofreciendo nuevas soluciones para la capacidad de respuesta rápida de los modelos grandes.

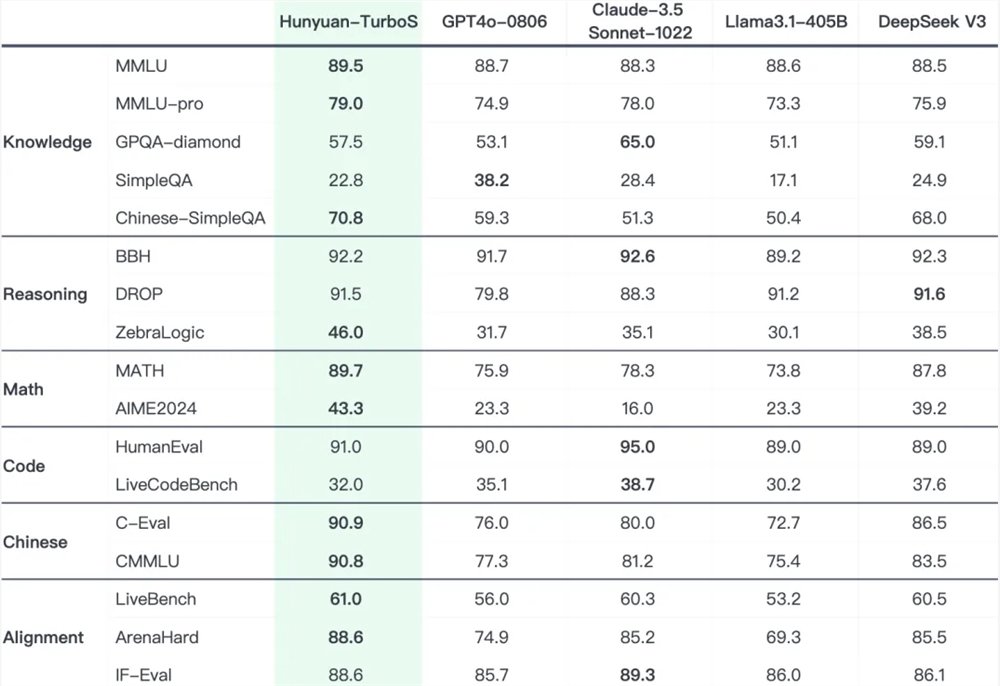

El diseño de HunYuan Turbo S se inspira en el modo de pensamiento rápido que utiliza el 90% - 95% de las decisiones diarias humanas basadas en la intuición, combinándolo con el modo de pensamiento lento de análisis racional para proporcionar a los modelos grandes una capacidad de resolución de problemas más inteligente y eficiente. Mediante la fusión de cadenas de pensamiento largas y cortas, el modelo no solo mantiene una experiencia rápida en problemas de humanidades, sino que también mejora significativamente la capacidad de razonamiento científico, con una mejora sustancial en el rendimiento general. En varias pruebas de referencia públicas ampliamente utilizadas en la industria, HunYuan Turbo S muestra un rendimiento comparable al de modelos líderes como DeepSeek V3, GPT4o y Claude.

En cuanto a la innovación arquitectónica, HunYuan Turbo S adopta un modo de fusión Hybrid-Mamba-Transformer, reduciendo eficazmente la complejidad computacional y la ocupación de la caché KV-Cache de la estructura tradicional del Transformer, lo que reduce significativamente los costos de entrenamiento e inferencia. Esta arquitectura híbrida supera el problema de los altos costos de entrenamiento e inferencia de textos largos en los modelos grandes tradicionales, aprovechando las ventajas de la arquitectura Mamba para el procesamiento de secuencias largas, al tiempo que conserva la capacidad del Transformer para capturar contextos complejos. Este es el primer caso exitoso en la industria que aplica sin pérdidas la arquitectura Mamba a modelos MoE de gran escala.

Como base central de la serie HunYuan de Tencent, HunYuan Turbo S proporcionará en el futuro capacidades básicas para modelos derivados de inferencia, textos largos y código. Basándose en Turbo S, Tencent también lanzó el modelo de inferencia T1 con capacidad de pensamiento profundo, que ya está implementado en Tencent Yuanbao y pronto ofrecerá servicios de acceso a través de API.

Actualmente, los desarrolladores y usuarios empresariales pueden acceder a HunYuan Turbo S a través de la API en el sitio web oficial de Tencent Cloud y disfrutar de una prueba gratuita de una semana. El precio del modelo es de 0,8 yuanes/millón de tokens de entrada y 2 yuanes/millón de tokens de salida, una reducción significativa de precio en comparación con el modelo HunYuan Turbo anterior. Además, HunYuan Turbo S se lanzará gradualmente en Tencent Yuanbao, donde los usuarios podrán seleccionar el modelo "Hunyuan" y desactivar la función de pensamiento profundo para probarlo.

Solicitud de prueba gratuita de la API del modelo Tencent HunYuan Turbo S: https://cloud.tencent.com/apply/p/i2zophus2x8