En el rápido desarrollo de la tecnología de Inteligencia Artificial (IA), el equipo de DeepSeek ha lanzado su nuevo sistema de inferencia DeepSeek-V3/R1. Este sistema está diseñado para impulsar el desarrollo eficiente de la IA General (AGI) mediante un mayor rendimiento y una menor latencia. Para lograr este objetivo, DeepSeek emplea la técnica de paralelismo de expertos entre nodos (Expert Parallelism, EP), mejorando significativamente la eficiencia computacional de la GPU, expandiendo el tamaño del lote y reduciendo la latencia simultáneamente.

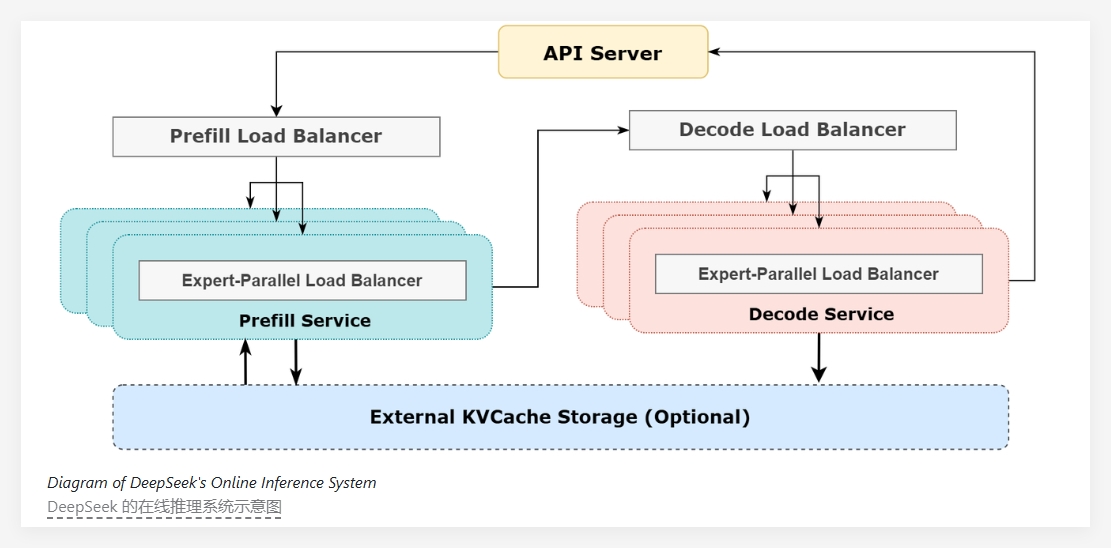

El núcleo de DeepSeek-V3/R1 radica en su alta escasez; en cada capa del modelo solo se activan 8 de los 256 expertos. Por lo tanto, se necesita un tamaño de lote muy grande para asegurar que cada experto tenga suficiente capacidad de procesamiento. La arquitectura del sistema utiliza un método de desagregación de prellenado y decodificación (prefill-decode disaggregation), empleando diferentes estrategias de paralelismo en las fases de prellenado y decodificación.

En la fase de prellenado, el sistema utiliza una estrategia de superposición de doble lote para ocultar el costo de comunicación. Esto significa que mientras se procesa un lote de solicitudes, el costo de comunicación del siguiente lote puede ser ocultado por el proceso de cálculo, mejorando así el rendimiento general. En la fase de decodificación, para abordar el problema del desequilibrio temporal en las diferentes etapas de ejecución, DeepSeek emplea una canalización de cinco etapas, logrando una superposición perfecta entre comunicación y cálculo.

Para hacer frente al problema de la carga desigual causada por el paralelismo a gran escala, el equipo de DeepSeek ha establecido múltiples equilibradores de carga. Estos equilibradores de carga se dedican a equilibrar la carga de cálculo y comunicación entre todas las GPU, evitando que una sola GPU se convierta en un cuello de botella de rendimiento debido a la sobrecarga de cálculo, y asegurando la utilización eficiente de los recursos.

En cuanto al rendimiento del servicio, el servicio de inferencia DeepSeek-V3/R1 se ejecuta en GPU H800, utilizando el mismo formato de multiplicación de matrices y transmisión que el proceso de entrenamiento. Según los últimos datos estadísticos, el sistema ha procesado 608 mil millones de tokens de entrada en las últimas 24 horas, con una ocupación máxima de nodos del 278%, una ocupación diaria promedio del 226,75% y un rendimiento general satisfactorio.

El sistema de inferencia DeepSeek-V3/R1, mediante un diseño de arquitectura eficiente y una gestión inteligente de la carga, no solo mejora el rendimiento de inferencia de los modelos de IA, sino que también proporciona una sólida infraestructura de apoyo para futuras investigaciones y aplicaciones de AGI.

Proyecto:https://github.com/deepseek-ai/open-infra-index/blob/main/202502OpenSourceWeek/day_6_one_more_thing_deepseekV3R1_inference_system_overview.md

Puntos clave:

🌟 El sistema de inferencia DeepSeek-V3/R1 logra un mayor rendimiento y una menor latencia mediante la técnica de paralelismo de expertos entre nodos.

📊 Emplea una estrategia de superposición de doble lote y una canalización de cinco etapas para mejorar la eficiencia del cálculo y optimizar el proceso de comunicación.

🔄 Establece múltiples equilibradores de carga para asegurar la utilización eficiente de los recursos entre las GPU y evitar cuellos de botella de rendimiento.