El 11 de marzo, el equipo del laboratorio Tongyi anunció la publicación de código abierto del modelo R1-Omni, un avance significativo en el desarrollo de modelos multimodales. Este modelo combina el aprendizaje por refuerzo con recompensas verificables (RLVR) para mejorar la capacidad de razonamiento y el rendimiento de generalización en tareas de reconocimiento de emociones multimodales.

El entrenamiento de R1-Omni se divide en dos fases. En la fase de arranque en frío, el equipo utiliza un conjunto de datos combinado que incluye 580 videos, provenientes de los conjuntos de datos EMER (Explainable Multimodal Emotion Reasoning) y HumanOmni. Esta fase tiene como objetivo establecer las capacidades de razonamiento básicas del modelo, asegurando que tenga una cierta capacidad de reconocimiento de emociones multimodales antes de entrar en la fase RLVR, garantizando así la suavidad, eficiencia y estabilidad del entrenamiento posterior.

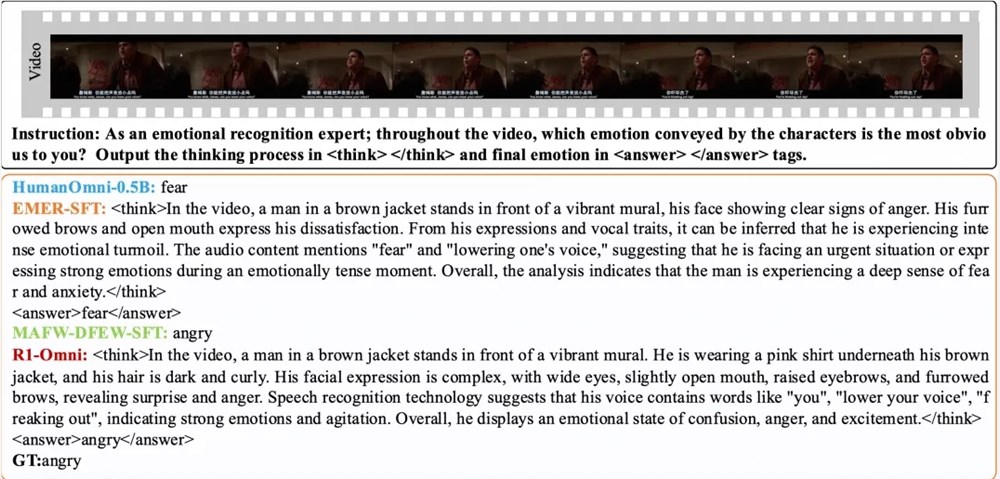

Posteriormente, en la fase RLVR, el modelo se optimiza aún más mediante el aprendizaje por refuerzo y un mecanismo de recompensa verificable. La clave de esta fase reside en el modelo de política y la función de recompensa. El modelo de política procesa los datos de entrada multimodales compuestos por fotogramas de video y flujo de audio, generando respuestas candidatas con un proceso de razonamiento detallado, mostrando cómo el modelo integra la información visual y auditiva para llegar a una predicción. La función de recompensa, inspirada en DeepSeek R1, se divide en una recompensa de precisión y una recompensa de formato, que juntas forman la recompensa final, incentivando al modelo a generar predicciones correctas y asegurando que la salida sea estructurada y cumpla con el formato preestablecido.

Los resultados experimentales muestran que R1-Omni, en los conjuntos de prueba de distribución similar DFEW y MAFW, supera en más del 35% al modelo base original, y en más del 10% al modelo de ajuste fino supervisado (SFT) en la tasa de recuperación promedio no ponderada (UAR). En el conjunto de prueba de distribución diferente RAVDESS, tanto la tasa de recuperación promedio ponderada (WAR) como la UAR mejoran en más del 13%, mostrando una excelente capacidad de generalización. Además, R1-Omni presenta una ventaja significativa en transparencia; a través del método RLVR, el papel de la información de audio y video en el modelo se vuelve más claro y visible, mostrando claramente el papel clave de la información de cada modalidad en el juicio de emociones específicas, proporcionando una referencia importante para comprender el proceso de toma de decisiones del modelo y para futuras investigaciones.

Artículo:

https://arxiv.org/abs/2503.05379

Github:

https://github.com/HumanMLLM/R1-Omni

Modelo:

https://www.modelscope.cn/models/iic/R1-Omni-0.5B