En el campo de la inteligencia artificial, el equipo de Alibaba Tongyi Lab ha anunciado recientemente la publicación de código abierto de su último modelo multimodal: R1-Omni. Este modelo, que combina el aprendizaje por refuerzo con métodos de recompensa verificable (RLVR), demuestra una capacidad excepcional en el procesamiento de información de audio y vídeo. El punto fuerte de R1-Omni radica en su transparencia, lo que permite una comprensión más clara del papel de cada modalidad en el proceso de toma de decisiones, especialmente en tareas como el reconocimiento de emociones.

Con el lanzamiento de DeepSeek R1, se está explorando continuamente el potencial del aprendizaje por refuerzo en la aplicación de modelos grandes. El método RLVR aporta nuevas ideas de optimización para tareas multimodales, pudiendo gestionar eficazmente tareas complejas como la inferencia geométrica y el recuento visual. Aunque la mayor parte de la investigación se centra en la combinación de imágenes y texto, la última exploración de Tongyi Lab amplía este campo, combinando RLVR con un modelo multimodal de vídeo, mostrando así el amplio espectro de aplicaciones de la tecnología.

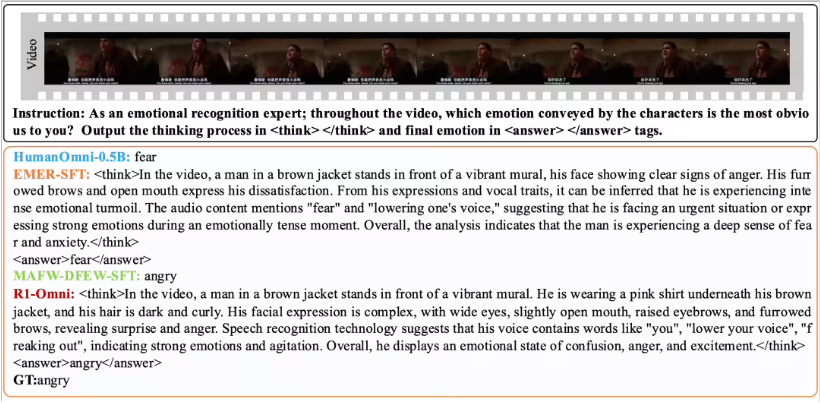

R1-Omni, a través del método RLVR, hace que la influencia de la información de audio y vídeo sea más intuitiva. Por ejemplo, en tareas de reconocimiento de emociones, el modelo puede mostrar claramente qué señales de audio y vídeo han jugado un papel clave en la determinación de la emoción. Esta transparencia no solo mejora la fiabilidad del modelo, sino que también proporciona a investigadores y desarrolladores una mejor comprensión.

En cuanto a la verificación del rendimiento, el equipo de Tongyi Lab realizó experimentos comparativos entre R1-Omni y el modelo original HumanOmni-0.5B. Los resultados muestran que R1-Omni ha mejorado significativamente en los conjuntos de datos DFEW y MAFW, con un aumento medio de más del 35%. Además, en comparación con los modelos tradicionales de ajuste fino supervisado (SFT), R1-Omni también ha mejorado en más del 10% en el aprendizaje no supervisado (UAR). En conjuntos de prueba de diferentes distribuciones (como RAVDESS), R1-Omni ha demostrado una excelente capacidad de generalización, con mejoras en WAR y UAR de más del 13%. Estos resultados no solo demuestran las ventajas de RLVR en la mejora de la capacidad de razonamiento, sino que también proporcionan nuevas ideas y direcciones para futuras investigaciones en modelos multimodales.

La publicación de código abierto de R1-Omni facilitará el trabajo de muchos investigadores y desarrolladores, y se espera que este modelo aporte más innovaciones y avances en sus futuras aplicaciones.