El CEO de Google, Sundar Pichai, anunció en una conferencia de prensa el lanzamiento de código abierto de Gemma-3, su nuevo modelo multimodal de gran tamaño. Este modelo se caracteriza por su bajo coste y alto rendimiento, atrayendo gran atención.

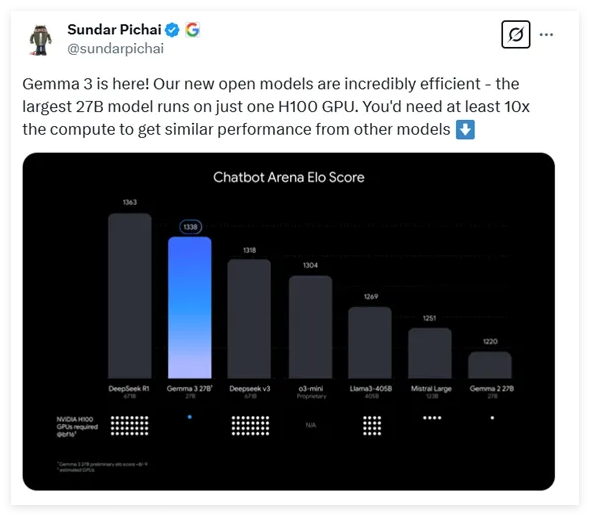

Gemma-3 ofrece cuatro opciones con diferentes escalas de parámetros: 1.000 millones, 4.000 millones, 12.000 millones y 27.000 millones. Sorprendentemente, el modelo de 27.000 millones de parámetros, el mayor, solo necesita una tarjeta gráfica H100 para una inferencia eficiente, mientras que modelos similares suelen requerir diez veces más potencia de cálculo. Esto convierte a Gemma-3 en uno de los modelos de alto rendimiento con menor demanda de recursos computacionales en la actualidad.

Según los últimos datos de prueba, Gemma-3 ha demostrado un rendimiento notable en las comparativas de modelos de conversación, situándose solo por detrás del reconocido modelo DeepSeek y superando a otros modelos populares como o3-mini de OpenAI y Llama3.

La arquitectura de Gemma-3, lanzada en esta ocasión, continúa con el diseño del transformador decodificador universal de las dos generaciones anteriores, pero incorpora numerosas innovaciones y optimizaciones. Para abordar los problemas de memoria derivados de los contextos largos, Gemma-3 emplea una arquitectura que entrelaza capas de autoatención locales y globales, reduciendo significativamente el consumo de memoria.

En cuanto a la capacidad de procesamiento de contexto, Gemma-3 admite una longitud de contexto extendida a 128K tokens, lo que proporciona una mejor compatibilidad con el procesamiento de textos largos. Además, Gemma-3 posee capacidades multimodales, pudiendo procesar simultáneamente texto e imágenes, e integra un codificador visual basado en VisionTransformer, lo que reduce eficazmente el coste computacional del procesamiento de imágenes.

Durante el entrenamiento, Gemma-3 utilizó un mayor presupuesto de tokens, especialmente en el modelo de 27.000 millones de parámetros, donde se utilizaron 14T de tokens. También se incorporaron datos multilingües para mejorar la capacidad de procesamiento del lenguaje del modelo, admitiendo 140 idiomas, de los cuales 35 se pueden utilizar directamente.

Gemma-3 empleó técnicas avanzadas de destilación del conocimiento y, en la fase final del entrenamiento, se optimizó su rendimiento mediante aprendizaje por refuerzo, especialmente en aspectos como la capacidad de ayuda, el razonamiento y las capacidades multilingües, mostrando mejoras significativas.

Tras las evaluaciones, Gemma-3 ha demostrado un excelente rendimiento en tareas multimodales y una impresionante capacidad de procesamiento de textos largos, alcanzando una precisión del 66%. Además, en la evaluación de la capacidad de conversación, Gemma-3 se situó entre los mejores, mostrando su sólida capacidad en diversas tareas.

Dirección: https://huggingface.co/collections/google/gemma-3-release-67c6c6f89c4f76621268bb6d

Puntos clave:

🔍 Gemma-3 es el último modelo multimodal de gran tamaño de código abierto de Google, con un rango de parámetros de 1.000 millones a 27.000 millones y una reducción de la demanda de potencia de cálculo de 10 veces.

💡 El modelo utiliza un diseño de arquitectura innovador que procesa eficazmente contextos largos y datos multimodales, admitiendo el procesamiento simultáneo de texto e imágenes.

🌐 Gemma-3 admite el procesamiento de 140 idiomas y, tras la optimización del entrenamiento, ha demostrado un rendimiento excelente en múltiples tareas, mostrando una potente capacidad integral.