En la conferencia GTC2025, Nvidia anunció oficialmente su próxima plataforma de chips de inteligencia artificial (IA), nombrada "Vera Rubin" en honor a la famosa astrónoma estadounidense Vera Rubin, continuando la tradición de Nvidia de nombrar sus arquitecturas con nombres de científicos. Se espera que el primer producto de esta serie, Vera Rubin NVL144, se lance en la segunda mitad de 2026.

El director ejecutivo de Nvidia, Jensen Huang, afirmó que el rendimiento de Rubin alcanzará las 900 veces el de la arquitectura Hopper actual. En comparación, la arquitectura Blackwell más reciente ya ha logrado una mejora de rendimiento 68 veces superior a Hopper, lo que indica que Rubin traerá un enorme salto en la potencia de cálculo.

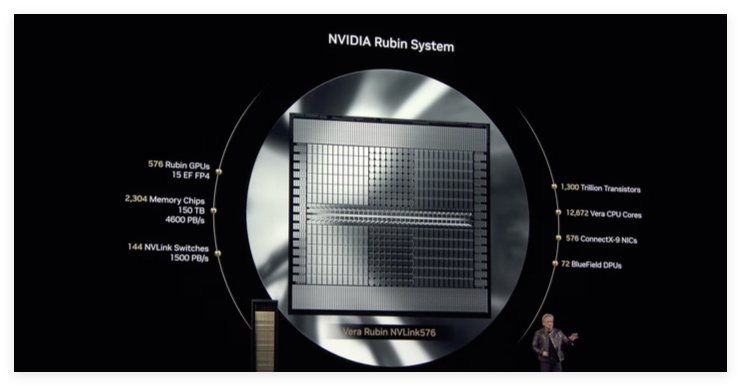

Según la información oficial, Vera Rubin NVL144 tiene una potencia de cálculo de inferencia de hasta 3,6 ExaFLOPS en precisión FP4 y un rendimiento de entrenamiento de 1,2 ExaFLOPS en precisión FP8. En comparación con GB300NVL72, el rendimiento ha mejorado 3,3 veces. Rubin incorporará la memoria HBM4 más reciente, con un asombroso ancho de banda de 13 TB/s, y 75 TB de memoria rápida, 1,6 veces más que la generación anterior. En cuanto a la interconexión, Rubin admite NVLink6 y CX9, con anchos de banda de 260 TB/s y 28,8 TB/s respectivamente, el doble que la generación anterior.

El chip Rubin estándar estará equipado con memoria HBM4, y su rendimiento general superará con creces el del actual chip Hopper H100 de gama alta.

Cabe destacar que la plataforma Rubin también introducirá una nueva CPU llamada Veru, sucesora de la CPU Grace. Veru contiene 88 núcleos Arm personalizados, cada uno con soporte para 176 hilos, y utiliza NVLink-C2C para lograr una conexión de alto ancho de banda de hasta 1,8 TB/s. Nvidia afirma que la velocidad de la CPU Vera personalizada será el doble que la de la CPU utilizada en el chip Grace Blackwell del año pasado.

Cuando se utiliza con la CPU Vera, Rubin puede alcanzar una potencia de cálculo de 50 petaflops en tareas de inferencia, más del doble de los 20 petaflops de Blackwell. Además, Rubin admitirá hasta 288 GB de memoria HBM4, lo cual es crucial para los desarrolladores que necesitan procesar modelos de IA de gran tamaño.

Similar a Blackwell, Rubin está compuesto por dos GPU que se integran en un solo conjunto mediante una tecnología de encapsulado avanzada, lo que mejora aún más la eficiencia y el rendimiento generales del cálculo. El lanzamiento de Rubin demuestra una vez más la poderosa capacidad de innovación de Nvidia en el campo de los chips de IA y su profunda comprensión de las futuras necesidades de potencia de cálculo.