Google DeepMind realizó el primer estudio sobre las aplicaciones maliciosas más comunes de la IA, y los resultados muestran que las “Deepfakes”, inteligencias artificiales (IA) que generan imágenes falsas de políticos y celebridades, son más comunes que los intentos de ciberataques asistidos por IA. Este estudio es una colaboración entre DeepMind, la división de IA de Google, y Jigsaw, una unidad de investigación y desarrollo de Google, con el objetivo de cuantificar los riesgos de las herramientas generativas de IA que las compañías tecnológicas más grandes del mundo están lanzando al mercado en busca de enormes beneficios.

Motivaciones de los actores maliciosos relacionados con la tecnología

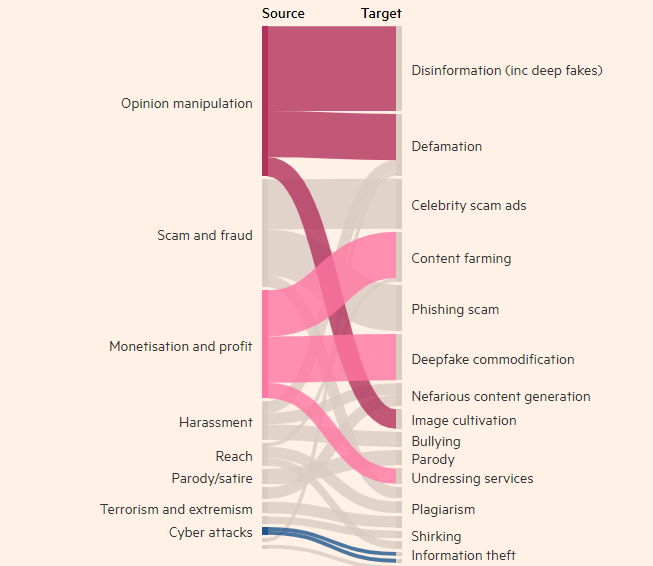

El estudio encontró que la creación de imágenes, videos y audios realistas pero falsos es, con mucho, el uso más frecuente de las herramientas generativas de IA, casi el doble que el segundo uso más común, que es la falsificación de información usando herramientas de texto (como chatbots). El objetivo más común del mal uso de la IA generativa es influir en la opinión pública, representando el 27% de los casos, lo que genera preocupación sobre cómo las Deepfakes podrían afectar las elecciones mundiales de este año.

En los últimos meses, han aparecido Deepfakes del primer ministro británico Rishi Sunak y otros líderes mundiales en TikTok, X e Instagram. Los votantes británicos acudirán a las urnas en las elecciones de la próxima semana. A pesar de los esfuerzos de las plataformas de redes sociales para etiquetar o eliminar este tipo de contenido, es posible que la gente no lo reconozca como falso, y la difusión del contenido podría influir en el voto de los electores. Los investigadores de DeepMind analizaron aproximadamente 200 casos de mal uso, que incluían las plataformas de redes sociales X y Reddit, así como blogs en línea e informes de medios de comunicación sobre el mal uso.

El estudio encontró que la segunda motivación más común para el mal uso de productos de IA generativa (como ChatGPT de OpenAI y Gemini de Google) es el lucro, ya sea ofreciendo servicios para crear Deepfakes o utilizando la IA generativa para crear grandes cantidades de contenido, como artículos de noticias falsos. El estudio encontró que la mayoría de los casos de mal uso utilizan herramientas fácilmente accesibles, "que requieren un mínimo de conocimientos técnicos", lo que significa que un mayor número de actores maliciosos pueden abusar de la IA generativa.

El estudio de DeepMind influirá en la mejora de la seguridad de sus modelos de evaluación, y espera que también influya en cómo sus competidores y otras partes interesadas perciben la "manifestación de los daños".

Puntos clave:

- 👉 El estudio de DeepMind encontró que las Deepfakes son el principal problema en el mal uso de las aplicaciones de inteligencia artificial.

- 👉 El objetivo más común del mal uso de las herramientas de IA generativa es influir en la opinión pública, representando el 27% de los casos.

- 👉 La segunda motivación más común para el mal uso de la IA generativa es el lucro, principalmente a través de la oferta de servicios de Deepfakes y la creación de noticias falsas.