Recientemente, el equipo de Yan Shuicheng de Kunlun Wanwei (China) y el equipo de investigación de la Universidad Tecnológica de Nanyang (Singapur) publicaron un proyecto llamado Q*, cuyo objetivo es mejorar la capacidad de razonamiento de los modelos pequeños. Este proyecto difiere de OpenAI, pero permite que los modelos pequeños alcancen una capacidad de razonamiento comparable a la de modelos con parámetros decenas o incluso cientos de veces mayores.

Los resultados experimentales del algoritmo Q* han sido notables: en el conjunto de datos GSM8K, Q* ayudó a Llama-2-7b a alcanzar una precisión del 80.8%, superando a ChatGPT.

En el conjunto de datos MATH, Q* ayudó a DeepSeek-Math-7b a alcanzar una precisión del 55.4%, superando a Gemini Ultra.

En el conjunto de datos MBPP, Q* ayudó a CodeQwen1.5-7b-Chat a alcanzar una precisión del 77.0%, reduciendo la brecha en capacidad de programación con GPT-4. Estos resultados muestran el potencial del algoritmo Q* para mejorar la capacidad de razonamiento de los modelos pequeños.

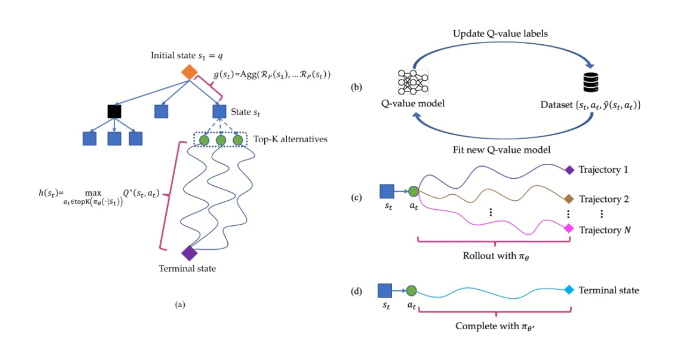

El algoritmo Q* funciona descomponiendo la trayectoria de razonamiento de un modelo de lenguaje grande en varios estados, planificando cada estado exhaustivamente y utilizando el algoritmo de búsqueda A* para realizar una búsqueda prioritaria de tareas de razonamiento complejas. Simultáneamente, entrenaron un modelo de valor Q proxy mediante aprendizaje supervisado para obtener el valor Q óptimo para cada par estado-acción, mejorando así el rendimiento del modelo.

Puntos clave:

🔍 El proyecto Q* no fue publicado por OpenAI; gracias al algoritmo del equipo de investigación, la capacidad de razonamiento de los modelos pequeños ha mejorado significativamente.

🔍 El proyecto ha obtenido resultados experimentales notables en varios conjuntos de datos, demostrando el potencial y la eficacia del algoritmo Q*.

🔍Enlace del artículo: https://arxiv.org/abs/2406.14283